标签:过程 解释 img 大量 特征 12月 配置 迭代 mina

目录

热度:2016年发表,2018年12月引用量约500。

在此之前, Discriminative model 用于图像去噪已经取得了巨大的成功。

在这篇文章中,作者尝试了前向深度网络: Denoising convolutional neural networks (DnCNNs) 。

在此过程中,作者加入了 BN 和残差学习技巧,既加快训练速度,也提升模型性能。

引入残差学习的好处:不同图像任务,大多只区别于残差;比如加不同程度的高斯噪声。因此 DnCNNs 在多种图像去噪任务上都可以胜任。

上述思路,在2016年还行得通。但在深度学习泛滥的今天,骨头汤里的肉已经被吃完了,只剩骨头了。因此,单纯增加深度和引入结构性设计,是很难作为创新点的。

由贝叶斯学派的观点,对于图片去噪,当似然已知时,图像的先验就是决定性因素。

事实上,过去多年内,许多人都在朝这一方向努力。如 nonlocal self-similarity (NSS) models ,稀疏模型等。

但它们都有两个共同缺点:

后人做了一些改进,着力于取代测试阶段复杂的迭代优化过程。然而,它们的性能仍然受到先验类别的局限。具体来说,它们对特征的挖掘存在局限,并且包含了大量手工设计的参数。

事实上,这也是大多数传统方法和深度学习方法相比较的劣势。深度学习方法可解释性不佳,但是很少需要人工介入,也很强大。

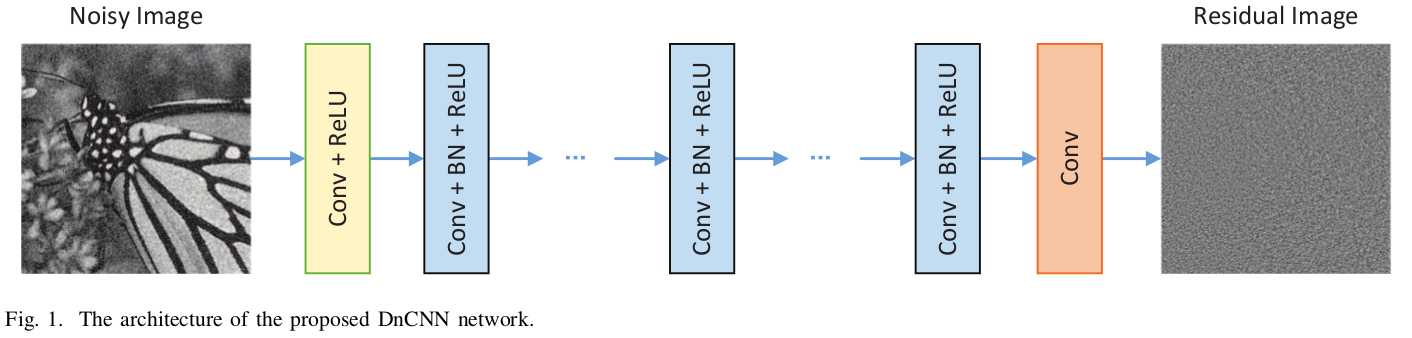

网络结构是简单的一条流水线:前面只用了简单 CNN 和 ReLU 激活单元,中间用 CNN Plus BN 加速训练,最后 CNN 输出。

整体上是学习残差。

该网络对比前任的优点还有:通过简单的零插值,就可以使输入、输出尺寸相同,避免了 Boundary artifacts 。

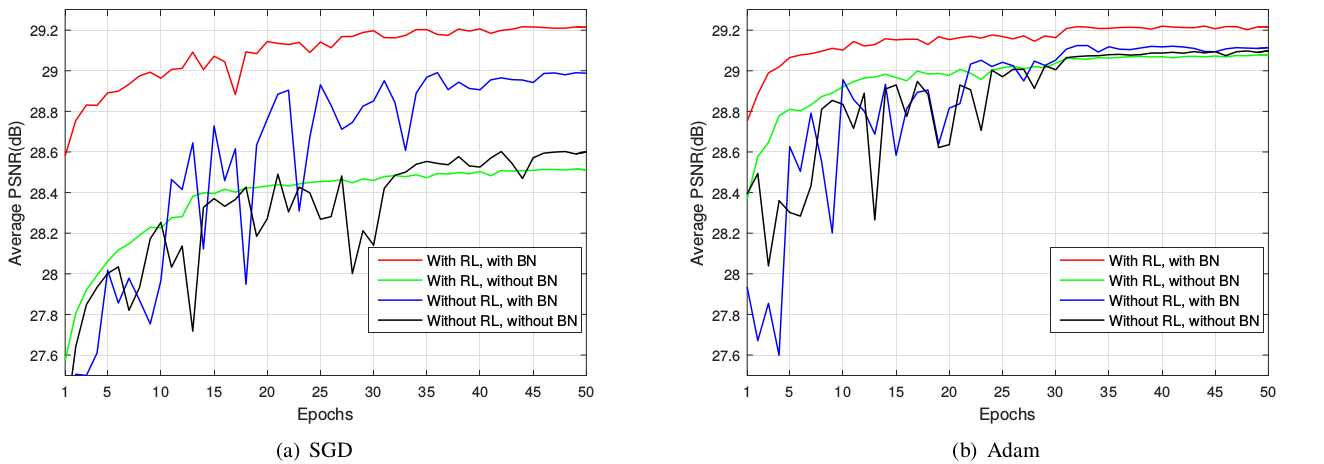

由于结构性创新是重点,因此作者比较了不同配置下网络的性能。有趣的是, BN 和 ResLearning 缺一不可,否则性能可能不如传统方法。

最后,为了实现所谓的多任务,作者在训练集中掺入不同噪声的训练样本, JPEG 压缩图像 或 降采样图像。实验表明,这样训练出来的单一模型,仍然可以胜任多任务。

标签:过程 解释 img 大量 特征 12月 配置 迭代 mina

原文地址:https://www.cnblogs.com/RyanXing/p/10125700.html