标签:变量 pre des 价格 img white 技术分享 输入 bubuko

引例:以房价和房屋面积作为训练集,学习如何预测房价

假设函数和房屋价格的实际价格的差值,差值越小损失越小

均方误差(MSE) = ∑(h(x)-y)^2/m

= ∑(w1x + b -y)^2/m

=J(w1, b), 其中 x∈(1, m)

即求一组w1,b使J(w1, b)(MSE)最小

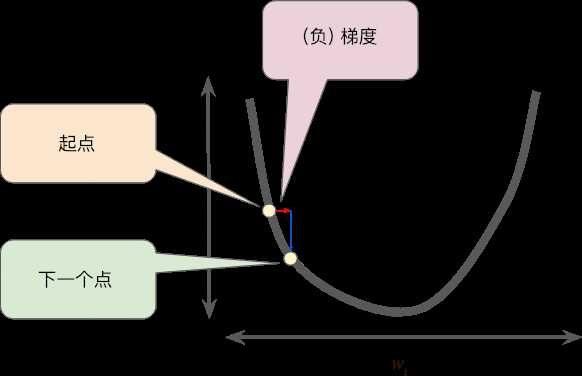

对于J(w1, b)初始化选择任意w1,b,慢慢改变w1,b的值使得J(w1, b)取得最小值或者局部最小值

梯度下降w1的值变化: w1 := w1 - aJ(w1,b)’, 对于此方程当J(w1,b)’ 为0时w1不变,即找到最小值或者局部最小值

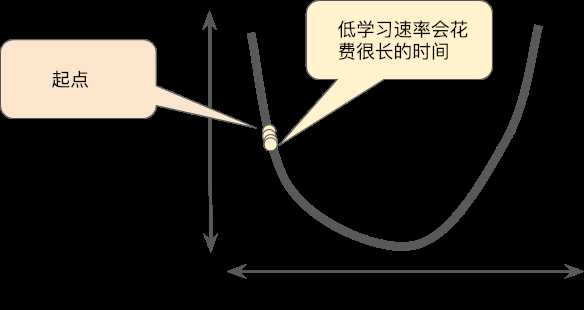

学习速率过小

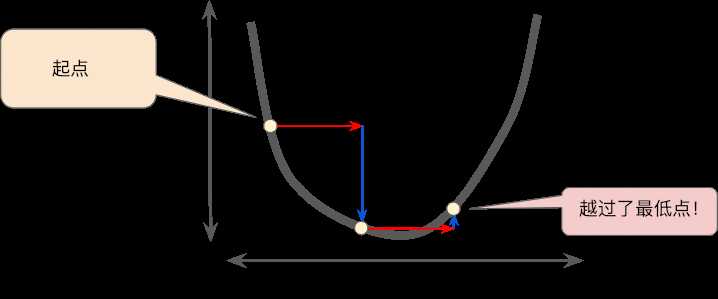

学习速率过大

结合假设函数、损失函数、梯度下降函数

得出线性回归算法:

W1和b同时更新

标签:变量 pre des 价格 img white 技术分享 输入 bubuko

原文地址:https://www.cnblogs.com/jp-mao/p/10163141.html