标签:结合 就是 image 关于 神经元 htm 课程 stanford height

Lecture 6 神经网络一

课程内容记录:

(上)https://zhuanlan.zhihu.com/p/21462488?refer=intelligentunit

(下)https://zhuanlan.zhihu.com/p/21513367?refer=intelligentunit

1.视频弹幕中关于课堂例子的解释:

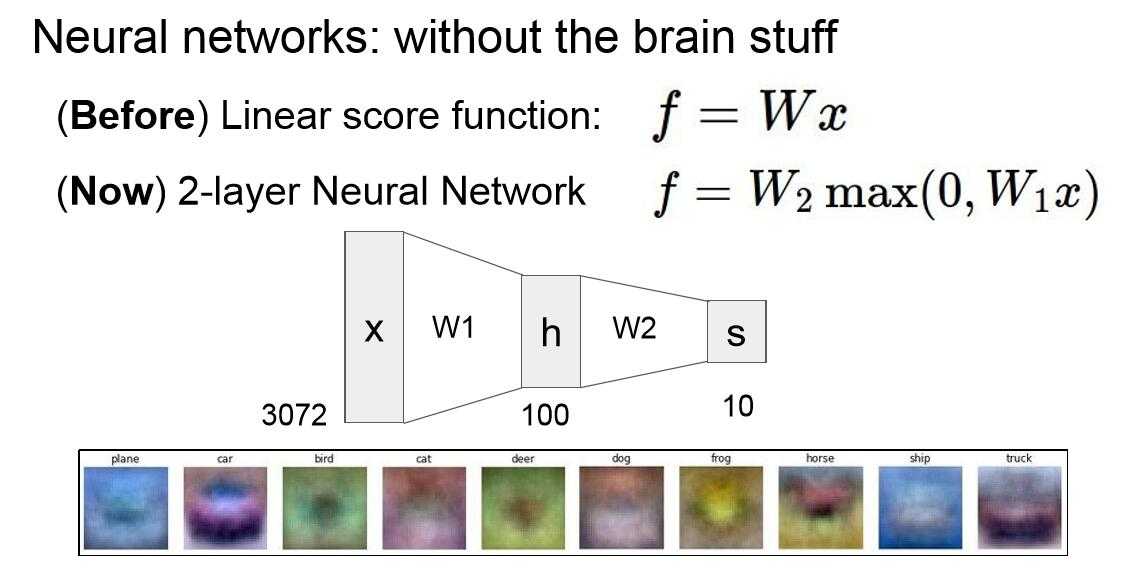

1:我们通过学习训练集得到权重W1,对应于可以识别一些feature的模板。

2:输入新的数据X,结合W1,计算得到一个得分score(中间过程可能会再经过一些非线性变换),也就是h,这里的h是学习到的一百种模板的得分。

3:得到h后,由于一个类别可能对应于多个模板(template)或者多个feature,比如面朝中间的马可能会在面朝左和面朝右两个模板中拥有同样的分值,而在面朝前的模板中得分更高。我们用W2作为权重对这些同一类别的不同模板对应的得分进行运算(比如将分值累加或者将面朝前的feature对应的分值进一步放大后累加)得到最后的Score:S。S就对应最终分类的最后得分。

注:特征提取的过程往往是要用到非线性变换的,而之后的过程主要是将同一类别不同feature对应的分值合并,线性变换即可满足要求。

2.ConvNetsJS demo:

https://cs.stanford.edu/people/karpathy/convnetjs/demo/classify2d.html

调节不同层数和神经元数目,对于了解层数和每层神经元数目对分类速度和分类结果的影响有很好的帮助。其中参数l2_decay即为L2 regularization,即正则化强度。

标签:结合 就是 image 关于 神经元 htm 课程 stanford height

原文地址:https://www.cnblogs.com/yun-an/p/10163161.html