标签:ati ext 关系 理解 center 记忆 隐藏 权重 参数形式

在DNN中,当前输出层的值只和当前输入值有关系。如果当前输出值不仅依赖当前输入值,也依赖于前面时刻的输入值,那么DNN就不适用了。因此也就有了RNN。

其中Xt是t时刻的输入,S是隐藏层。Ot是t时刻的输出。隐藏层St是由前t-1个时刻的隐藏层叠加而成的。把St也可以理解为前t时刻x的记忆叠加而成的隐藏层。

1、记

其中σs为激活函数。W是隐藏层S上的权重,如上式所示,作用跟输入一起来迭代S。

2、

其中σt为激活函数

ot为t时刻的输出也是叠加了了t-1之前时刻输入的输出

U为输入层的权重

V为隐藏层到输出层的权重

为了学习,假设σs为tanh函数,σt为softmax函数。

求参的过程还是和大多数学过的模型求参一样,列出损失函数,例如MSE,交叉熵等,然后用最大似然估计求参数形式,再用SGD随机梯度下降求解。

这里面需要求U、W、V。

1、

2、

3、损失函数,在图中,在unfold里面,由于每一点都有一个o,因此每一点都有一个损失。因此总的损失就是每一点损失之和。

4、记

oh为模型输出值,没有上标h的o为真实值。

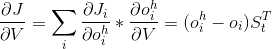

5、对V求导

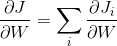

6、对W求导。

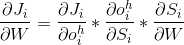

(1)

(2)

(3)由于

(4)为了解下计算过程,简单起见,设i=2

以次类推。

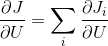

7、对U求导

(1)

(2)

8、有了每个参数的梯度,然后利用SGD可以更新参数了。

标签:ati ext 关系 理解 center 记忆 隐藏 权重 参数形式

原文地址:https://www.cnblogs.com/ylxn/p/10229491.html