标签:区域 优化 ima class play 针对 lin rect line

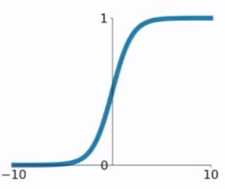

\[ \sigma(x)=\frac{1}{1+e^{-x}} \]

sigmod函数的输出值再(0,1)这个开区间中,经常被用来映射为概率值。

sigmod函数作为激活函数曾经比较流行。

缺陷

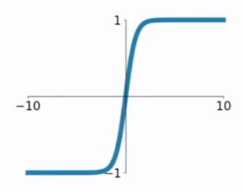

tf.sigmoid(x, name=None)\[ 双曲正弦函数=\tanh(x)=\frac{sinh(x)}{cosh(x)}=\frac{e^x-e^{-x}}{e^x+e^{-x}} \]

sigmod函数的输出值在(-1,1)这个开区间中,而且整个函数是以0为中心的,这个特点比sigmod的好。

缺陷

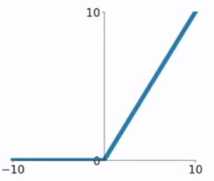

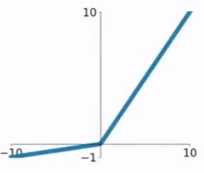

tf.tanh(x, name=None)\[ \sigma(x)=,max(0,x) \]

ReLU(Rectified Linear Unit)函数是目前比较火的一个激活函数

1.输入为正数的时候,不存在梯度饱和问题。

2.不存在指数运算,计算速度要快很多

缺陷

tf.nn.relu(

features,

name=None

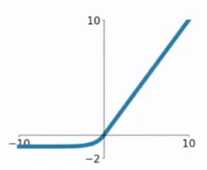

)\[ f(x)=\begin{cases} x &x>0 \\ \alpha(e^x-1) &x<=0 \end{cases} \]

相比于ReLU函数,在输入为负数的情况下,是有一定的输出的,而且这部分输出还具有一定的抗干扰能力。这样可以消除ReLU死掉的问题,不过还是有梯度饱和和指数运算的问题。

tf.nn.elu(features, name=None)\[ f(x)=max(ax,x) \]

PReLU也是针对ReLU的一个改进型,在负数区域内,PReLU有一个很小的斜率,这样也可以避免ReLU死掉的问题。相比于ELU,PReLU在负数区域内是线性运算,斜率虽然小,但是不会趋于0,这算是一定的优势吧。

我们看PReLU的公式,里面的参数α一般是取0~1之间的数,而且一般还是比较小的,如零点零几。当α=0.01时,我们叫PReLU为Leaky ReLU,算是PReLU的一种特殊情况吧。

标签:区域 优化 ima class play 针对 lin rect line

原文地址:https://www.cnblogs.com/panfengde/p/10329555.html