标签:tag value .data 本地 成功 ima https java rop

准备环境:

安装HDFS:

修改配置文件:

vi /bigdata/hadoop-2.8.5/etc/hadoop/hadoop-env.sh

添加:

export JAVA_HOME=/usr/local/jdk1.8.0_181

vi /bigdata/hadoop-2.8.5/etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdf://Node-1:9000/</value>

</property>

</configuration>

##指定namenode存储元数据的本地目录:

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/bigdata/hdpdata/name</value>

</property>

##指定datanode软件存放文件块的本地目录

<property>

<name>dfs.datanode.data.dir</name>

<value>/bigdata/hdpdata/data</value>

</property>

</configuration>

scp -r hadoop-2.8.5/ Node-2:/bigdata/

scp -r hadoop-2.8.5/ Node-3:/bigdata/

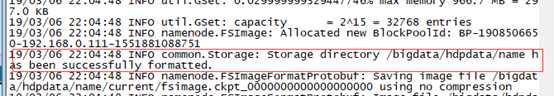

初始化namenode的工作目录:

有上述提示代表初始化成功。

启动HDFS:

web界面访问:

标签:tag value .data 本地 成功 ima https java rop

原文地址:https://www.cnblogs.com/gujianzhe/p/10492123.html