标签:hub inf 技术 随机 距离 相同 重要性 mac 条件

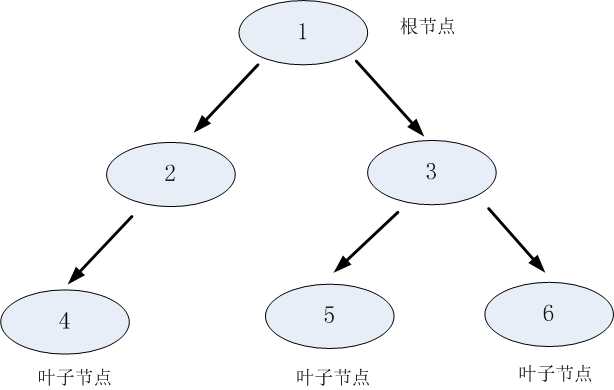

互斥完备性:是决策树路径的重要性质。即每一个实例都被一条路径或一条规则所覆盖,而且只被一条路径或一条规则所覆盖。

(1)信息增益

信息增益:待分类的数据集合的熵和选定某个特征的条件熵之差。信息增益是样本集合纯度最常用的一种指标,信息增益越大,则意味着使用属性a来进行划分所获得的“纯度提升”越大,即该属性特征对最终的分类结果影响也就越大。计算公式为:

$$g(D,A) = H(D) - H(D|A)$$

其中,$g(D,A)$是熵$H(D)$与条件熵$H(D|A)$之差,称为互信息,$D = {X_{1}, X_{2},...,X_{n}}$。决策树中的信息增益等价于训练数据集中类与特征的互信息。

熵:表示随机变量不确定性的度量。也称经验熵,熵越大,随机变量的不确定性就越大。假设X是一个取值有限的离散随机变量$X={x_{1},x_{2},...,x_{n}}$。对于数据集,$X$可以理解为特征属性,而${x_{1},x_{2},...,x_{n}}$表示该特征下的每个类别标签。其概率分布为:$P(X=x_{i}) = p_{i}, i =1,2,...,n$,则随机变量X的熵定义为:

$$H(X) = - \sum_{i=1}^{n} p_{i} logp_{i}$$

也可以写成$$H(p) = - \sum_{i=1}^{n} p_{i} log_{2} p_{i}$$

其中,$p_{i} = \frac{|c_{k}|}{|D|}$,因此经验条件熵也可以写成:

$$H(D) = - \sum_{i=1}^{K} \frac{|c_{k}|}{|D|} log_{2} \frac{|c_{k|}}{|D|}$$

其中D是数据集,|D|表示样本容量,即样本个数。$c_{k}$表示第k个类别标签,而$|c_{k}|$表示第k个类别的样本个数,第c个特征有K个类。

条件熵:表示在已知随机变量X的条件下随机变量Y的不确定性。也称经验条件熵,假设有随机变量$(X,Y)$,其联合概率分布为:$P(X=x_{i}, Y=y_{i}) = p_{ij}, i=1,2,..,n;j=1,2,...,m$,计算公式为:

$$H(Y|X) = \sum_{i=1}^{n} p_{i}H(Y|X=x_{i})$$

以信息增益为标准的特征选择代码在胡歌的github

(2)信息增益比

以信息增益比为标准的特征选择代码在胡歌的github

(3)基尼指数

样本集合D的基尼指数为:

$$Gini(p) = 1 - \sum_{k=1}^{K} p_{k}^{2} = 1 - \sum_{k=1}^{K} (\frac{|c_{k}|}{|D|})^{2}$$

基于特征A划分样本集合D之后的基尼指数:指某个特征值将样本集合D划分为两个子集的纯度:

$$Gini(D,A) = \frac{|D_{1}|}{|D|} Gini(D_{1}) + \frac{|D_{2}|}{|D|} Gini(D_{2})$$

输入:训练数据集D,特征集A,阈值threshold

输出:决策树T.

1.检查D中所有数据标签是否为同一类,是同一类,T直接为单节点树,并将此类标记为该结点的类标记并返回T。

2.若,则T为单结点树,并将D中实例数最大的类作为该结点的标记,返回T。

3.否则,按照特征选择方法中的信息增益(信息增益比)方法计算A中各特征的信息增益(信息增益比),选择信息增益(比)最大的特征,并检测其增益(比)是否大于阈值。

4.对大于阈值的信息增益(比)特征,对其每一个可能的值将数据集D进行分割为若干非空子集并构建子结点。

5.重复分割步骤,分割特征不包括之前已经分割过的特征,当分割后的信息增益(比)不大于阈值时,将此结点下的实例数最多的类作为此结点的标记,构成一个叶结点。参考

标签:hub inf 技术 随机 距离 相同 重要性 mac 条件

原文地址:https://www.cnblogs.com/hugechuanqi/p/10498786.html