标签:echo pre 注意 uri 目录 .com 程序 sha mapred

一、使用MapReduce的方式进行词频统计

(1)在hadoop根目录下创建input输入文件夹,这和在HDFS用户目录下创建input文件夹是两件不同的事情。

mkdir input

(2)在input文件夹中创建两个测试文件file1.txt和file2.txt。

echo "hello world" > file1.txt

echo "hello hadoop" > file2.txt

知识点延伸:

echo " hello world" > file1.txt # 表示创建file1.txt

echo "nihao" >> file1.txt # 表示往file1.txt里追加内容

echo "" > file1.txt # 表示清空file1.txt里的内容,但是文件中还存在空字符串

echo -n > file1.txt # 清除文件的所有内容,包括空字符串

参考:https://linux.cn/article-8024-1.html

(3)调用MapReduce程序对input文件夹中的文件进行词频统计

cd /usr/local/hadoop #切换到hadoop目录下

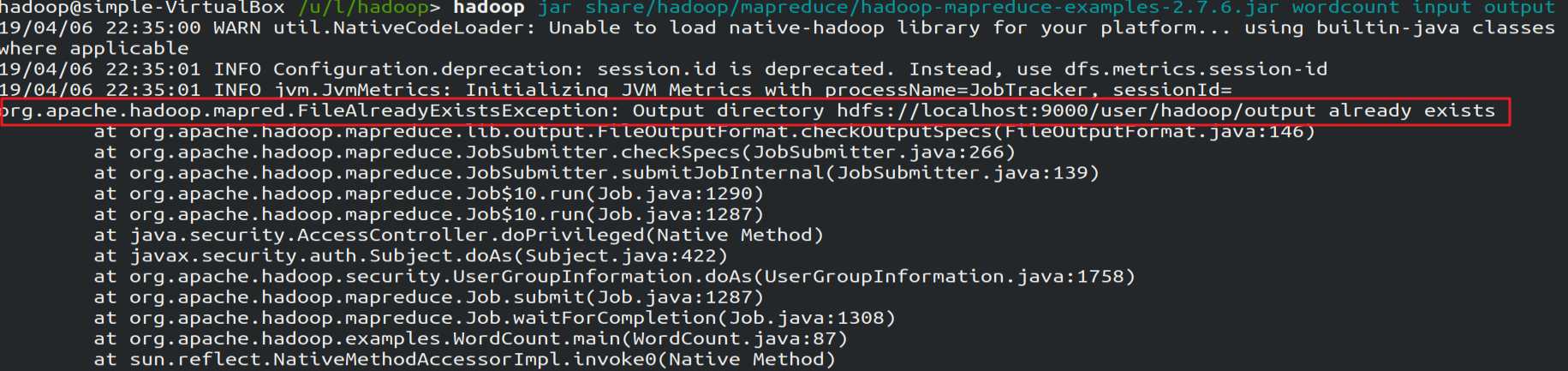

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.6.jar wordcount input output

注意:虽然输入目录是在hadoop目录下,但是自动生成的输出目录是在HDFS目录下的,如果HDFS目录下已存在output文件夹,就需要先删除,否则会出现下图所示的错误:

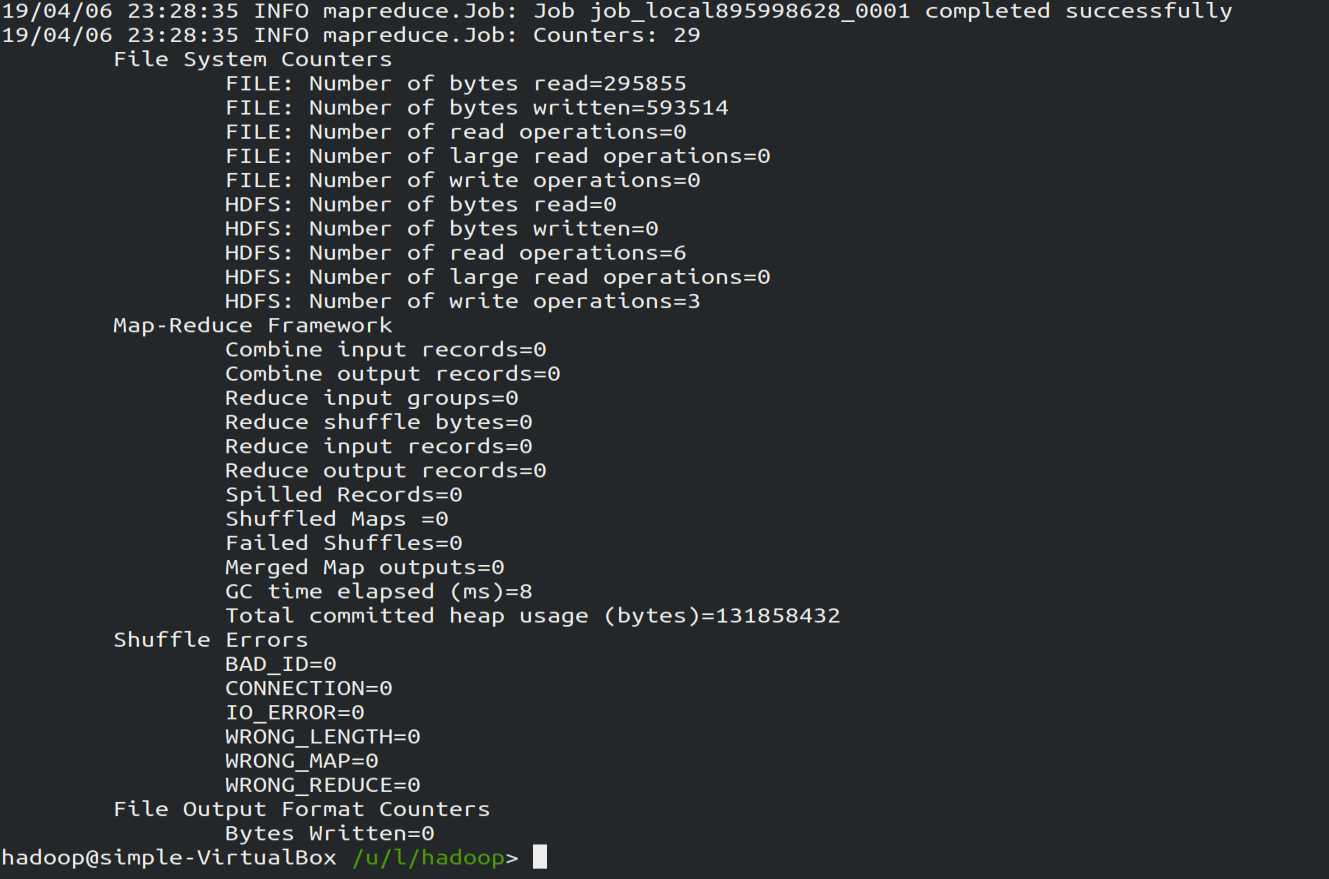

(4)执行结果

标签:echo pre 注意 uri 目录 .com 程序 sha mapred

原文地址:https://www.cnblogs.com/2sheep2simple/p/10663358.html