标签:转移 三分 任务 池化 分割 bsp 因此 pascal idt

相应连接:Arxiv

我们将当前分类网络(AlexNet, VGG net 和 GoogLeNet)修改为全卷积网络,通过对分割任务进行微调,将它们学习的表征转移到网络中。然后,我们定义了一种新的架构,它将深的、粗糙的网络层的语义信息和浅的、精细的网络层的表层信息结合起来,来生成精确和详细的分割。我们的全卷积网络在 PASCAL VOC(在2012年相对以前有20%的提升,达到了62.2%的平均IU),NYUDv2 和 SIFT Flow 上实现了最优的分割结果,对于一个典型的图像,推断只需要三分之一秒的时间。

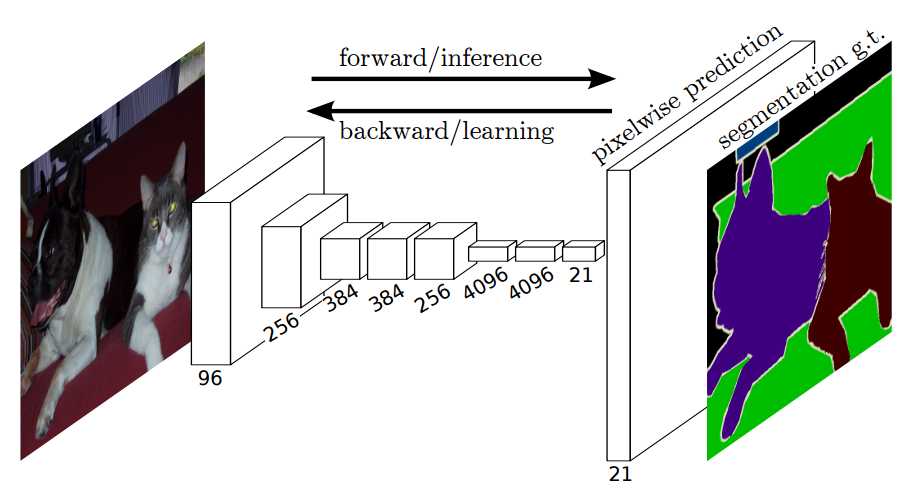

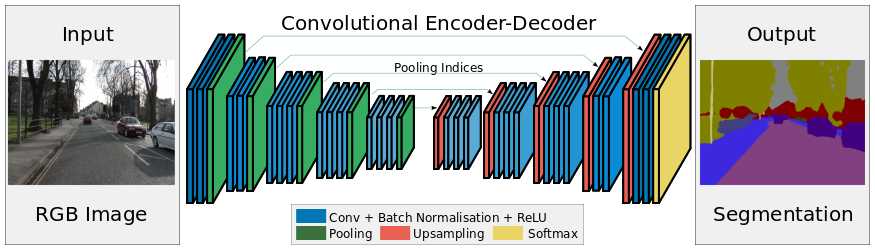

FCN端到端的密集预测流

关键点:

1、端到端预测,做pixel-wise级别的预测

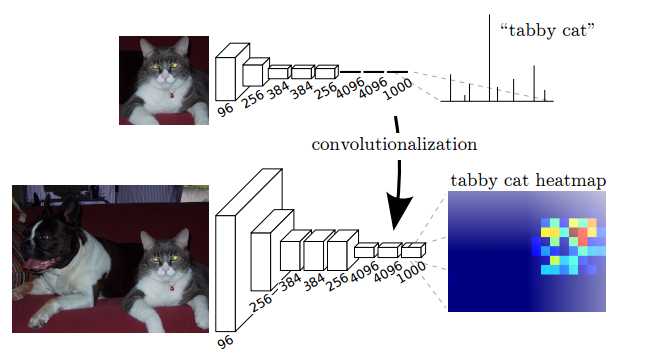

2、对AlexNet、VGG等延展(全连接层转换成全卷积层)

3、fine-tune相关的网络

4、任意输入,输出分类热力图map(因为输出类没有确定,所以可以任意输入)

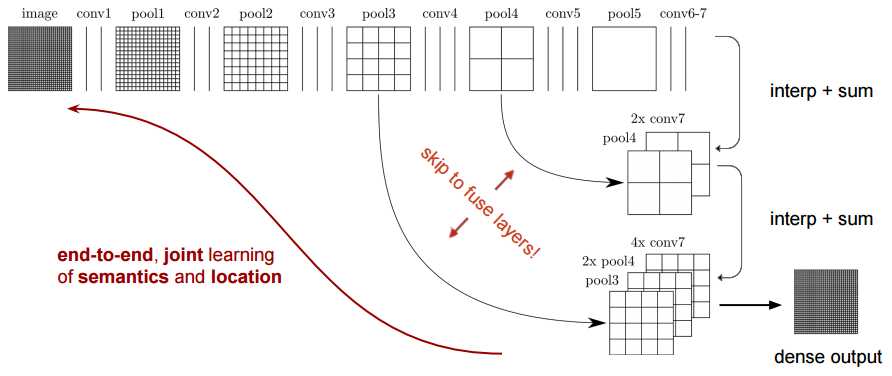

5、特征是由编码器中的不同阶段合并而成的,它们在语义信息的粗糙程度上有所不同

6、低分辨率语义特征图的上采样使用经双线性插值滤波器初始化的反卷积操作完成

第2点: 将全连接层转换成卷积层,使得分类网络可以输出一个类的热图

第5点:FCN-8s 网络架构

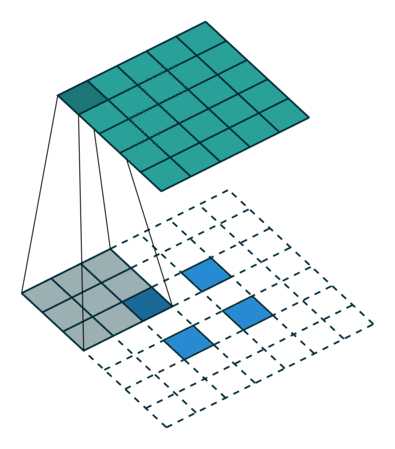

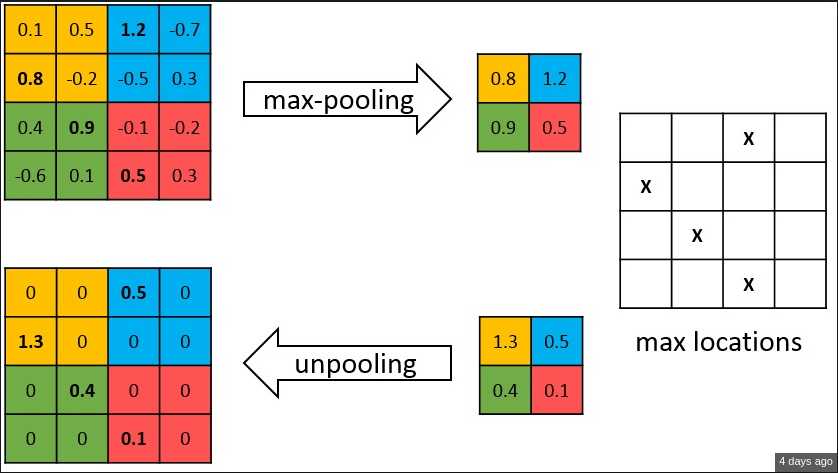

反卷积概念图

相应连接:Arxiv

SegNet 的新颖之处在于解码器对其较低分辨率的输入特征图进行上采样的方式。具体地说,解码器使用了在相应编码器的最大池化步骤中计算的池化索引来执行非线性上采样。这种方法消除了学习上采样的需要。经上采样后的特征图是稀疏的,因此随后使用可训练的卷积核进行卷积操作,生成密集的特征图。我们将我们所提出的架构与广泛采用的 FCN 以及众所周知的 DeepLab-LargeFOV,DeconvNet 架构进行比较。比较的结果揭示了在实现良好的分割性能时所涉及的内存与精度之间的权衡。

SegNet 架构

关键点:

1、在解码器中使用反池化对特征图进行上采样,并在分割中保持高频细节的完整性

2、编码器不使用全连接层(和 FCN 一样进行卷积),因此是拥有较少参数的轻量级网络

反池化

如上图所示,编码器中的每一个最大池化层的索引都被存储起来,用于之后在解码器中使用那些存储的索引来对相应的特征图进行反池化操作。虽然这有助于保持高频信息的完整性,但当对低分辨率的特征图进行反池化时,它也会忽略邻近的信息。

相应连接:

标签:转移 三分 任务 池化 分割 bsp 因此 pascal idt

原文地址:https://www.cnblogs.com/hotsnow/p/10801703.html