标签:条件 inf 开始 进入 理想 云运维 src 基础设施 code

无人化数据中心难以实现?

如图所示,大部分运维人员理想中的数据中心是这样一种干净整洁,极少人员进出的熄灯状态。作为运维人员,减少无关人员进入机房的次数对于数据中心的信息安全非常重要。

然而,理想很丰满,现实却很骨感。现实中的数据中心往往是布线混乱,电灯长明,一出问题不管紧急不紧急就有人员进出的状况。

这种情况下,一是设备数据安全得不到有力的保障,二是一旦设备出现故障又是看设备运行提示灯状态又是查看运行日志来确定故障信息以及故障位置,耗时费力。因此,很多运维人员体会过其中的辛酸之后都在默默祈祷自己管理的设备不要出现故障。

网上流传种种运维人员的夸张图片虽说是自我讽刺,但另一方面又实实在在的反映出了机房运维的心酸与无奈。

与此同时,随着数据中心的设备数量的不断增长,机房管理方面对运维人员的要求也越来越多。当设备发生故障时,运维人员不能及时响并应解决问题对企业业务会造成一定的影响。但是因为传统的故障定位过程繁杂令人头痛,所以很多时候故障告警得不到及时响应。哪怕到最后故障问题解决了,但也花费了不少的时间。

近年来IDC的市场规模

数据中心能耗过高引起重视

根据调研机构Global Market Insights(GMI)的调查报告,由于数据中心的增长和存储的信息量剧增,数据中心冷却市场发展正在呈现爆炸式的增长。当今的技术驱动型世界需要一个能够保护系统和处理器免受高温和湿度损害的环境,同时又具有成本效益和环境友好性。

GMI公司2016年的调查报告表明,全球约有80亿美元用于数据中心冷却。到2024年,这一数字预计将达到200亿美元。由于冷却设备功耗约占数据中心能耗的40%,因此对具有成本效益和节能解决方案的需求变得前所未有的重要。

绿色节能对于数据中心而言已经不是一个锦上添花的议题,而是一个必须做好的课题,因为能源成本的占比正在不断攀升。

根据美国环境保护署EPA的报告,在数据中心的运维成本之中,场地基础设施能源成本则于多年前开始超越服务器的购买和运维成本。

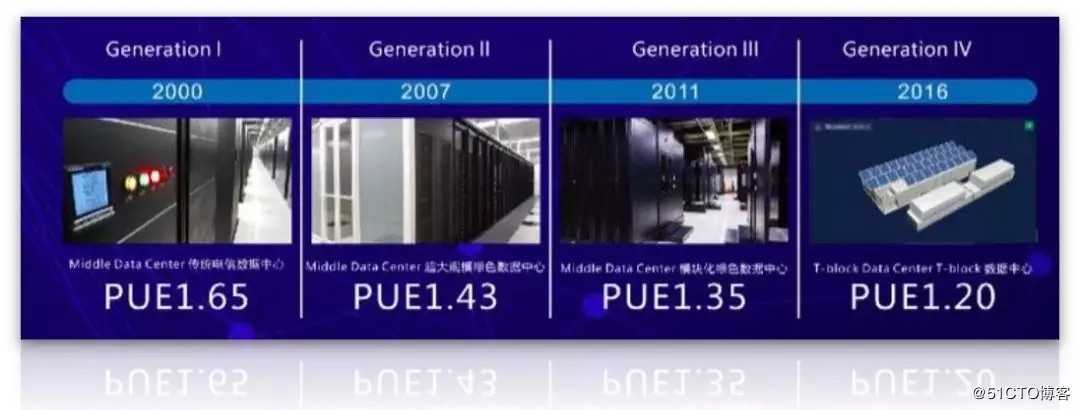

对于企业级的数据中心而言,绿色节能意味着大量成本的节省(视规模的不同,大型数据中心的整体PUE值每下降0.1意味着每年电费可以降低数百万元到上千万元人民币)。

而对向外出租运营的数据中心而言,绿色节能则直接关系到自己的市场竞争力和盈利水平。

绿色节能作为新一代数据中心建设的核心理念之一,正受到国内外金融行业越来越多的关注。

2019年2月,工信部、国家×××管理局、×××近日联合印发《关于加强绿色数据中心建设的指导意见》(下简称《意见》),明确提出要建立健全绿色数据中心标准评价体系和能源资源监管体系,到2022年,数据中心平均能耗基本达到国际先进水平。

《意见》指出,引导大型和超大型数据中心设计电能使用效率值不高于1.4;力争通过改造使既有大型、超大型数据中心电能使用效率值不高于1.8。

然而,目前大部分的数据中心PUE值难以达到这一参考值,有的数据中心的PUE值甚至高于2.0。原因在于很多设备所需要的运行温度偏低,一旦提高数据中心的制冷温度,设备会因为温度过高而出现宕机,这样会造成企业业务中断的后果。因此很多数据中心不敢冒这样的风险来提高室内温度,所以PUE值也一直降不下去。

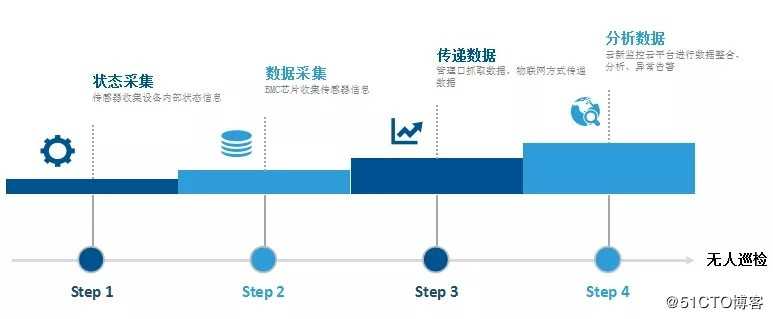

顶云运维平台是一款集中式带外管理平台,主要监测设备的物理状态,可提供部件级的监测。快速自动巡检,减少运维人员在数据中心里花费的设备巡检时间,精准定位设备故障,不必查看设备运行提示灯以及运行日志,运维人员可根据告警信息直接查看相应位置确定故障信息再进行相应的维修处理。

对于数据中心的能耗管理,顶云可根据自己的技术条件,实时监测每一台设备的实时功率以及设备进风口、出风口的温度。整个过程不需要外接只能PDU,更不需要改造数据中心,不会对用户产生硬件上花费。

顶云运维主要做到一下几点来为数据中心节约用电,降低PUE值:

电量测量

识别用电峰值,确保机房用电安全。

增加机架密度

增加机柜密度,延长数据中心使用寿命。

识别僵尸服务器

提高服务器利用率,降低能耗浪费。

识别功耗/温度故障

结合功耗数据、以及温度数据的环比数据,发现设备异常,提早预测机器故障。

功耗管理

标签:条件 inf 开始 进入 理想 云运维 src 基础设施 code

原文地址:https://blog.51cto.com/14121283/2395860