标签:读取 假设 指定 user gui 剖析 上传文件 pac hdfs

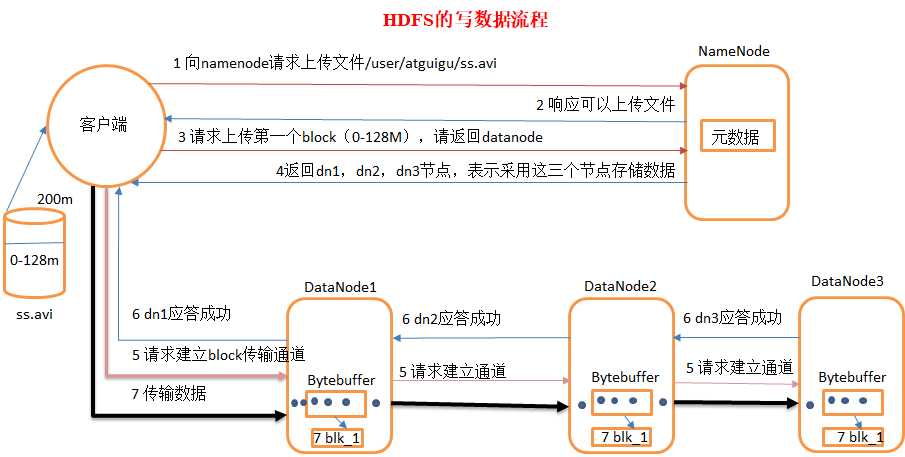

假设文件ss.avi共200m,其写入HDFS指定路径/user/atguigu/ss.avi流程如下:

1)客户端向namenode请求上传文件到指定路径,namenode通过元数据检查目标文件是否已存在,父目录是否存在。

2)namenode返回是否可以上传。

3)客户端请求第一个 block上传到哪几个datanode服务器上。

4)namenode返回3个datanode节点(根据副本数),分别为dn1、dn2、dn3。

5)客户端请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成

6)dn1、dn2、dn3逐级应答客户端

7)客户端开始往dn1上传第一个block(先从磁盘读取数据放到一个本地内存缓存Bytebuffer),以packet为单位,dn1收到一个packet就会传给dn2,dn2传给dn3;dn1每传一个packet会放入一个应答队列等待应答

8)当一个block传输完成之后,客户端再次请求namenode上传第二个block的服务器。(重复执行3-7步)

标签:读取 假设 指定 user gui 剖析 上传文件 pac hdfs

原文地址:https://www.cnblogs.com/MWCloud/p/11214065.html