标签:col lex tensor 使用 线性 操作 面试题1 ima 池化层

|

感受野 |

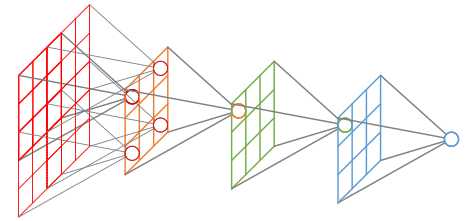

在卷积神经网络中,感受野(Receptive Field)的定义是卷积神经网络每一层输出的特征图(feature map)上的像素点在输入图片上映射的区域大小。再通俗点的解释是,特征图上的一个点对应输入图上的区域,如下图所示:

|

多个小卷积核连续卷积和单个大卷积核卷积的作用相同 |

像LeNet、AlexNet网络,都是用了较大的卷积核,目的是提取出输入图像更大邻域范围的信息,一般是卷积与池化操作相连。而小卷积核同样可以做到这个效果,其结构可能有多个卷积相连,然后再连接池化层。

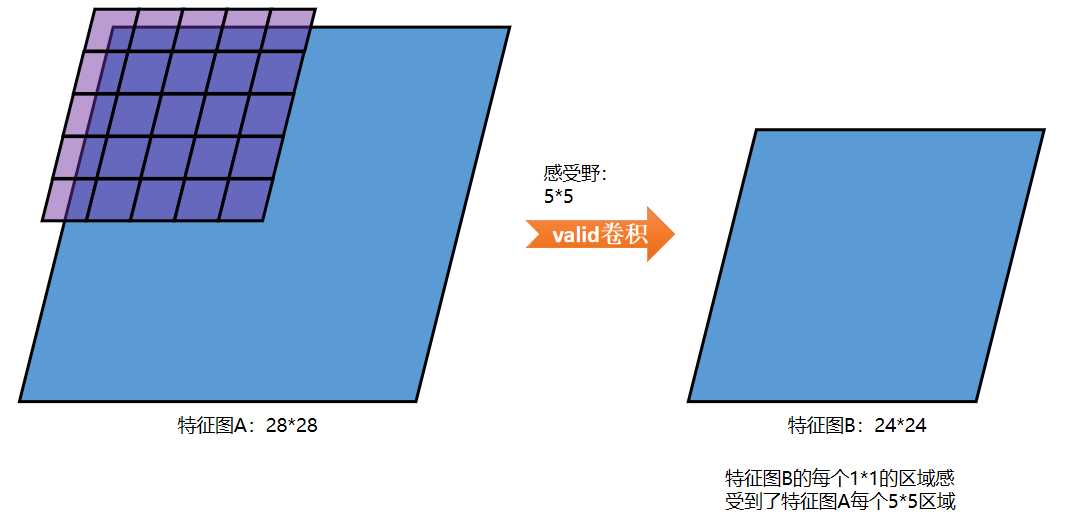

以一个5*5的卷积核举例:

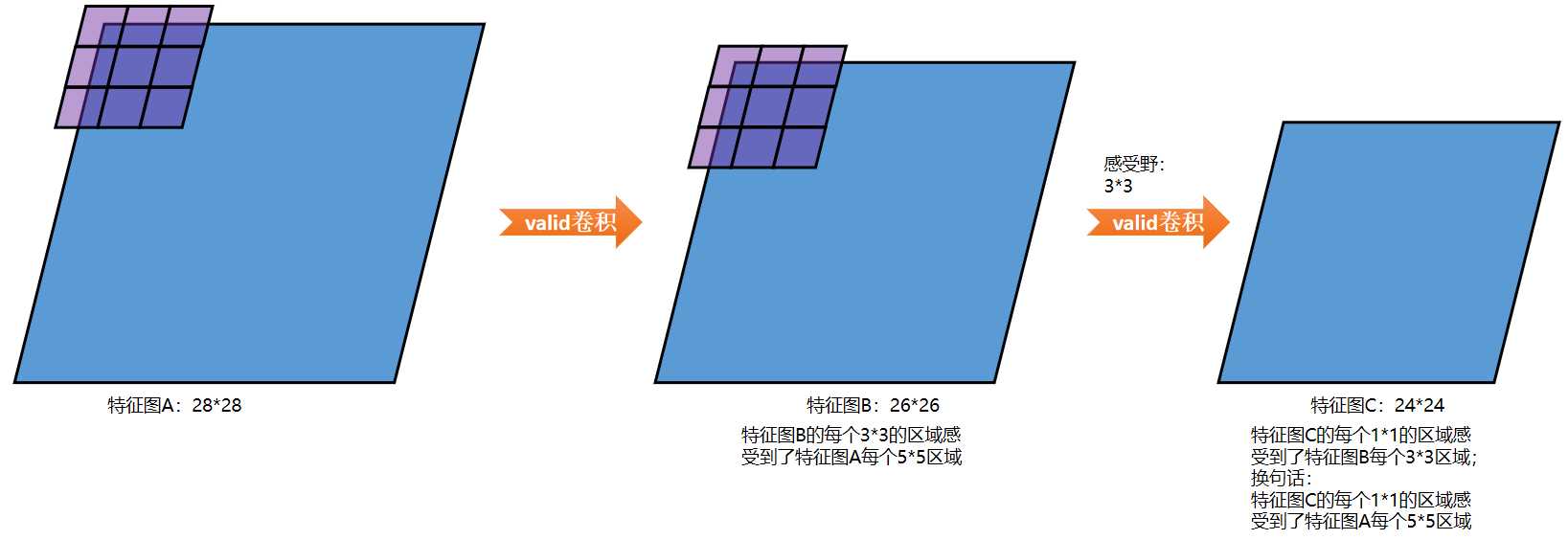

以2个3*3的卷积核举例:

结论:

使用3*3的卷积核连续卷积2次可以达到5*5的卷积核卷积1次提取特征图的能力;

同理,使用3*3的卷积核连续卷积3次可以达到7*7的卷积核卷积1次提取特征图的能力;

|

小卷积核的优势 |

优势一:

整合了三个非线性激活层,代替单一非线性激活层,增加了判别能力。

优势二:

减少了网络参数。

以3个3*3的级联卷积代替1个7*7的卷积为例:可以减少7*7-3*3*3=22个参数,减少了45%的参数。

以2个3*3的级联卷积代替1个5*5的卷积为例:可以减少5*5-2*3*3=7个参数,减少了28%的参数。

优势三:

减少了计算量

以3个3*3的级联卷积代替1个7*7的卷积为例:可以减少7*7*L-3*3*3*L=22*L次计算,减少了45%的计算量。

以2个3*3的级联卷积代替1个5*5的卷积为例:可以减少5*5*L-2*3*3*L=7*L次计算,减少了28%的计算量。

|

参考资料 |

《图解深度学习与神经网络:从张量到TensorFlow实现》_张平

《深-度-学-习-核-心-技-术-与-实-践》

标签:col lex tensor 使用 线性 操作 面试题1 ima 池化层

原文地址:https://www.cnblogs.com/itmorn/p/11214757.html