标签:训练 inf 集成 范围 影响 特征 梯度 接受 效果

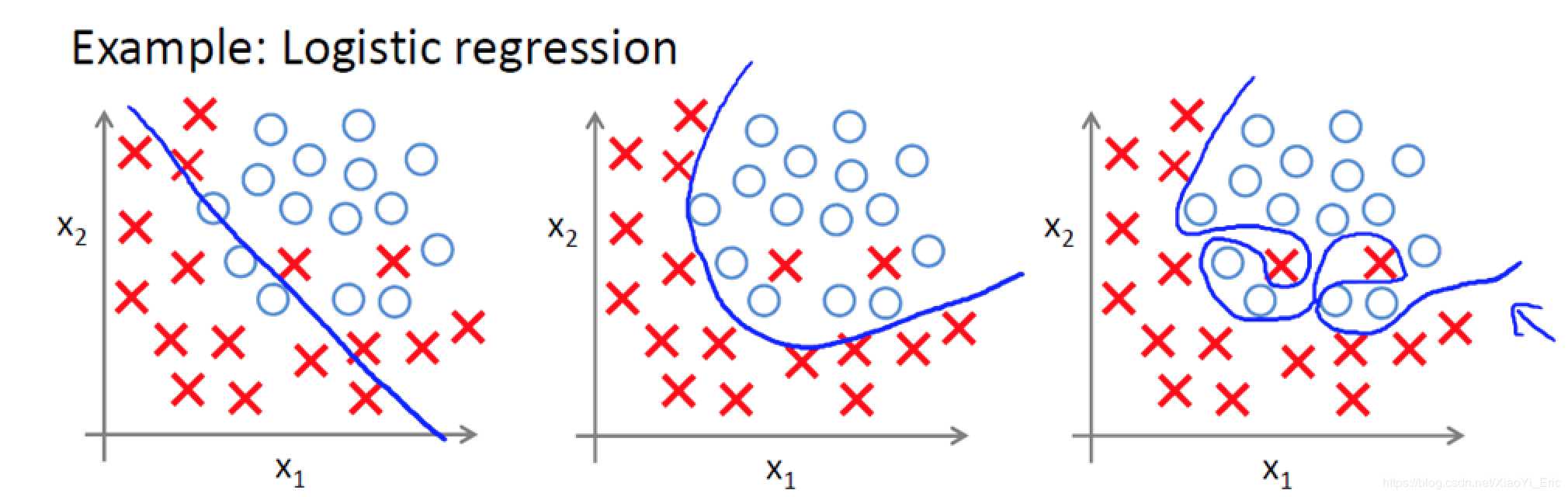

了解什么是过拟合问题,以下面图片为例,我们能够看到有两个类别,蓝色是分类曲线模型。

模型过拟合是因为模型过于复杂,可以通过对特征变量系数的调整来避免过拟合,而引入正则化正是为了实现这个目的,具体如何实现将在下一节说明。

常见的正则化方法有这几种:

$$\left \| W \right \|_{1}=\sum_{i,j}\left |\omega _{i,j} \right |$$

$$\left \| W \right \|_{2}=\sqrt{\sum_{i,j}\left (\omega _{i,j} \right )^{2}}$$

假设神经网络的损失函数为J(W,b),参考逻辑回归的正则化,是在损失函数J(W,b)后面加一个正则化项,神经网络DNN也是一样的,只是变成了加F-范数,L1正则化与L2正则化如下所示:

$$L2: J(W,b)+\frac{\lambda }{2m}\sum_{l\epsilon L}\left \| W \right \|_{2}=J(W,b)+\frac{\lambda }{2m}\sum_{l\epsilon L}\sqrt{\sum_{i,j}\left (\omega _{i,j} \right )^{2}}$$

$$L1: J(W,b)+\frac{\lambda }{2m}\sum_{l\epsilon L}\left \| W \right \|_{1}=J(W,b)+\frac{\lambda }{m}\sum_{l\epsilon L}\sum_{i,j}\left |\omega _{i,j} \right |$$

这里m为样本数,l为各个隐藏层,$\lambda$为超参数,需要自己调试。

由于L1正则与L2正则原理相似,而且大多数神经网络模型使用L2正则,所以这里以L2为例来说明为什么能防止过拟合。

原损失函数$J(W,b)$加上正则项$\frac{\lambda }{2m}\sum_{l\epsilon L}\left \| W \right \|_{2}$之后的新损失函数$J(W,b)^{‘}=J(W,b)+\frac{\lambda }{2m}\sum_{l\epsilon L}\left \| W \right \|_{2}$,在使用梯度下降训练模型时,目标是要最小化新的损失函数$ J(W,b)^{‘}$,我们在训练前先设置超参数$\lambda$,若设置较大的超参数$\lambda=0.9$,则相对于设置较小的超参数$\lambda=0.1$,我们需要更小的权重F-2范数$\left \| W \right \|_{2}$才能够使得我们达到最小化$ J(W,b)^{‘}$的目的。所以如果我们使用较大的超参数$\lambda$的时候,会使得W整体变得更加的稀疏,这样就可以使得W的影响减少,从而避免了由于模型过于复杂导致的过拟合。

$$新损失函数:J(W,b)^{‘}=J(W,b)+\frac{\lambda }{2m}\sum_{l\epsilon L}\left \| W \right \|_{2}$$

标签:训练 inf 集成 范围 影响 特征 梯度 接受 效果

原文地址:https://www.cnblogs.com/dwithy/p/11269994.html