标签:环境变量 src env alt 技术 安装 star 目录文件 pre

scala下载地址:https://www.scala-lang.org/download/

spark下载地址:https://spark.apache.org/downloads.html

tar -zxvf scala-2.13.0.tgz scp -r scala-2.13.0 node102:/root scp -r scala-2.13.0 node103:/root

#scala export SCALA_HOME=/root/scala-2.13.0 export PATH=$SCALA_NAME/bin:$PATH

source /etc/profile

#spark export SPARK_HOME=/root/spark-2.4.3 export PATH=$PATH:$SPARK_HOME/bin

export JAVA_HOME=/root/jdk1.8.0_211 export SCALA_HOME=/root/scala-2.13.0 export HADOOP_HOME=/root/hadoop-3.1.2 export HADOOP_CONF_DIR=/root/hadoop-3.1.2/etc/hadoop export SPARK_WORKER_MEMORY=500m export SPARK_WORKER_CORES=1 export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=hadoop1:2181,hadoop2:2181,hadoop3:2181,hadoop4:2181 -Dspark.deploy.zookeeper.dir=/spark"

node101

node102

node103

scp -r spark-2.4.3/ node102:/root scp -r spark-2.4.3/ node103:/root

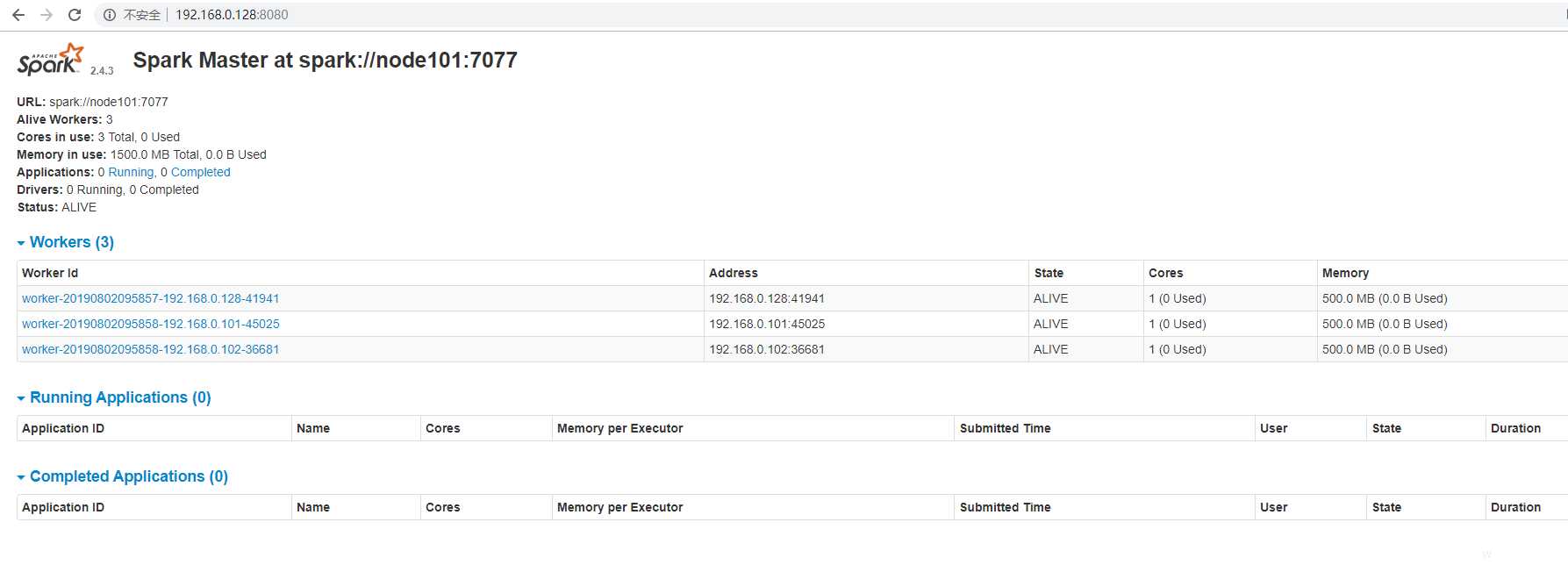

cd /spark-2.4.3/sbin start-all.sh

标签:环境变量 src env alt 技术 安装 star 目录文件 pre

原文地址:https://www.cnblogs.com/wwbz/p/11286830.html