标签:基本 技术 ide oid com gis 最大化 inf app

基本形式:

$f(x_{i})=W^{T}X_{i} + b$,使得$f(x_{i}) \approx y_{i}$

最小二乘估计:

$\widehat{w}^{*}= \underset{\widehat{w}}{arg min}(y - X\widehat{w})^{T}(y - X\widehat{w})$

令$E_{\widehat{w}}=(y - X\widehat{w})^{T}(y - X\widehat{w})$对$\widehat{w}$其求导:

$\frac{\partial E_{\widehat{w}}}{\partial x}=2 X^{T}(X\widehat{w}-y)$

如果$X^{T}X$为满秩矩阵或正定矩阵时,令上式为0:

$\widehat{w}^{*}=(X^{T}X)^{-1}X^{T}y$

logistic回归:把x映射到0-1范围内。

$y=\frac{1}{1+e^{-z}}$ (sigmoid函数)

$ln\frac{y}{1-y}=w^{T}x+b$

确定w和b:

$ln\frac{p(y=1|x)}{p(y=0|x)}=w^{T}x+b$

显然有:

$p(y=1|x) = \frac{e^{w^{T}x+b}}{1+e^{w^{T}x+b}}$

$p(y=0|x) = \frac{1}{1+e^{w^{T}x+b}}$

通过极大似然法:

最大化:

$\iota (w,b)=\sum_{i=1}^{m} ln(p(y_{i}|x_{i};w,b))$

因为$p(y_{i}|x_{i};w,b)=y_{i}P_{1}(\widehat{x_{i}};\beta )+(1-y_{i}P_{0}(\widehat{x_{i}};\beta ))$,所以等价于最小化:

$\iota (\beta )=\sum_{i=1}^{m} (-y_{i}\beta^{T}x_{i} + ln(1+e^{\beta^{T}x_{i}}))$ (把常数去掉)

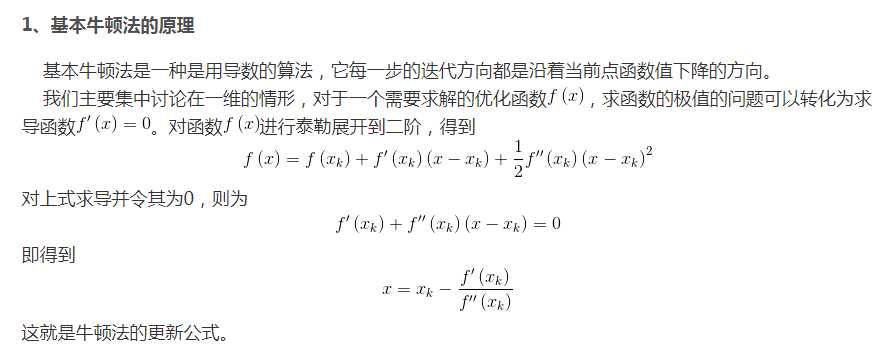

牛顿法:

$\beta^{t+1}=\beta^{t}-(\frac{\partial^2 \iota (\beta)}{\partial \beta \partial \beta^{T}})^{-1}\frac{\partial \iota (\beta)}{\partial \beta}$

标签:基本 技术 ide oid com gis 最大化 inf app

原文地址:https://www.cnblogs.com/xcxy-boke/p/11409957.html