标签:auth author 命令 manager code 停止 启用 数据 service

1.独立模式(standalone|local)

nothing!

本地文件系统。

不需要启用单独进程。

2.pesudo(伪分布模式)

等同于完全分布式,只有一个节点。

SSH: //(Socket),

//public + private

/server : sshd ps -Af | grep sshd

//clint : ssh

//ssh-keygen:生成公私秘钥。

//authorized_keys 需要使用644

//ssh 192.168.231.201 yes

[配置文件]

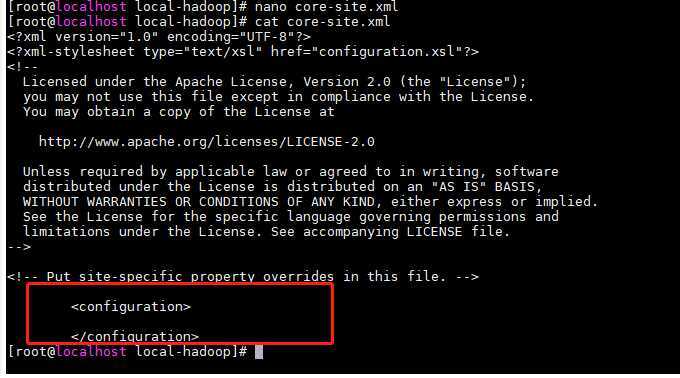

core-site.xml //fs.defaultFS=hdfs://localhost/ 默认8020

hdfs-site.xml //replication=1 伪分布就一个节点

mapred-site.xml //

yarn-site.xml //

3.full distributed(完全分布式)

=================================================================

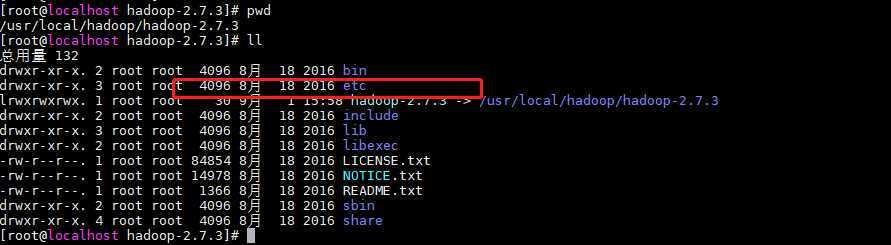

分布式启动配置

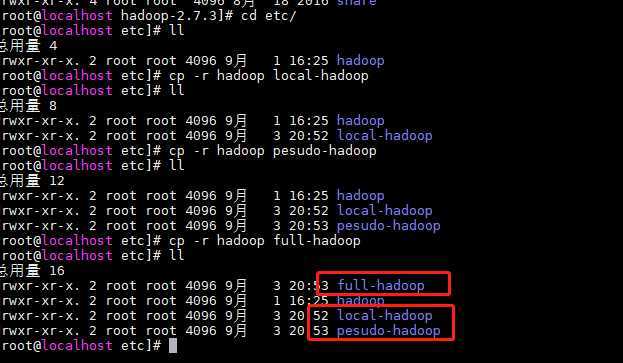

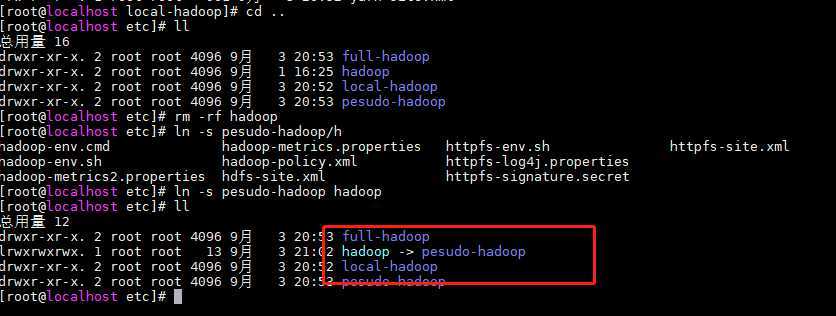

在etc目录下将hadoop 赋值三份 本地 伪分布式 完全分布式

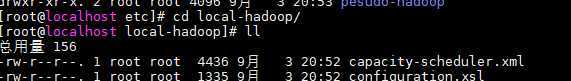

使用伪分布式模式

1 进入local-hadoop 修改core-site.xml文件

2. 把原来的hadoop文件夹删掉 创建符号链接到local-hadoop

创建符号链接: ln -s pesudo-hadoop hadoop

以下会具体启动

=================================================================

配置hadoop,使用符号连接的方式,让三种配置形态共存。

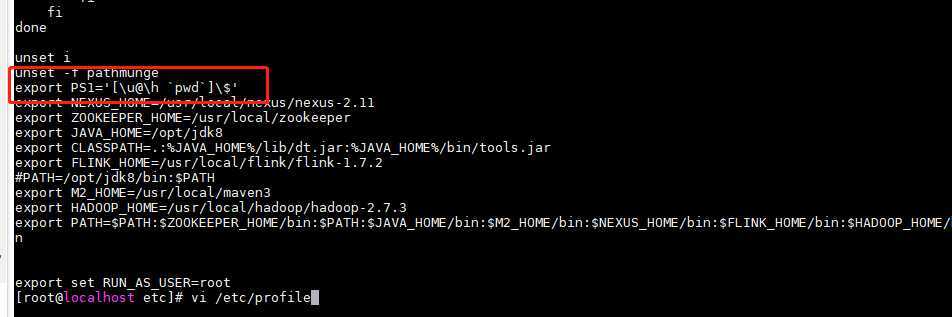

让命令行提示符显式完整路径

---------------------------

1.编辑profile文件,添加环境变量PS1

[/etc/profile]

export PS1=‘[\u@\h `pwd`]\$‘

2.source

$>source /etc/profile

1.创建三个配置目录,内容等同于hadoop目录

${hadoop_home}/etc/local-hadoop

${hadoop_home}/etc/pesudo-hadoop

${hadoop_home}/etc/full-hadoop

2.创建符号连接

$>ln -s

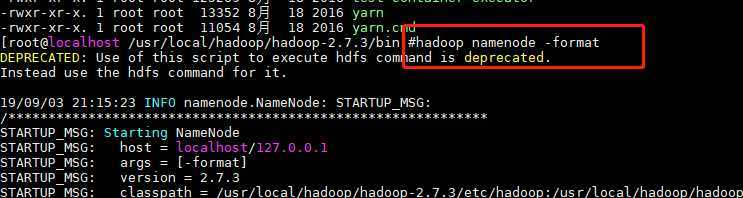

3.对hdfs进行格式化 (任何目录下都可以)

$>hadoop namenode -format

4.修改hadoop配置文件,手动指定JAVA_HOME环境变量

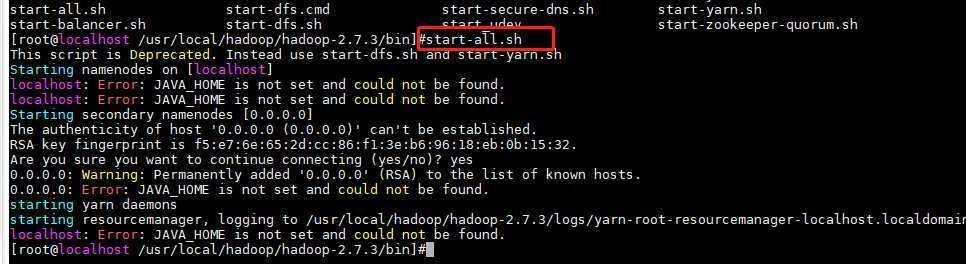

注意如果不配置会出现以下情况

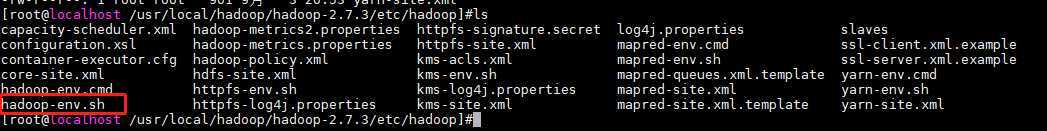

[${hadoop_home}/etc/hadoop/hadoop-env.sh]

...

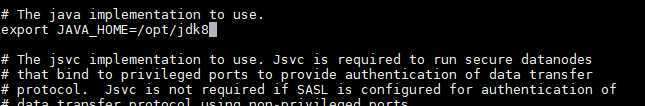

vi hadoop-env.sh

export JAVA_HOME=/opt/jdk8

...

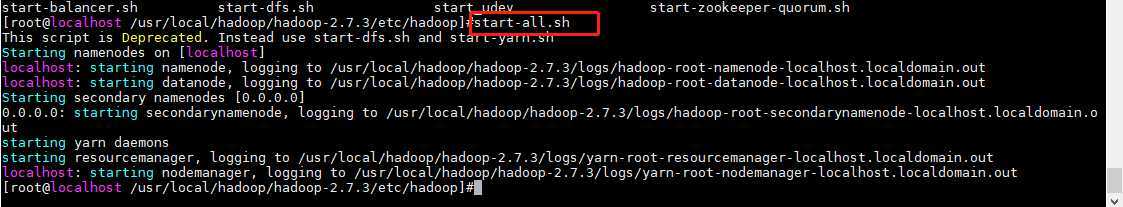

5.启动hadoop的所有进程

$>start-all.sh

6.启动完成后,出现以下进程

$>jps

33702 NameNode

33792 DataNode

33954 SecondaryNameNode

29041 ResourceManager

34191 NodeManager

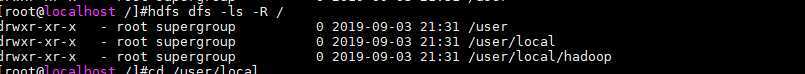

7.查看hdfs文件系统

$>hdfs dfs -ls /

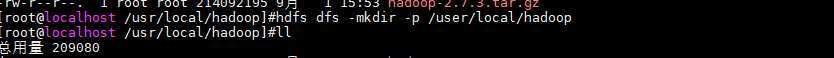

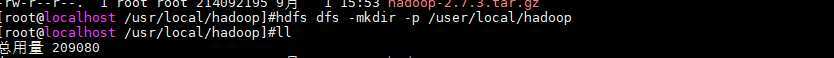

8.创建目录

$>hdfs dfs -mkdir -p /user/local/hadoop

9. 查看端口是否启动

netstat -ano | grep 50070

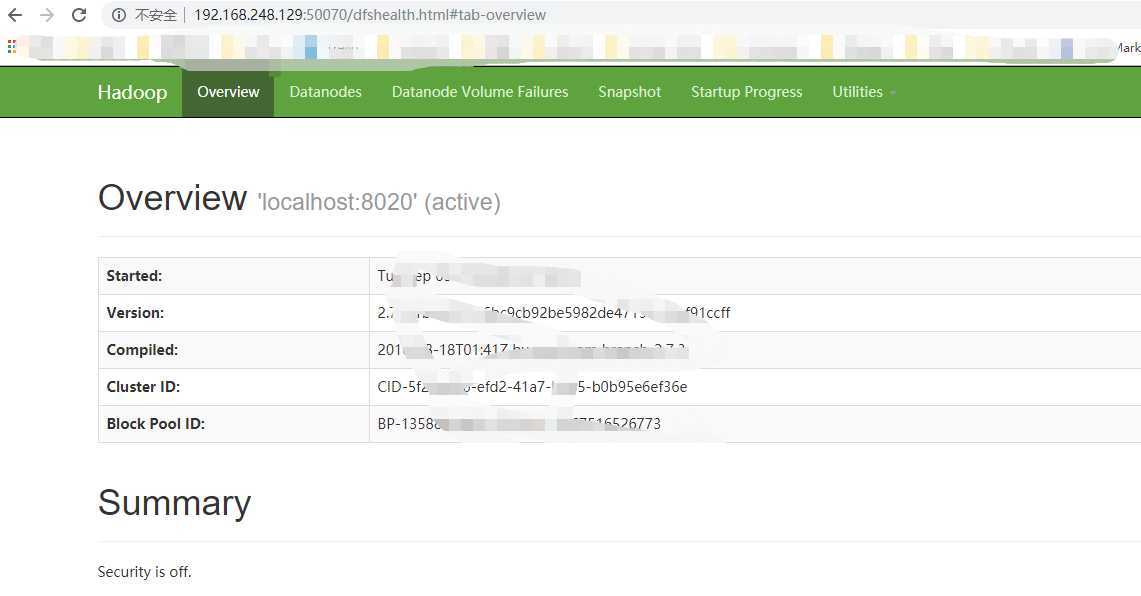

10.通过webui查看hadoop的文件系统

http://localhost:50070/ (访问的时候注意端口号是否开放)

11.停止hadoop所有进程

$>stop-all.sh

12.centos防火墙操作

[cnetos 6.8]

配置防火墙放行50070端口,允许其它主机访问。

vim /etc/sysconfig/iptables

更改ip

cd /etc/sysconfig/network-scripts/

重启网络服务

service network restart

重启防火墙

service iptables restart

临时关闭/开启防火墙

service iptables stop/start

查看防火墙状态

service iptables status

查看端口

netstat -tunpl | grep50070

hadoop的端口

-----------------

50070 //namenode http port

50075 //datanode http port

50090 //2namenode http port 辅助名称节点端口

8020 //namenode rpc port

50010 //datanode rpc port

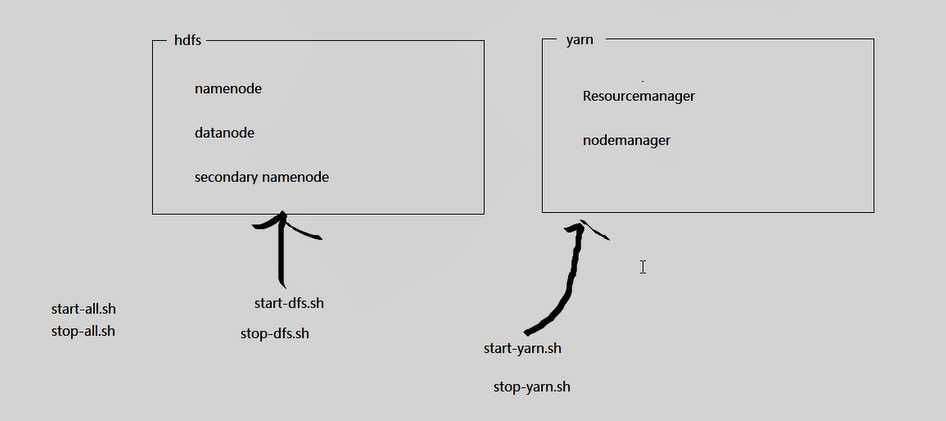

hadoop四大模块

-------------------

common

hdfs //namenode + datanode + secondarynamenode

mapred

yarn //resourcemanager + nodemanager

启动脚本

-------------------

1.start-all.sh //启动所有进程

2.stop-all.sh //停止所有进程

3.start-dfs.sh // (分布式文件系统)

4.start-yarn.sh

[hdfs] start-dfs.sh stop-dfs.sh

NN (namenode 名称节点)

DN (datanode数据节点)

2NN (2namenode赋值文名称节点)

[yarn] start-yarn.sh stop-yarn.sh

RM

NM

伪分布模式到此结束

标签:auth author 命令 manager code 停止 启用 数据 service

原文地址:https://www.cnblogs.com/YuanWeiBlogger/p/11455627.html