标签:hadoop comm 解决 mon nod hdf java apache ble

如标题,最近我由于想初始化以下hadoop集群,之后却发现启动集群后所有的DataNode都消失了。

问题查找:

由于时所有的DataNode都出了问题,于是我翻找了以下DataNode的日志(默认在安装下的logs文件里):

2019-09-21 14:51:16,642 WARN org.apache.hadoop.hdfs.server.common.Storage: Failed to add storage directory [DISK]file:/home/howie/hadoop/dfs/data/ java.io.IOException: Incompatible clusterIDs in /home/howie/hadoop/dfs/data: namenode clusterID = CID-952bba13-0ef1-4383-9985-38c30ecbd500;

datanode clusterID = CID-5d8ae51b-e670-449c-90bb-f676aabe3fef

看出来可能是因为namenode的clusterID与datanode的clusterID不一样而造成的错误,但我并没有看懂,上网查了一下,发现只需要将所有datanode的hdfs的data的目录下的current删除即可。

解决:

于是我决定尝试一下:

rm -rf /home/howie/hadoop/dfs/data/current

#在所有的DataNode下执行

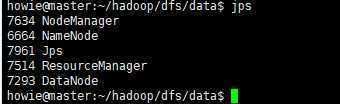

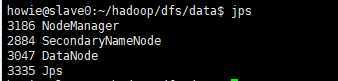

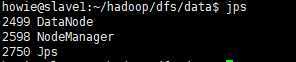

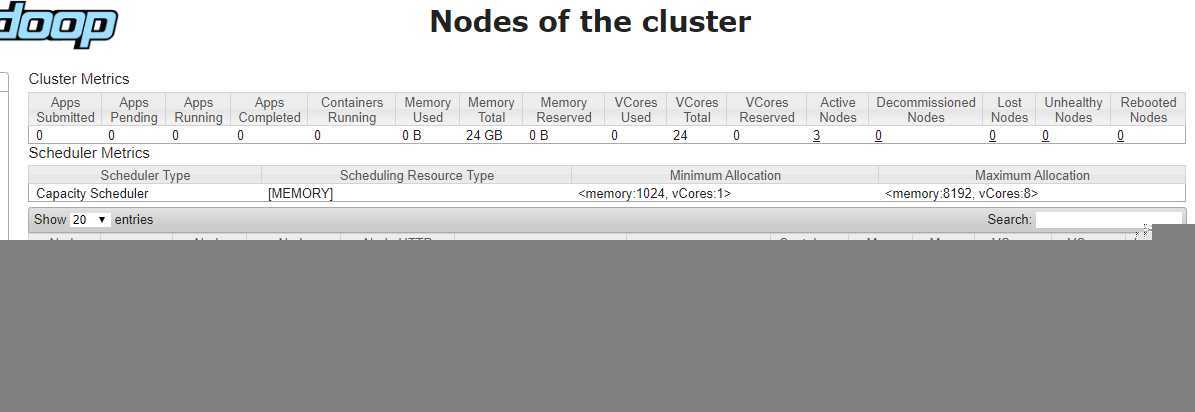

然后该出来的都出来了

关于hadoop多次format之后,会出现的dataNode消失问题

标签:hadoop comm 解决 mon nod hdf java apache ble

原文地址:https://www.cnblogs.com/howielu/p/11565117.html