标签:mic 通过 系统 依赖 一个 lease 设置 div remove

一、IDEA安装

下载Community版的IDEA,Ultimate是免费试用版(相当于用到后面要给钱的)

ideaIC-2019.2.3.tar.gz

解压IDEA:

tar -zxvf ideaIC-2019.2.3.tar.gz

查看目录:

[hadoop@hadoop01 idea-IC-192.6817.14]$ ls -ll

total 52

drwxrwxr-x. 2 hadoop hadoop 4096 Oct 2 22:08 bin

-rw-r--r--. 1 hadoop hadoop 14 Sep 24 12:43 build.txt

-rw-r--r--. 1 hadoop hadoop 1914 Sep 24 12:43 Install-Linux-tar.txt

drwxrwxr-x. 7 hadoop hadoop 83 Oct 2 22:08 jbr

drwxrwxr-x. 4 hadoop hadoop 8192 Oct 2 22:08 lib

drwxrwxr-x. 2 hadoop hadoop 4096 Oct 2 22:08 license

-rw-r--r--. 1 hadoop hadoop 11352 Sep 24 12:43 LICENSE.txt

-rw-r--r--. 1 hadoop hadoop 128 Sep 24 12:43 NOTICE.txt

drwxrwxr-x. 43 hadoop hadoop 4096 Oct 2 22:08 plugins

-rw-r--r--. 1 hadoop hadoop 370 Sep 24 12:46 product-info.json

drwxrwxr-x. 2 hadoop hadoop 35 Oct 2 22:08 redist

启动iedea:

[hadoop@hadoop01 bin]$ ./idea.sh

OpenJDK 64-Bit Server VM warning: Option UseConcMarkSweepGC was deprecated in version 9.0 and will likely be removed in a future release.

Startup Error: Unable to detect graphics environment

报错:Unable to detect graphics environment

解决办法:不要在外面通过远程的方式执行此启动命令,要在linux图形界面中打开终端来执行此命令

在linux终端中执行命令启动idia:

[hadoop@hadoop01 ~]$ cd idea-IC-192.6817.14

[hadoop@hadoop01 idea-IC-192.6817.14]$ bin/idea.sh

OpenJDK 64-Bit Server VM warning: Option UseConcMarkSweepGC was deprecated in version 9.0 and will likely be removed in a future release.

下载安装scala插件

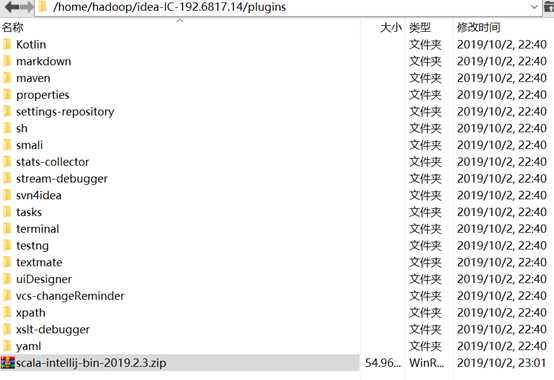

将 scala-intellij-bin-2019.2.3.zip 放在 scala主目录plugins文件夹里

注:scala插件一定要与idea版本对应,如我的就是:scala-intellij-bin-2019.2.3.zip对应ideaIC-2019.2.3.tar.gz

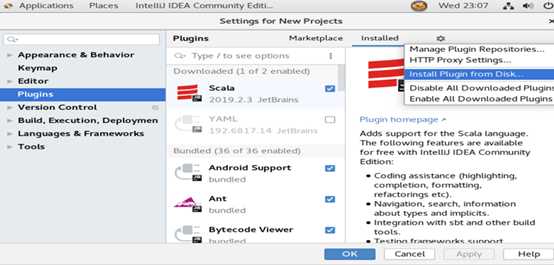

再在启动的idea中找到setting里面的plugins中选择install plugin from disk…

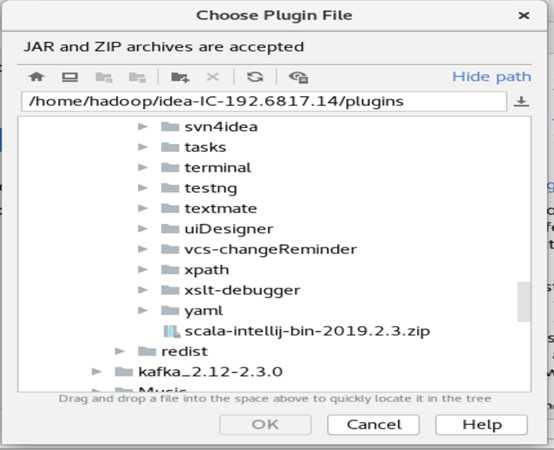

选中插件包

最后重启idea,即可。

二、IDEA测试

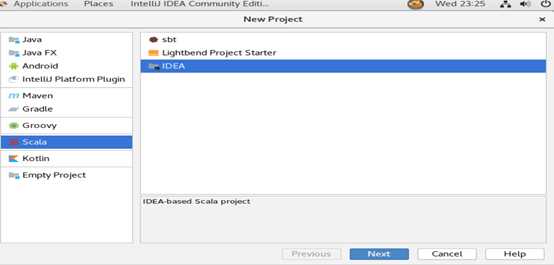

创建scala新工程

注:选择IDEA 便是创建普通的Scala 项目(注:IJ IDEA版本的不同,这里IDEA可能显示成Scala,不过这个并没有什么影响)

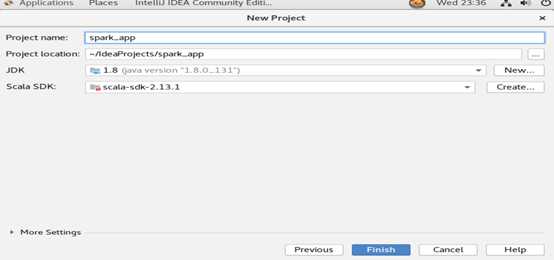

工程的基本页面设置:

其中:

project name :工程名称

project location :工程文件地址

jdk :使用的java version 版本,未找到时,自己选择jdk的安装目录

scala SDK :使用scala版本,未找到时,自己选择scala的安装目录

点击finish后,进入设计主页面

这个时候,第一次系统会对设置进行索引。

这里需要指出,IDEA对新工程的索引需要时间,长短视虚拟机的配置而定

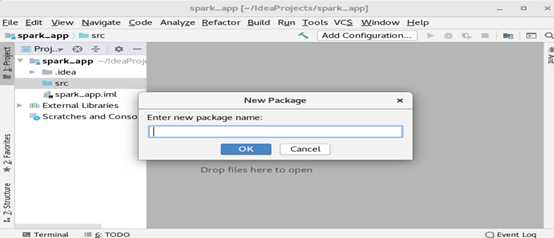

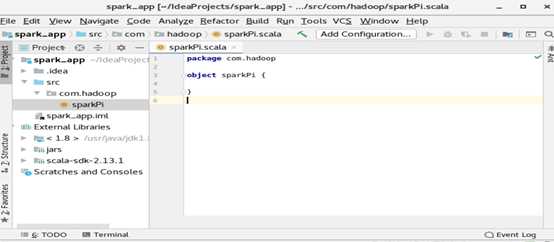

在src处右键new—package,准备创建一个scala包

Package name :com.hadoop

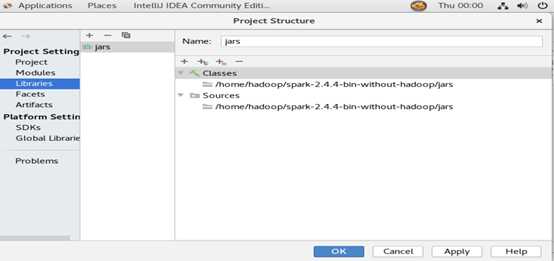

配置工程结构(project structure),为了导入spark依赖包

依次选择主界面的file-- project structure,在弹出的对话框中选择librarie --+--java,选择虚拟机中已安装spark目录下的jars下所有的jar包

点击OK后,系统会再次进行索引

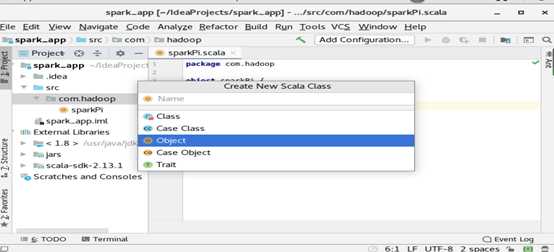

创建scala类

在com.hadoop包上右键new – scala class,弹出如下界面

输入sparkPi,并选择object

标签:mic 通过 系统 依赖 一个 lease 设置 div remove

原文地址:https://www.cnblogs.com/CQ-LQJ/p/11618884.html