标签:tail 输入 file mamicode 解压 article hive 上传 连接

下载网址: http://archive.cloudera.com/cdh5/cdh/5/

下载完后解压:tar xvf hadoop-2.6.0-cdh5.15.1.tar.gz

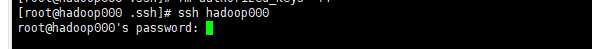

不用密码就可以登陆了。。。

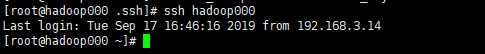

首先进入到hadoop的文件夹里 vi etc/hadoop/hadoop-env.sh 在最后一行添加java的环境 export JAVA_HOME=/usr/local/jdk/jdk1.8.0_161

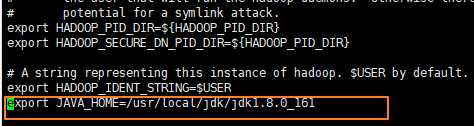

vi etc/hadoop/core-site.xml

添加以下内容

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop000:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/hadoop/app/hadoop-2.6.0-cdh5.15.1/tmp</value>

</property>

</configuration>

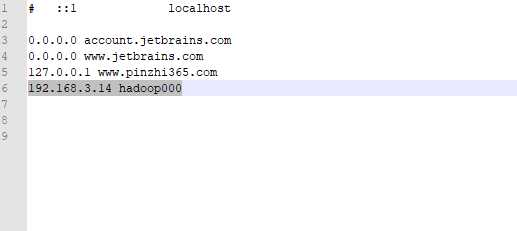

//设置连接hadoop000的地址

//设置hadoop存储的路径

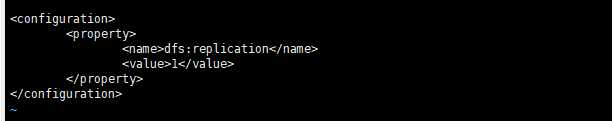

vi etc/hadoop/hdfs-site.xml

添加以下内容

<configuration>

<property>

<name>dfs:replication</name>

<value>1</value>

</property>

</configuration>

#代表的意思是dfs副本为1

export HADOOP_HOME=/root/hadoop/app/hadoop-2.6.0-cdh5.15.1 export PATH=$PATH:$HADOOP_HOME/bin export PATH=$PATH:$HADOOP_HOME/sbin

可能查看防火墙:firewall-cmd --state 显示是没开的,但是还是不行可以设置以下iptables,开放50070这个端口

1、hadoop fs -ls / 查看 2、hadoop fs -put src dst 上传文件到hadoop中 如:hadoop fs -put README.txt / 3、hadoop fs -copyFromLocal src dst 上传文件到hadoop中 如:hadoop fs -copyFromLocal NOTICE.txt / 4、hadoop fs -moveFromLocal src dst 移动文件到hadoop中 如:hadoop fs -moveFromLocal README2.txt / 5、hadoop fs -cat /README.txt 查看文件 6、hadoop fs -text /README.txt 查看文件 7.hadoop fs -get /README.txt 获取hadoop上面的文件 8、hadoop fs -mkdir /mytext 创建一个目录 9.hadoop fs -mv /README.txt /mytext 移动hadoop里的文件 10、hadoop fs -getmerge /mytext readme.txt 把一个文件夹里的文件合并成一个文件返回 hadoop 11、hadoop fs -rm /mytext/README.txt 12、hadoop fs -rmdir /mytext/ hadoop fs -rm -r /mytext/ 递归删除

标签:tail 输入 file mamicode 解压 article hive 上传 连接

原文地址:https://www.cnblogs.com/dabenxiang/p/11634529.html