标签:form 需要 最好 array 文章 任务 缓存 exec job

写wiki感觉不太好,直接写个人博客。其中掺杂了太多个人理解,不保证正确性。但是感觉网上的都是官样文章,而且都是抄来抄去,真真叫没意思。

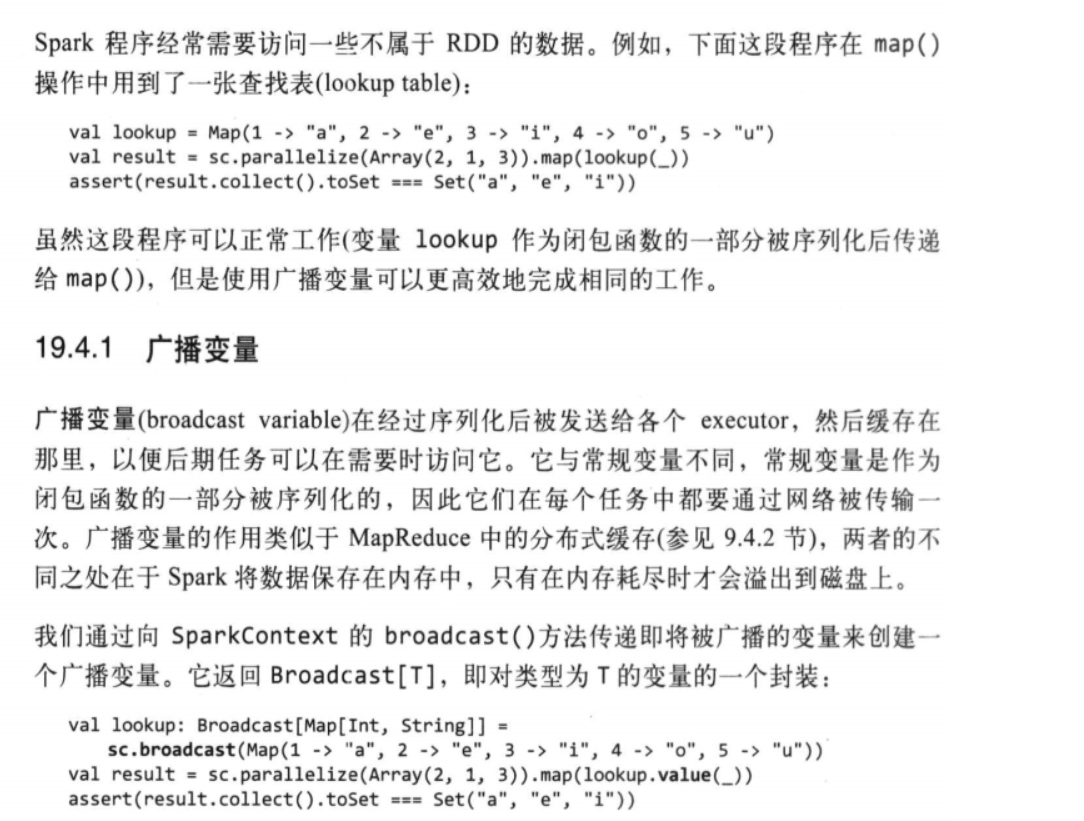

虽然rdd和map函数都定义在同一个python文件中,但是实际上map函数是在不同的excutor上执行的,可以通过闭包的方式将变量传递给各个rdd(在py文件顶层定义变量,在map的函数中使用),但这种方式,每次executor遇到不属于rdd的变量时都会请求一次driver,而广播变量则是一开始申请一次并缓存起来,后面每次都使用这个缓存。

虽然rdd和map函数都定义在同一个python文件中,但是实际上map函数是在不同的excutor上执行的,可以通过闭包的方式将变量传递给各个rdd(在py文件顶层定义变量,在map的函数中使用),但这种方式,每次executor遇到不属于rdd的变量时都会请求一次driver,而广播变量则是一开始申请一次并缓存起来,后面每次都使用这个缓存。标签:form 需要 最好 array 文章 任务 缓存 exec job

原文地址:https://www.cnblogs.com/jimmykeji/p/11657413.html