标签:arm 发布 读取文件 配色 imp 想法 美团网 oms 截图

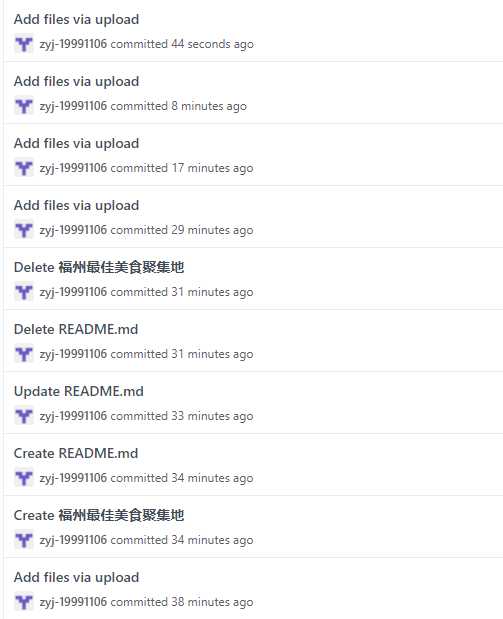

张逸杰:复制监督整个编程任务的进程以及协助组员编程

黄智锋、刘汪洋:负责UI设计

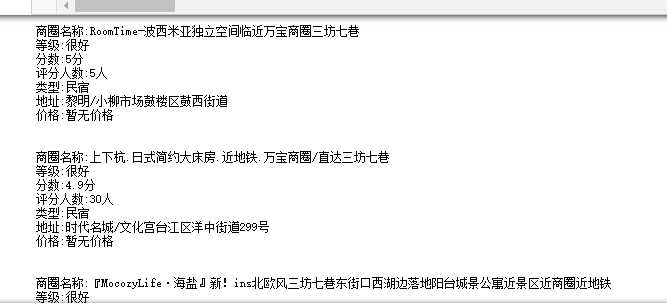

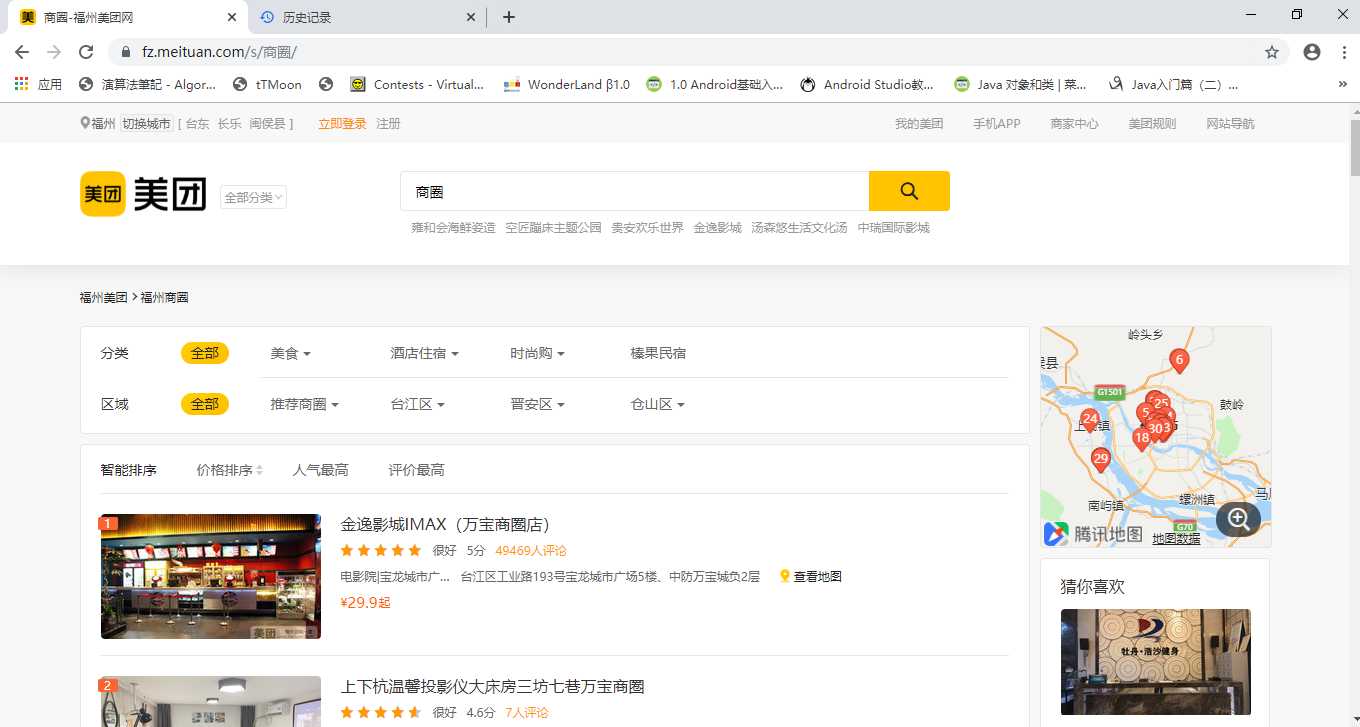

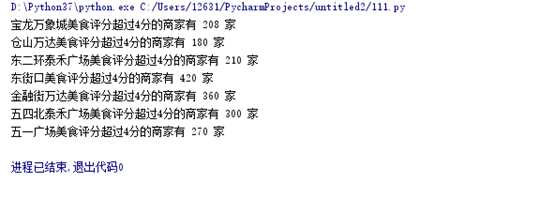

苏凯婷、鲍冰如:爬取数据并负责测评出福州最受欢迎的商圈

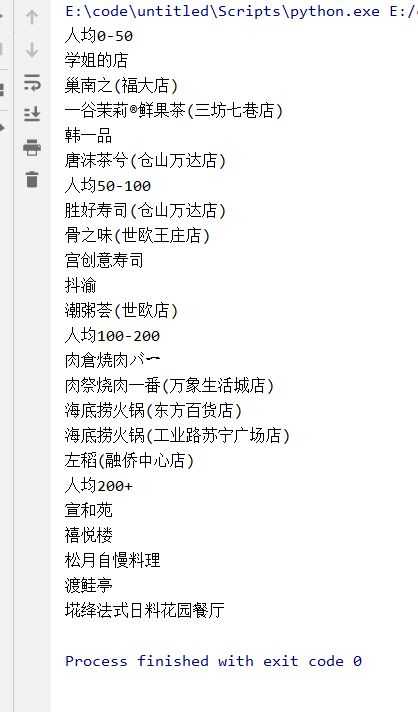

陈荣杰、杨锦镔:爬取数据并负责测评出福州人均消费50以下,50-100、100-200、200以上最佳(性价比最高)的前五家美食餐厅

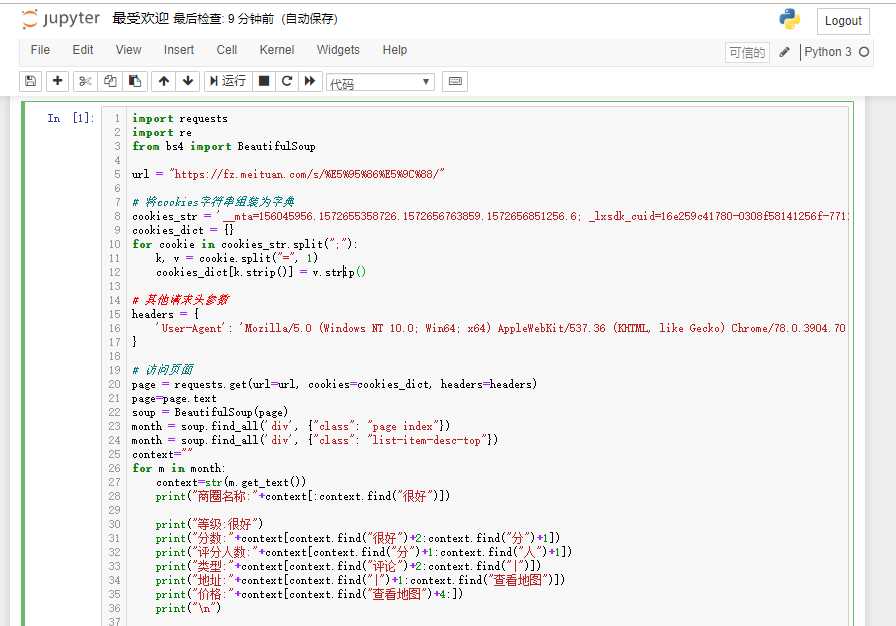

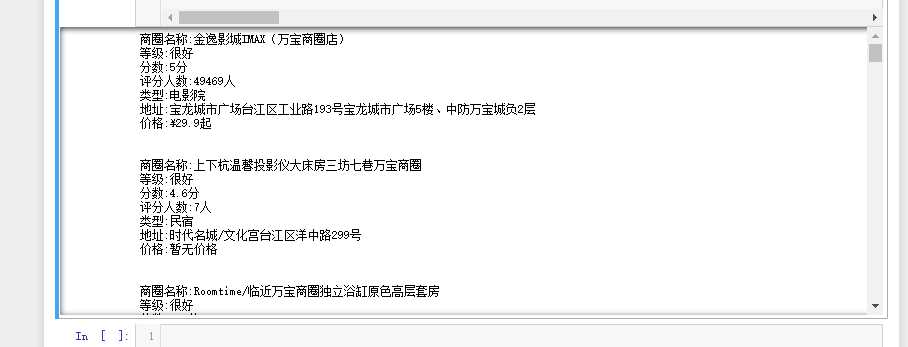

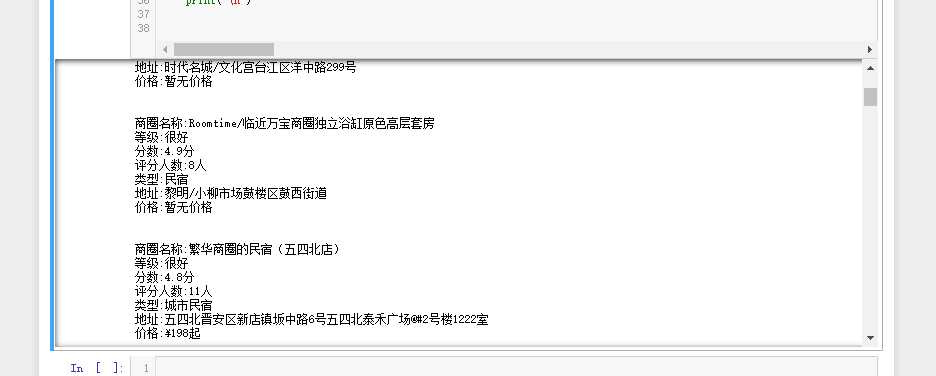

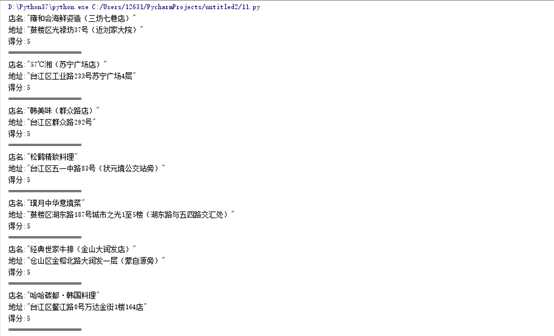

王嵚、林家伟:爬取数据并负责测评出测评出福州最佳美食聚集地

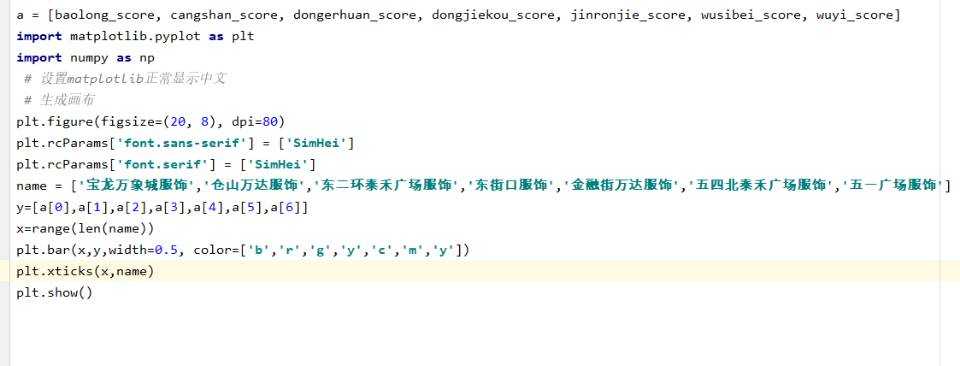

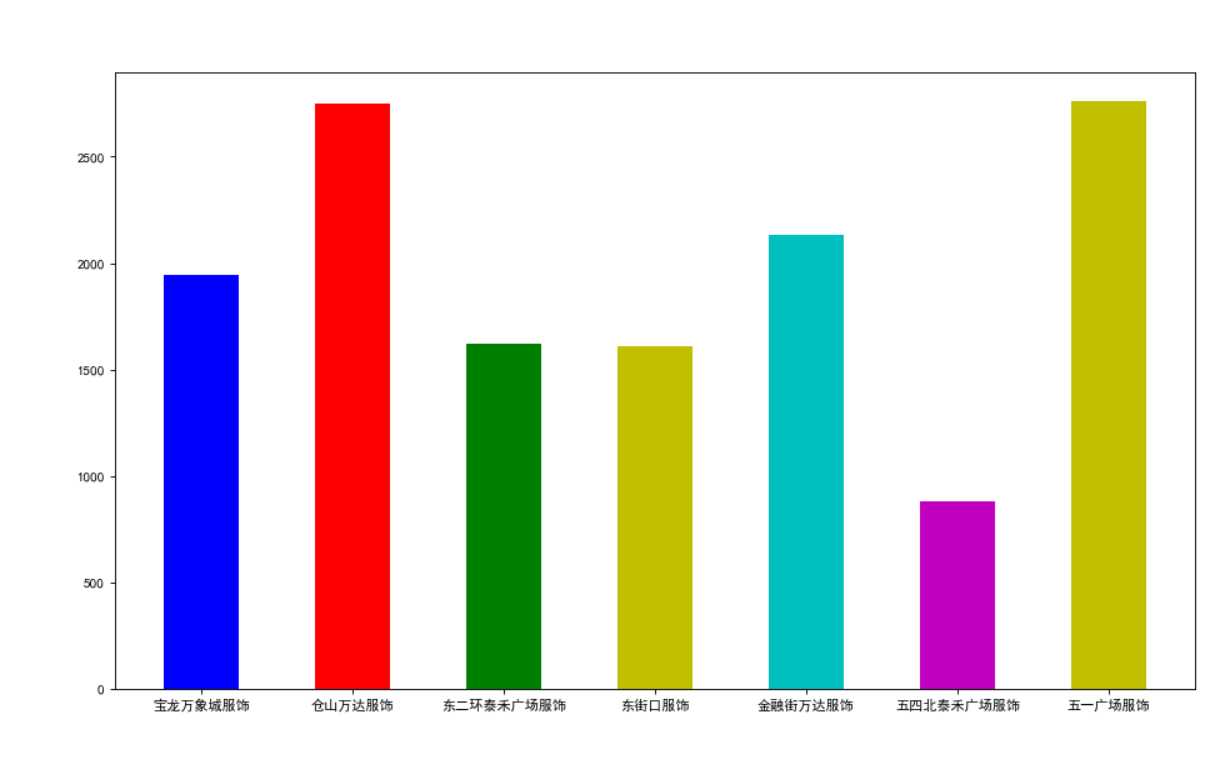

吴智勇、黄彬煌:爬取数据并负责测评出福州服饰类综合评分最高的商圈

统一运用windows操作系统、python语言、pycharm程序编程。

首先分别用爬虫对美团网的各个所需数据进行爬取。例如:要测出福州最受欢迎的商圈,就在美团网上搜索范围福州并进行筛选最后将数据爬取下来.然后再编写算法对数据进行筛选,最后做成图展示。

测评出福州各个消费等级的休闲娱乐场所前五名

杨锦镔:昨晚在晚上看了一下有关爬虫的知识,一看就会,一做就废,早上具体实现的时候却一直提取不出所想的信息。

黄智锋:困难:做UI的困难主要是选背景和排版上面,要选出符合主题的图片,然后还要根据要插入的内容合理修改图片

刘汪洋:我觉得做UI找合适的图挺难的,其他的不是特别难,主要是烦,我的队友就深有体会。

苏凯婷:一开始在做的时候比较迷茫,不知道应该爬取那个网页比较合适,所以浪费了大量的时间,在纠结应该使用哪个app对应的网页。导致浪费了一些时间,第二就是关于工具的安装,昨晚将大量的时间花费在对于爬虫的学习,只是看过去,并没有亲自去尝试实践,然而今天好像没有用到很多很难的爬虫的操作,第三,最近对python的使用频率比较低,所以早上在写的时候卡卡的,很容易出现报错,然后心态就爆炸,总的来说还是挺糟糕的。

鲍冰如:首先是技术和知识方面,没有实现了解更多的爬虫知识,实战的时候一边担心自己会拖后腿一边学习爬虫一边运用到此次的任务里,就很难,太难了,一开始不确定商圈的定义,计划爬取美团和百度地图和高德地图对商圈的信息,but技术硬伤搞很久也没搞出来,心态很崩。

张逸杰:爬取数据的时候一直爬不到某个数据,搞得有些心烦,耽误了其他工作的进展。

陈荣杰:在用etree解码时,pycham报错,显示没有这个模块

王嵚:不会爬虫

黄彬煌:一开始浏览了关于福州有几个商圈的问题,得到的都是模糊的概念,没有具体定案。然后尝试在口碑,淘宝,美团几个网站寻找关于服饰类的商品,希望能得到类似于商家发布地的筛选,然后再通过发布地反推归类到几个模糊的商圈地,最后再完成最佳服饰类商圈统计等操作。但是,找不到关于服饰类的分类。最后,通过对服饰类关键字的搜索,成功在美团上找到商品,更喜人的是,美团还有自带对商圈的划分。但是在用爬虫技术对网站进行操作时,因为对爬虫知识的不熟悉,几乎是遇到一个问题便解决一个,但最后卡在了python里的html模块的fromstring函数显示没有此函数。

吴智勇:1.口碑api似乎是为了给加入商户使用的,不够友好。2.lxmlstring函数使用中遇到了困难3.对于同一界面的不同选项,对于网页属性来说似乎没有任何改变

林家伟:1.在爬?取美团美食网页数据时,用python的lxml库一直无法定位到标签获取店铺链接2.讲爬取到的数据分类保存到本地t?xt文件,python读取文件数据出现许多格式问题

杨锦镔:问同学,百度,勉强能够提取出部分信息。

黄智锋:网上阅览图片,找出清晰度较高且符合主题的图片,修改图片主要是利用ps反复配色,寻找最适合的修改方案。

刘汪洋:互相讨论商量,找到都觉得好的共识。

苏凯婷:工具在一开始就进行了及时安装,队友很快告诉我可以通过直接在美团上搜索商圈获得信息,对于程序出现的报错以及暂时性的语法的遗忘,通过查看自己第一次编程的作业得到了很好的解决。

鲍冰如:后来觉得百度地图的商圈信息比较符合要求,然后开始疯狂尝试爬取,kt是我的救星,坐在我旁边,给我分享她搜索到的有用的网站,还会给我解释一些技术问题,在一定程度上解决了我的技术方面的问题,虽然最后还是没搞出来,但是kt完成了,不要脸地说一句Kt完成了就是我们完成了。

张逸杰:最终还是百度了报错然后修改成功,改用正则匹配的形式爬取。

陈荣杰:lxml版本下错了了,更新一下就好

王嵚:上网百度

黄彬煌:只能另寻其他方法模板去爬取网站上的信息。

吴智勇:没解决

林家伟:1.由于实在找不到原因,所以放弃使用lxml,利用正则表达式提取所需数据2.利用eval(),split?(),强制转换等方式,在提取数据后,对数据进行字符串,字典,列表的转换

杨锦镔:如果以前的空闲时间能拿来学习,那么今天我一定能做出来。

黄智锋:如果这蛇皮机房电脑网速不那么慢那么卡,那么这背景图也不会那么丑

刘汪洋:如果我会爬虫,那么可能能给他们帮上点忙。

苏凯婷:如果没有那么菜那么就不会这么惨了

鲍冰如:如果没有kt,那么我会更菜

张逸杰:如果我的组织和领导能力再强一点,编码能力再强一点,我们组一定能够做完,没做完很可惜。

陈荣杰:如果我会爬虫,那么我就能按时完成

王嵚:如果我前一天晚上好好准备一下 今天也就至于这么废物

黄彬煌:如果很早的时候就掌握了爬虫,那么就没那么多事了

吴智勇:如果团队协作交流能更加紧密,那么过程因该会更加顺利

林家伟:如果我能再强一点,就能够带zyj飞

| 组员名字 | 张逸杰 | 黄彬煌 | 吴智勇 | 苏凯婷 | 鲍冰如 | 黄智锋 | 陈荣杰 | 杨锦镔 | 王嵚 | 林家伟 | 刘汪洋 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 贡献比例 | 12 | 10 | 8 | 10 | 10 | 10 | 8 | 8 | 7 | 9 | 8 |

| PSP2.1 | Personal Software Process Stages | 预估耗时(分钟) | 实际耗时(分钟) |

|---|---|---|---|

| Planning | 计划 | 10 | 20 |

| Estimate | 估计这个任务需要多少时间 | 5 | 5 |

| Development | 开发 | 10 | 10 |

| Analysis | 需求分析 (包括学习新技术) | 60 | 150 |

| Design Spec | 生成设计文档 | 0 | 0 |

| Design Review | 设计复审 | 0 | 0 |

| Coding Standard | 代码规范 (为目前的开发制定合适的规范) | 10 | 10 |

| Design | 具体设计 | 10 | 15 |

| Coding | 具体编码 | 60 | 140 |

| Code Review | 代码复审 | 10 | 10 |

| Test | 测试(自我测试,修改代码,提交修改) | 30 | 20 |

| Reporting | 报告 | 0 | 0 |

| Test Repor | 测试报告 | 0 | 0 |

| Size Measurement | 计算工作量 | 0 | 0 |

| Postmortem & Process Improvement Plan | 事后总结, 并提出过程改进计划 | 10 | 10 |

| 合计 | 215 | 400 |

| 第N周 | 新增代码(行) | 累计代码(行) | 本周学习耗时(小时) | 累计学习耗时(小时) | 重要成长 |

|---|---|---|---|---|---|

| 9 | 250 | 2050 | 20 | 100 | 学会了一些简单的爬虫知识 |

标签:arm 发布 读取文件 配色 imp 想法 美团网 oms 截图

原文地址:https://www.cnblogs.com/yellow-2018/p/11784005.html