标签:矩阵 尺度 数据 实现 比较 网络层 样本 结果 增加

讲授卷积神经网络面临的挑战包括梯度消失、退化问题,和改进方法包括卷积层、池化层的改进、激活函数、损失函数、网络结构的改 进、残差网络、全卷机网络、多尺度融合、批量归一化等

大纲:

面临的挑战

梯度消失问题

退化问题

改进的总体思路

卷积层的改进

用矩阵乘法实现卷积运算

池化层的改进

激活函数的改进

损失函数的改进

高速公路网络

残差网络

残差网络的分析

全卷积网络

多尺度连接

批量归一化

本集总结

面临的挑战:

卷积神经网络尤其是深度卷积神经网络面临的挑战:

梯度消失问题,全连接神经网络(也叫人工神经网络ANN、多层感知器模型HLP)也提到了,BP传播时要用到f‘(x),如果f‘(x)<0,会越乘越小,最终梯度趋向于0,那么参数就没法更新了。

退化问题,指网络比较浅的时候,只要样本数量足够多,增加网络层数网络的精度会上升,但是要是网络达到一定层数时再增加层数网络的精度反而会下降。

过拟合问题,深度卷积神经网络一般层数比较多,宽度也比较大,每次神经元和卷积核数量也比较大,这样很容易产生过拟合问题。

计算和存储效率问题,过了追求网络精度,人们把网络做的越来越复杂,深度非常大宽度也很大,网络规模大了之后,不仅算的很慢因为运算的次数会增加,而且很占用存储空间,这样就会限制它的实际的使用。

改进的措施:

卷积层

池化层

激活函数

损失函数

网络结构

梯度消失问题:

深层网络难以训练,主要原因是梯度消失问题

X. Glorot, Y. Bengio. Understanding the difficulty of training deep feedforward neural networks. AISTATS, 2010

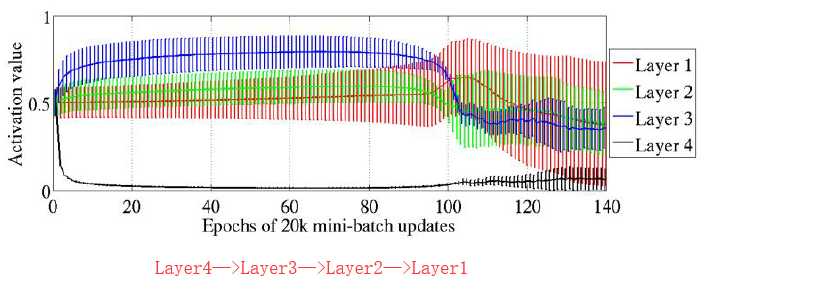

在实验中,分别训练了有1到5个隐含层的神经网络,激活函数使用了sigmoid,tanh等

实验结果证明,随着网络层数的增加,反向传播的作用越来越小,网络更加难以训练

激活函数的输入值容易落入饱和区间,导致过拟合

退化问题:

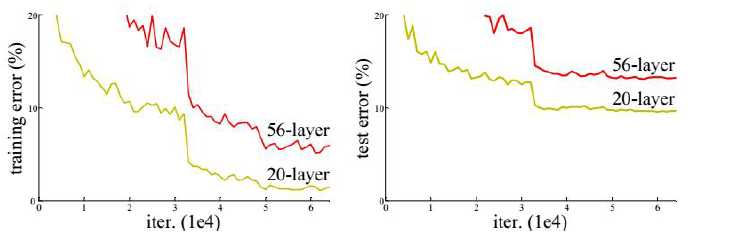

增加网络的层数可以提高网络的精度,但增加到一定程度之后,随着层次的增加,神经网络的训练误差和测

试误差会增大,这个问题称为退化 - 类似维数灾难

退化问题与过拟合不同,过拟合是在测试集上精度差,而退化是在训练集和测试集上精度都下降

改进的总体思路:

改进的目标是网络的精度更高、运行的速度更快。

卷积层

池化层

激活函数

损失函数

网络结构

数据归一化

卷积层的改进:

标签:矩阵 尺度 数据 实现 比较 网络层 样本 结果 增加

原文地址:https://www.cnblogs.com/wisir/p/11839059.html