标签:一起 分析 基本 语言 不同的 维数 code mamicode 向量

讲授LDA基本思想,寻找最佳投影矩阵,PCA与LDA的比较,LDA的实际应用

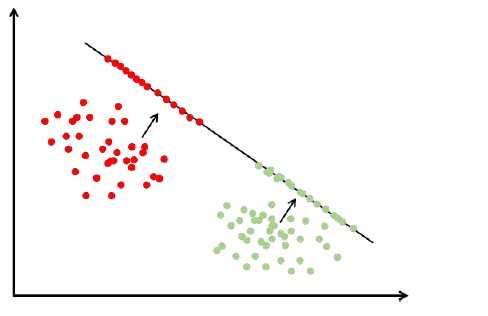

前边讲的数据降维算法PCA、流行学习都是无监督学习,计算过程中没有利用样本的标签值。对于分类问题,我们要达到的目标是提取或计算出来的特征对不同的类有很好的区分度,由于没有用样本的标签值,会导致一个问题,不同的两类样本,如A和B类投影之后交杂在一起无法区分开来,所以这种投影结果对于分类是不利的。线性判别分析LDA是以分类为目的的降维投影技术,把向量X变换为Y,Y的维数更低 ,Y要对分类比较有利能把不同的类有效的区分开来。

大纲:

LDA的思想

寻找最佳投影方向

推广到高维

与PCA的比较

实验环节

实际应用

LDA的思想:

主成分分析,流形降维算法都是无监督学习,整个计算过程中没有利用样本标签值,它们投影的结果对分类未必有利

能不能有一种算法,对数据投影之后,能够更便于分类?

分类要达成的目标:

区分不同的类,同一类的样本特征要尽量相似,不同类之间要尽可能不同,线性判别分析就是达成这种目标的一种线性算法。

目标最直观的表达是,最大化类间差异,最小化类内差异,数学的语言来表达就是方差比较小,使同类样本投影后聚集在一起,不同类样本离得尽可能远。

一维映射y=wTx:

寻找最佳投影方向:

问题的关键是如何得到最佳投影矩阵。

同PCA一样,首先考虑映射到一维的情况,然后考虑映射到高维的情况。

标签:一起 分析 基本 语言 不同的 维数 code mamicode 向量

原文地址:https://www.cnblogs.com/wisir/p/11872841.html