标签:参考 ali 叠加 中心 csu alt div inline 一个

作用:

| TF调用 | 公式 | 图像 | 导数 | 优点 | 缺点 | |

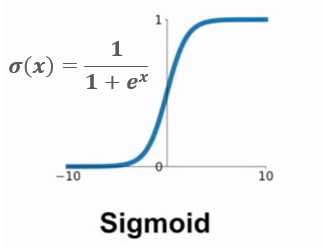

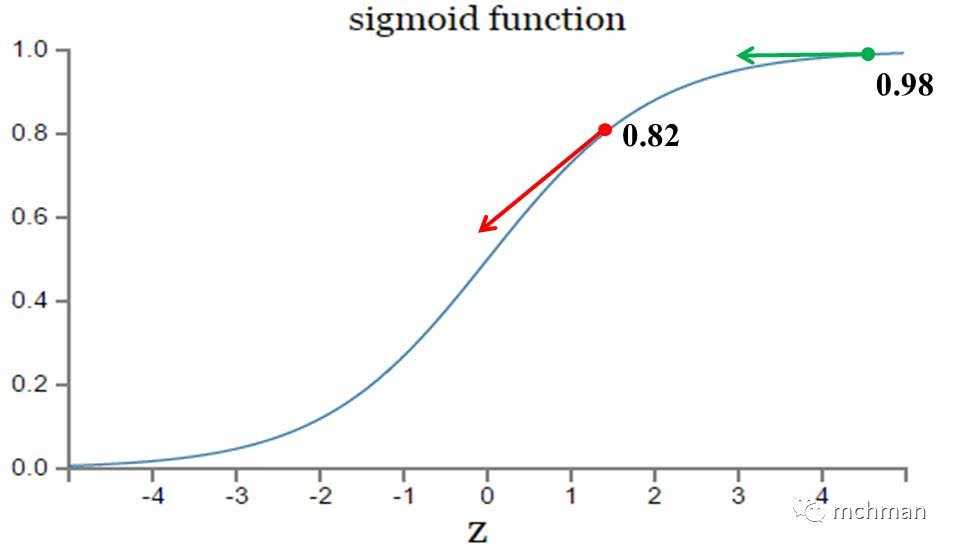

| sigmoid | |

|

梯度反向传递时导致梯度爆炸和梯度消失 其中梯度爆炸发生的概率非常小 而梯度消失发生的概率比较大。 sigmoid输出永远是正数;非零中心 |

|||

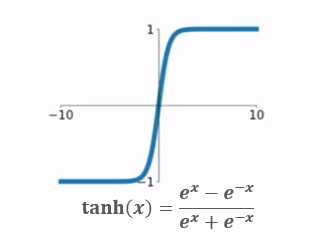

| tanh | 输出(-1,1) | 没有解决“梯度消失问题” | ||||

| ReLU | 不会有梯度消失问题 | 输入负数,则完全不激活,ReLU函数死掉 | ||||

| Leaky ReLU(LReLU) | ||||||

| ELU | ||||||

| Maxout | ||||||

| softmax |

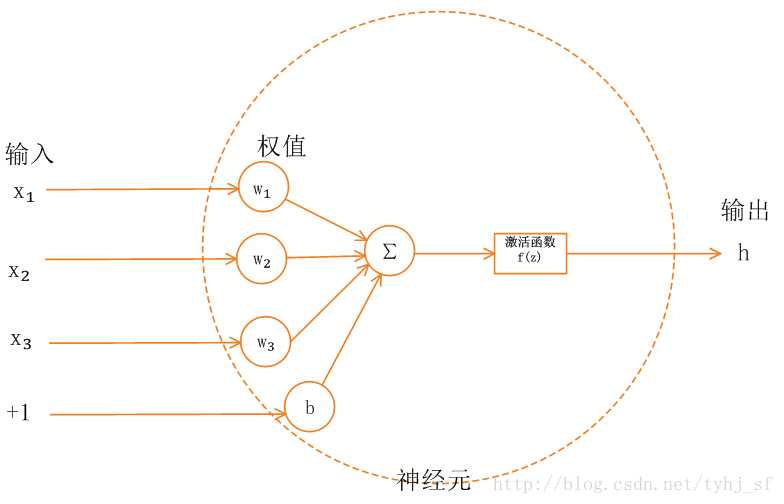

1.sigmoid函数

2.tanh

3.relu

4.softmax

,其中k为类别的个数。

在同一个模型中,激活函数不会混搭使用,选定一个就用一个。一般最好的经验法则是使用ReLU函数,但是要谨慎的调节学习率。像LReLU,PReLU,ELU,Maxout这些函数则实验性强一点(实用性弱一点),但也可以试下。tanh和sigmoid就em....,算了吧。

参考:

https://segmentfault.com/a/1190000016048441

https://blog.csdn.net/tyhj_sf/article/details/79932893

https://www.jianshu.com/p/d49610e55632

标签:参考 ali 叠加 中心 csu alt div inline 一个

原文地址:https://www.cnblogs.com/yrm1160029237/p/11926010.html