标签:本地 mat 实用 命令 bash namenode scp div ado

hadoop配置

一、首先写两个实用的小脚本

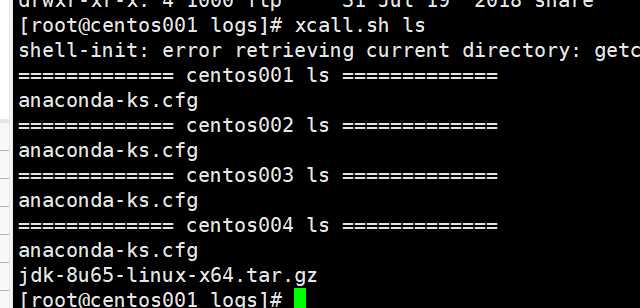

1、执行命令 :xcall.sh ls

则可以在四台机器上循环执行命令 ls(首先需要支持ssh免密登陆)

#!/bin/bash params=$@ i=201 for (( i=201 ; i <= 204 ; i = $i + 1 )) ; do echo ============= s$i $params ============= ssh s$i "$params" done

2、可以使用命令xscp.sh /soft/download/

把download下的所有文件传到其他三台服务器对应目录下(首先需要支持ssh免密登陆)

#!/bin/bash if [[ $# -lt 1 ]] ; then echo no params ; exit ; fi p=$1 #echo p=$p dir=`dirname $p` #echo dir=$dir filename=`basename $p` #echo filename=$filename cd $dir fullpath=`pwd -P .` #echo fullpath=$fullpath user=`whoami` for (( i = 202 ; i <= 204 ; i = $i + 1 )) ; do echo ======= s$i ======= rsync -lr $p ${user}@s$i:$fullpath done ;

二、了解hadoop基本配置文件

找到所有的配置文件

----------------------

1.tar开hadoop-2.7.3.tar.gz

hadoop-2.7.3\share\hadoop\common\hadoop-common-2.7.3.jar\core-default.xml

hadoop-2.7.3\share\hadoop\hdfs\hadoop-hdfs-2.7.3.jar\hdfs-default.xml

hadoop-2.7.3\share\hadoop\mapreduce\hadoop-mapreduce-client-core-2.7.3.jar\mapred-default.xml

hadoop-2.7.3\share\hadoop\yarn\hadoop-yarn-common-2.7.3.jar\yarn-site.xml

配置hadoop临时目录

---------------------

1.配置[core-site.xml]文件

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://s201/</value> </property> <!--- 配置新的本地目录 --> <property> <name>hadoop.tmp.dir</name> <value>/home/centos/hadoop</value> </property> </configuration>

//以下属性均由hadoop.tmp.dir决定,在hdfs-site.xml文件中配置。

dfs.namenode.name.dir=file://${hadoop.tmp.dir}/dfs/name dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data dfs.namenode.checkpoint.dir=file://${hadoop.tmp.dir}/dfs/namesecondary

2.分发core-site.xml文件

$>xscp.sh core-site.xml

3.格式化文件系统,只对namenode的本地目录进行初始化。

$>hadoop namenode -format //hdfs namenode -format

4.启动hadoop

$>start-all.sh

标签:本地 mat 实用 命令 bash namenode scp div ado

原文地址:https://www.cnblogs.com/pinghengxing/p/12050402.html