标签:多个 依次 lock cos 意义 神经元 als 重要 layer

![]()

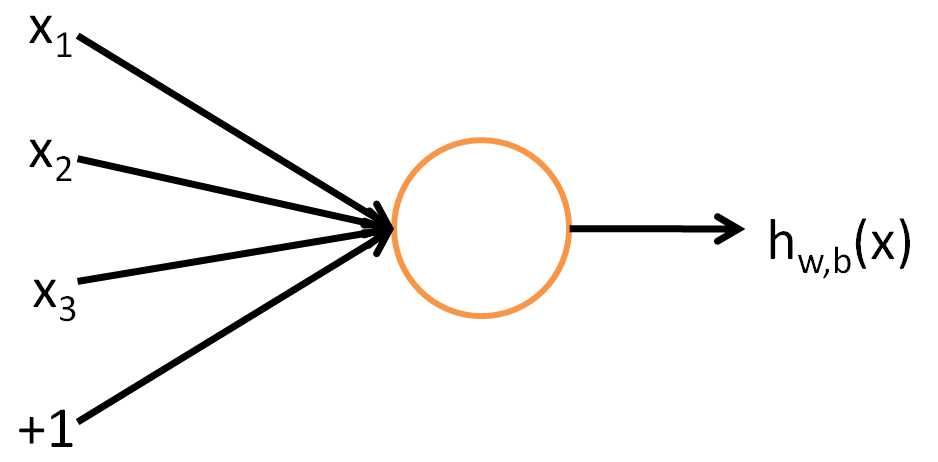

xi为输入,wi为各项输入的权重,b为偏差,f为激活函数,h为输出。输入的加权和,经过激活函数映射为输出。

sigmoid函数

将加权和缩放到[0,1],微分形式为

tanh函数

将加权和缩放到[-1,1] ,微分形式为

线性整流函数

分段函数,实际神经网络中更好用。梯度=0(z<0),t梯度=1(z>0)

注:分类问题:使用sigmoid函数,label y=0 or 1, 使用tanh函数, label y = -1 or 1.

回归问题:[0,1];[-1,1]

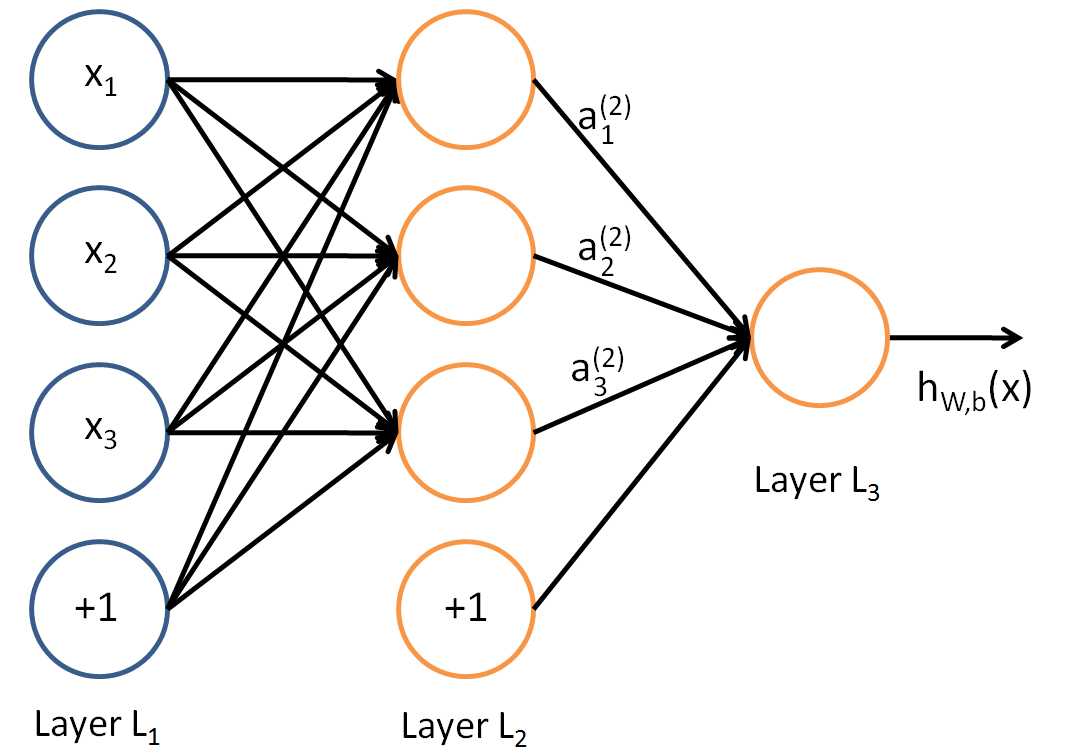

神经网络本质是多个神经元连接组成的层级结构,上一层的输出为下一层的输入。

基本概念:输入层,输出层,隐藏层略。

基本表示符号略。

前向传播:上一层的输出作为本层的输入,依次逐层向后传播。

![]()

某个样本的代价:所有样本的代价:第一项为所有样本代价的平均值,第二项为权重正则化项regularization(权重衰减项weight decay),避免权重太大引起过拟合.λ为权重衰减参数。

标签:多个 依次 lock cos 意义 神经元 als 重要 layer

原文地址:https://www.cnblogs.com/ceciliaxu/p/12056940.html