标签:font 一个 预测 决定 sub 线性回归 相对 在线 code

代价函数:又称损失函数,我的理解是用于更好地拟合样本,得到更合适模型的一个方法。

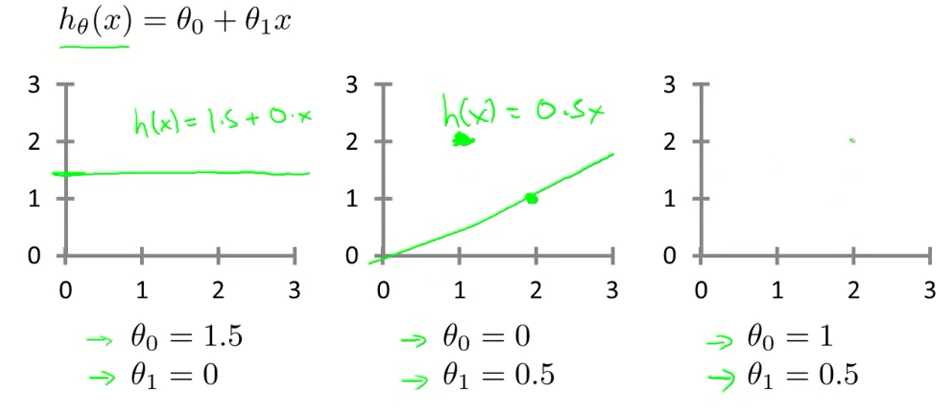

在线性回归中,假设函数为 hθ(x) = θ0 + θ1 * x ,其中θ0和θ1的变化会引起假设函数的变化,参数的选择决定了我们得到的直线相对于训练集的准确度。

为了让预测值和真实值的误差尽可能小和最小化θ0和θ1,我们将这个问题转化为找到能使训练集中预测值和真实值的差的平方的和的1/2M最小的θ0和 θ1的值。

于是我们定义

![]()

为代价函数,又称为平方误差函数,它是解决回归问题最常用的手段。其中 m 代表训练集样本数量, xi 代表第 i 个样本,hθ(xi) 代表第 i 个样本对应的预测值, yi 代表第 i 个样本对应的真实值。

更直观地理解代价函数

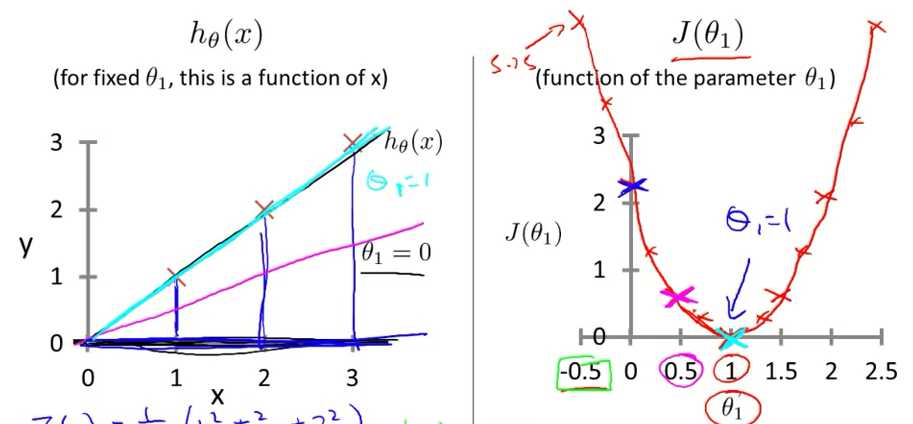

为了更加直观的理解代价函数,首先我们先令θ0 = 0,并选取不同的θ1作为假设函数的参数θ1,通过不同的模型和代价函数,可得出代价函数 J(θ1) 与 θ1的关系如下图:

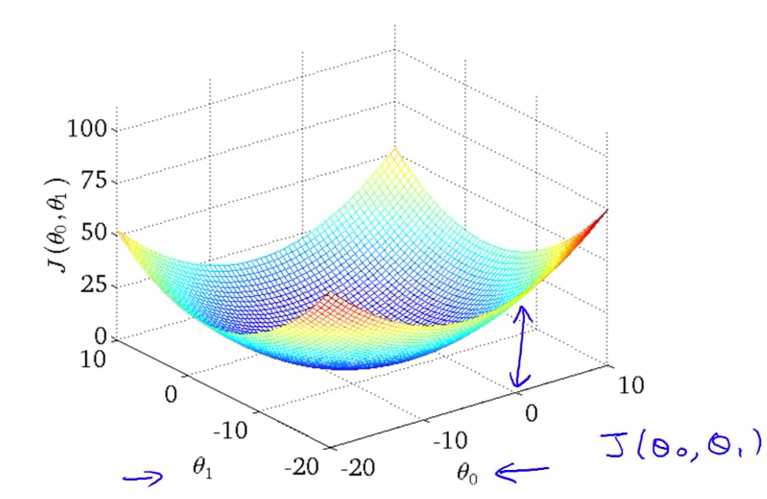

这次我们分别选取不同的θ0和θ1,引入不同的模型,作出J(θ1) 与 θ1、的θ0 关系图如下:

这是一个碗状的3D图, 碗底即代价函数 J(θ0,θ1) 的最低点,对应的θ0和θ1即为最小。

标签:font 一个 预测 决定 sub 线性回归 相对 在线 code

原文地址:https://www.cnblogs.com/feng-fengfeng/p/12213081.html