标签:-- 特征 问题 规模 中间 alpha 复杂 循环 str

在我们的前向传播和后向传播实现中使用的“缓存”是什么?

A.它用于在训练期间缓存成本函数的中间值。

B.我们用它将在正向传播过程中计算的变量传递到相应的反向传播步骤。它包含了反向传播计算导数的有用值。

C.它用于跟踪我们正在搜索的超参数,以加快计算速度。

D.我们用它将反向传播过程中计算的变量传递到相应的正向传播步骤。它包含用于计算正向传播的激活的有用值。

以下哪些是“超参数”?(选出所有正确项)

A.隐藏层规模\(n^{[l]}\)

B.神经网络的层数\(L\)

C.激活向量\(a^{[l]}\)

D.权重矩阵\(W^{[l]}\)

E.学习率\(\alpha\)

F.迭代次数

G.偏置向量\(b^{[l]}\)

下列哪个说法是正确的?

A.神经网络的更深层通常比前面的层计算更复杂的特征

B.神经网络的前面的层通常比更深层计算更复杂的特性

向量化允许您在L层神经网络中计算前向传播时,不需要在层l = 1, 2, …, L间显式的使用for循环(或任何其他显式迭代循环)

A.对

B.不对

假设我们将\(n^{[l]}\)的值存储在名为layers的数组中,如下所示:layer_dims = [n_x, 4, 3, 2, 1]。 因此,第1层有4个隐藏单元,第2层有3个隐藏单元,依此类推。 您可以使用哪个for循环初始化模型参数?

A.

for(i in range(1, len(layer_dims/2))):

parameter[‘W’ + str(i)] = np.random.randn(layers[i], layers[i - 1])) * 0.01

parameter[‘b’ + str(i)] = np.random.randn(layers[i], 1) * 0.01B.

for(i in range(1, len(layer_dims/2))):

parameter[‘W’ + str(i)] = np.random.randn(layers[i], layers[i - 1])) * 0.01

parameter[‘b’ + str(i)] = np.random.randn(layers[i-1], 1) * 0.01C.

for(i in range(1, len(layer_dims))):

parameter[‘W’ + str(i)] = np.random.randn(layers[i-1], layers[i])) * 0.01

parameter[‘b’ + str(i)] = np.random.randn(layers[i], 1) * 0.01D.

for(i in range(1, len(layer_dims))):

parameter[‘W’ + str(i)] = np.random.randn(layers[i], layers[i-1])) * 0.01

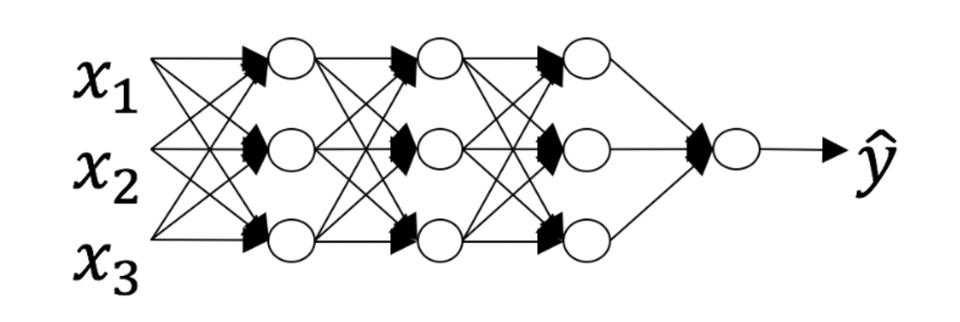

parameter[‘b’ + str(i)] = np.random.randn(layers[i], 1) * 0.01考虑以下神经网络:

该神经网络有几层?

A.层数\(L\)是4,隐藏层数是3

B.层数\(L\)是3,隐藏层数是3

C.层数\(L\)是4,隐藏层数是4

D.层数\(L\)是5,隐藏层数是4

在前向传播期间,在层\(l\)的前向传播函数中,您需要知道层\(l\)中的激活函数(Sigmoid,tanh,ReLU等)是什么。在反向传播期间,相应的反向传播函数也需要知道第\(l\)层的激活函数是什么,因为梯度是根据它来计算的

A.对

B.不对

有一些函数具有以下特性:

(i) 当使用浅网络计算时,需要一个大网络(我们通过网络中的逻辑门数量来度量大小),但是(ii)当使用深网络来计算时,我们只需要一个指数级小的网络

A.对

B.不对

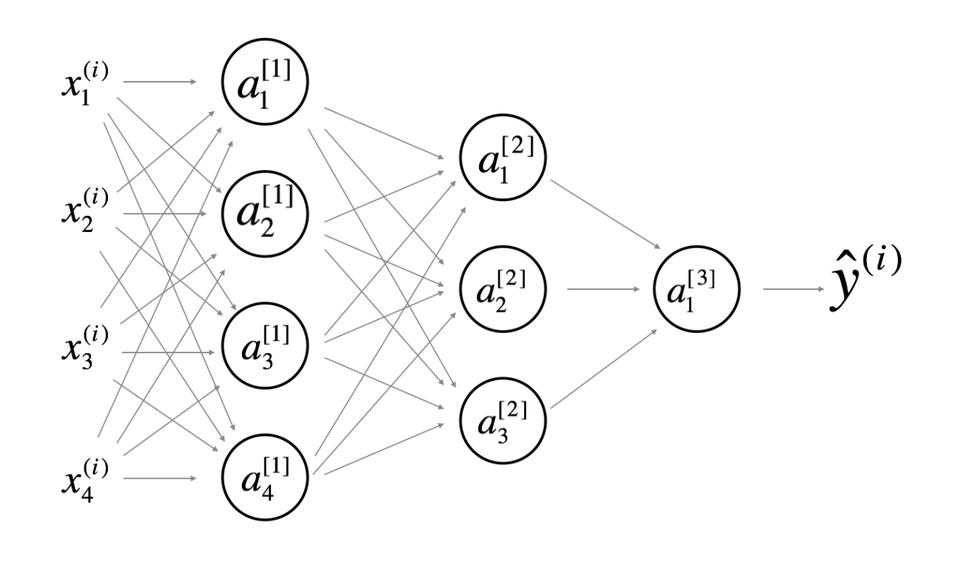

在以下2层隐藏层的神经网络中,以下哪句话是正确的?

A.\(W^{[1]}\) 的形状是 (4, 4)

B.\(b^{[1]}\) 的形状是 (4, 1)

C.\(W^{[2]}\) 的形状是 (3, 4)

D.\(b^{[2]}\) 的形状是 (3, 1)

E.\(b^{[3]}\) 的形状是 (1, 1)

F.\(W^{[3]}\) 的形状是 (1, 3)

前面的问题使用了一个特定的网络,一般情况下,层\(l\)的权重矩阵\(W^{[l]}\)的维数是多少?

A.\(W^{[l]}\) 的形状是 \((n^{[l]},n^{[l-1]})\)

B.\(W^{[l]}\) 的形状是 \((n^{[l-1]},n^{[l]})\)

C.\(W^{[l]}\) 的形状是 \((n^{[l+1]},n^{[l]})\)

D.\(W^{[l]}\) 的形状是 \((n^{[l]},n^{[l+1]})\)

31.B 32.ABEF 33.A 34.B 35.D 36.A 37.A 38.A 39.ABCDEF 40.A

吴恩达深度学习课程第一课 — 神经网络与深度学习 — 第四周练习

标签:-- 特征 问题 规模 中间 alpha 复杂 循环 str

原文地址:https://www.cnblogs.com/YukiNote/p/12261987.html