标签:mic 图片 不同 语音识别 数据 thml 估计 ima 需要

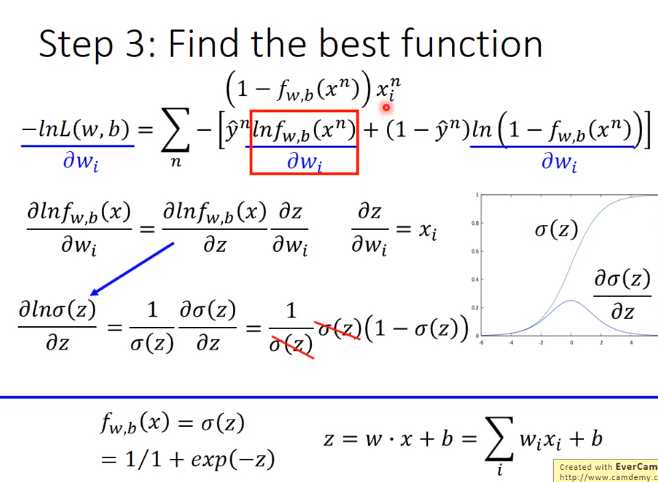

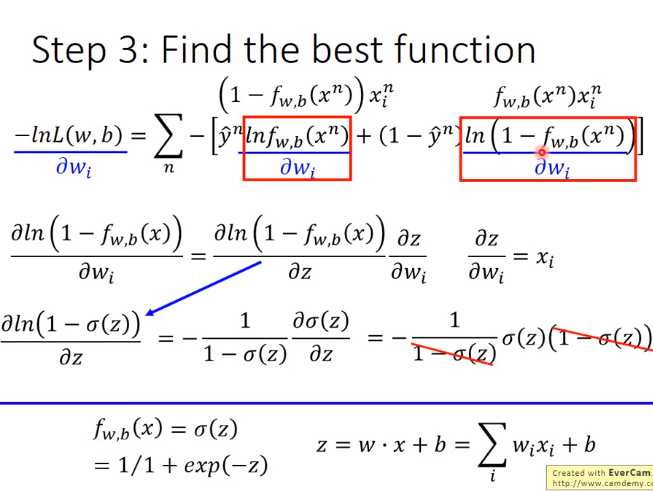

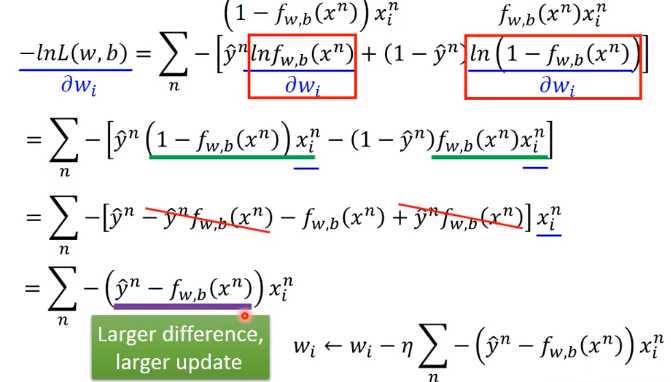

进行数学推导

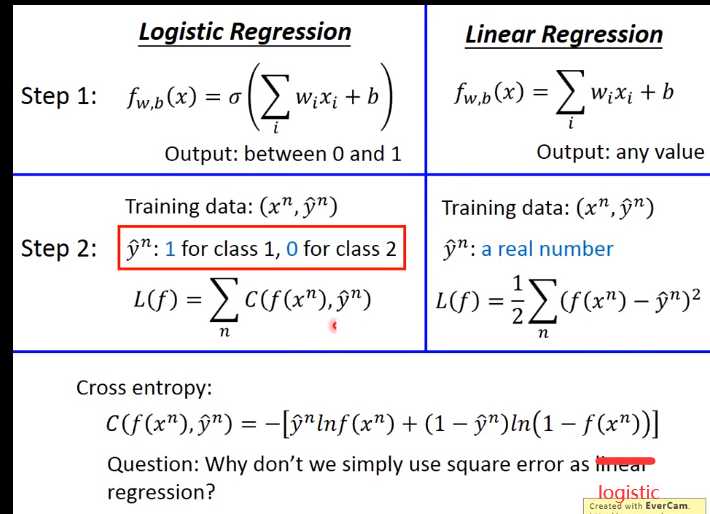

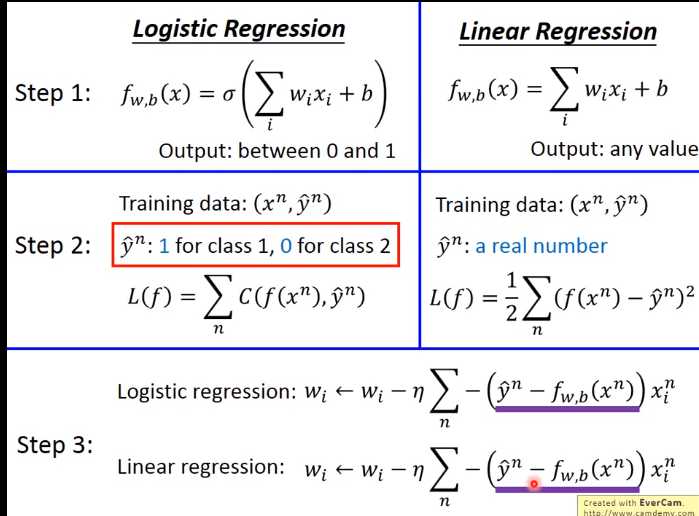

逻辑回顾与线性回顾的差异

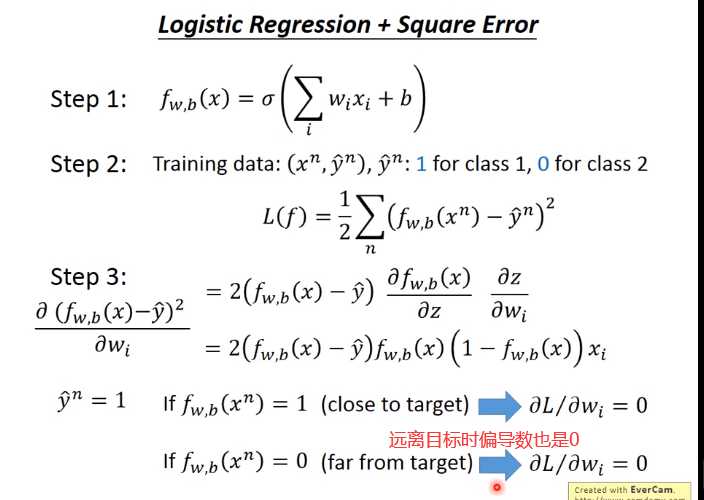

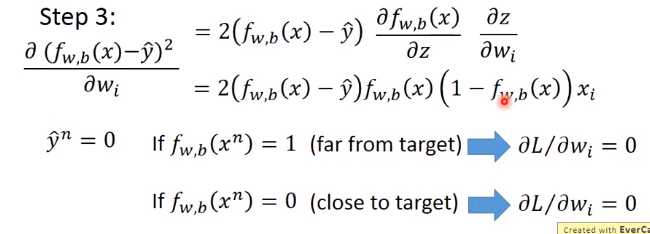

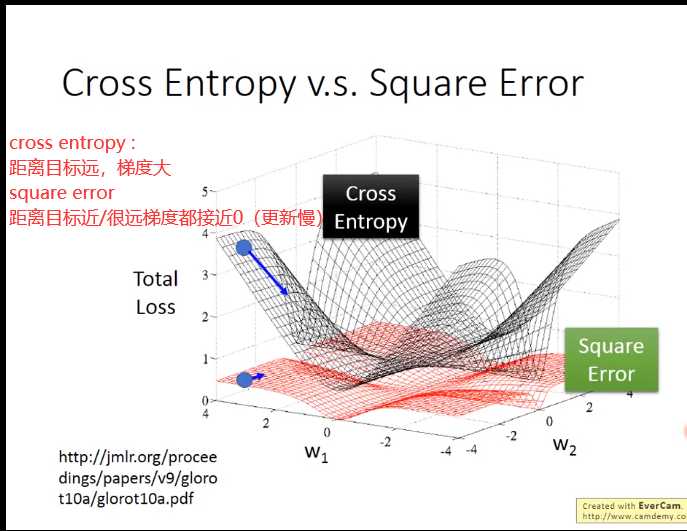

为什么logistic Regression 不能用square error

Discriminative vs Generative

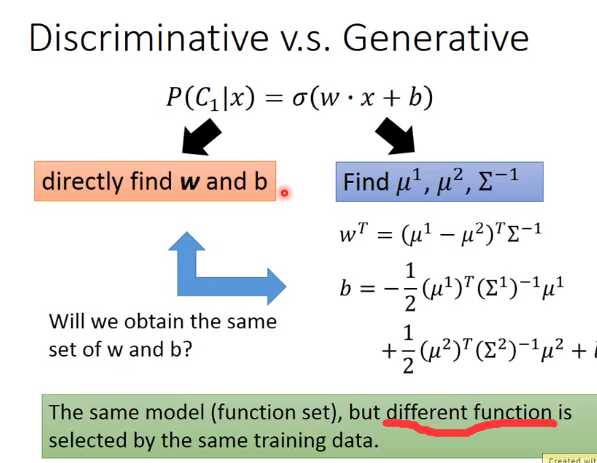

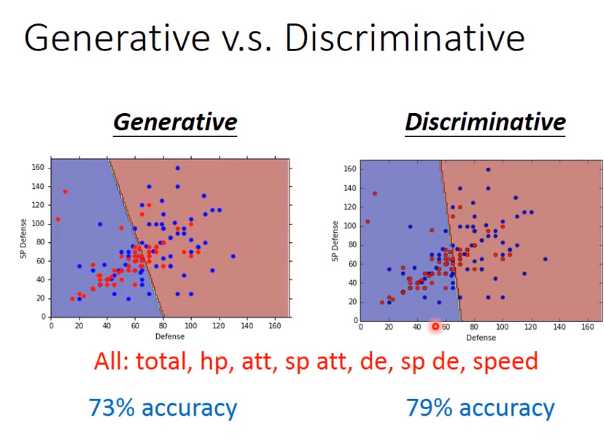

逻辑回归的方法称为Discriminative(判别) 方法;上一篇中用高斯来描述后验概率,称为 Generative(生成) 方法。它们的函数集都是一样的:

如果是逻辑回归,就可以直接用梯度下降法找出w和b;如果是概率生成模型,像上篇那样求出 μ^1,μ^2μ1,μ2 ,协方差矩阵的逆,然后就能算出w和b。

用逻辑回归和概率生成模型找出来的w和b是不一样的。

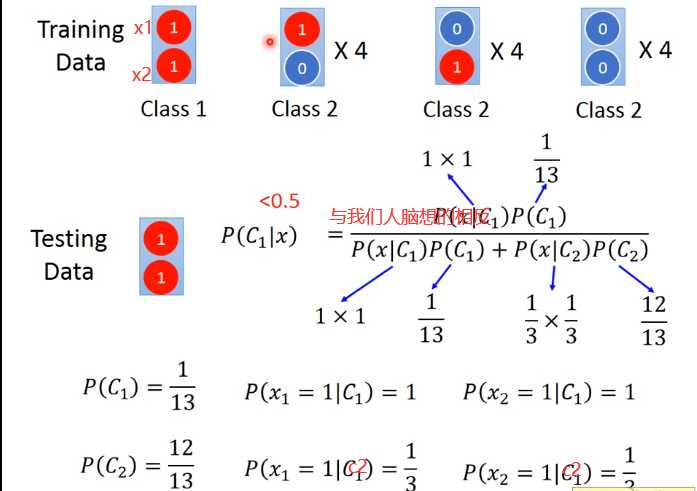

generative model 做了某些假设

Naive Bayes(贝叶斯)没有考虑不同维度间的关系

那么在class 2里面没有(1 1 )因为data 不够多,(1 1)也是有可能被产生的。因此贝叶斯会脑补这些情况

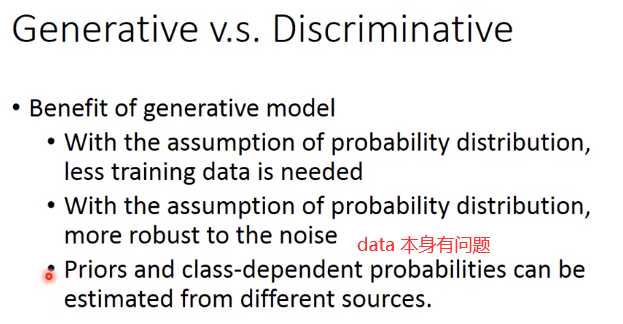

生成方法的优势:

训练集数据量很小的情况;因为判别方法没有做任何假设,就是看着训练集来计算,训练集数量越来越大的时候,error会越小。而生成方法会自己脑补,受到数据量的影响比较小。 对于噪声数据有更好的鲁棒性(robust)。 先验和类相关的概率可以从不同的来源估计。比如语音识别,可能直观会认为现在的语音识别大都使用神经网络来进行处理,是判别方法,但事实上整个语音识别是 Generative 的方法,DNN只是其中的一块而已;因为还是需要算一个先验概率,就是某句话被说出来的概率,而估计某句话被说出来的概率不需要声音数据,只需要爬很多的句子,就能计算某句话出现的几率。

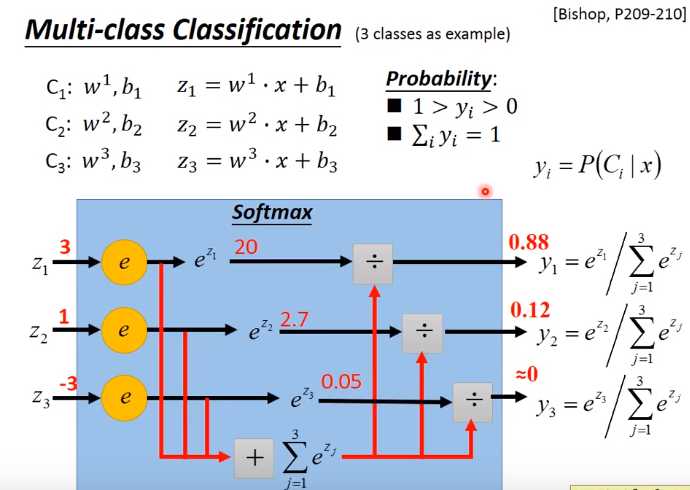

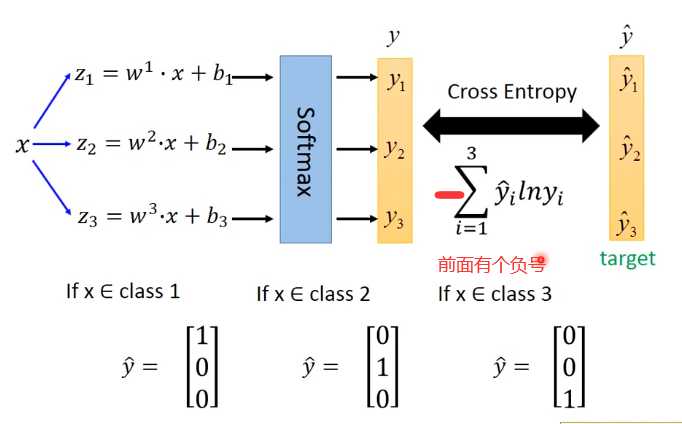

多类分类

siftmax 可以强化大的值

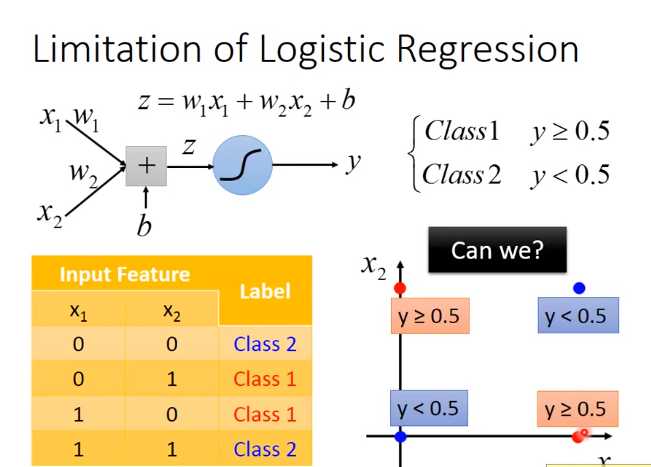

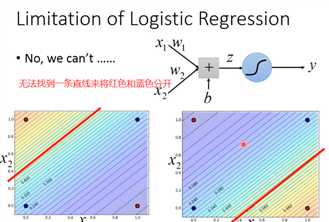

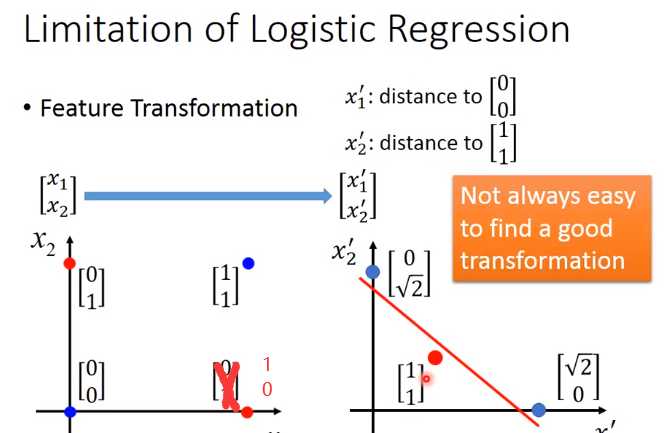

逻辑回归的限制

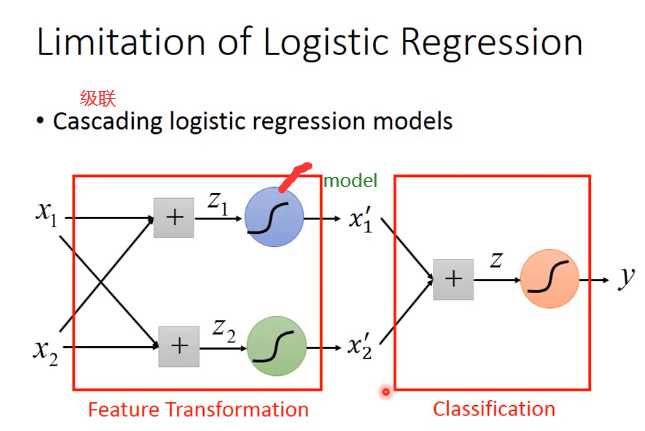

但是仍然想用逻辑回归,怎么办?

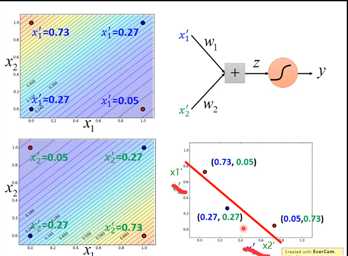

特征转化

那么如何让机器找到一个好的transformation

举个例子

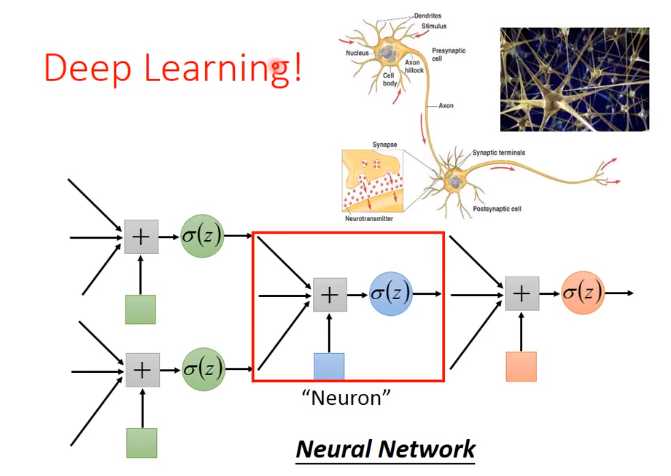

这种方式其实就是神经网络

标签:mic 图片 不同 语音识别 数据 thml 估计 ima 需要

原文地址:https://www.cnblogs.com/tingtin/p/12321465.html