标签:strong info ado 回顾 名称 dir flume 密码 val

分布式文件存储

信息源:

购买信息元(对海量数据清洗)

自营提供(限于大公司)

爬虫、抓包

信息格式:文件、文本、sql、json

分布式计算

离线批处理

MapReduce

spark

实时数据流

storm

spark

Sqoop数据迁移:hdfs-->mysql

flume数据上传,把本地的数据上传至hafs中

下载hadooop,jdk压缩包

安装到usr目录下

切换到usr目录下(cd)

分别解压压缩包(tar -zxvf 压缩包名)

删除压缩包(rm -rf 压缩包名称)

修改文件名,方便操作(mv 旧名称/ 新名称)

cat /etc/profile查看环境变量

配置环境变量 nano /etc/profile

export JAVA_HOME=/usr/jdk

export HADOOP_HOME=/usr/hadoop

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoopsource /etc/profile,若没有提示则生效成功切换到hadoop文件目录 /usr/hadoop/etc/hadoop

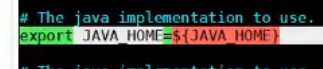

nano hadoop-env.sh找到如图

JAVA_HOME=usr/jdk ctrl+x保存退出source hadoop-env.sh配置 core-site.xml

在configuration中添加如下:

命令:nano core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.169.1:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp</value>

</property>注意:hdfs://虚拟机ip:8020

配置hdfs-site.xml

命令:nano hdfs-site.xml

在configuration中添加如下:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/hadoop/tmp/dfs/data</value>

</property>hadoop格式化

hdfs namenode-format

启动hadoop:start-dfs.sh

注意:启动进程可能要输入密码

jps关闭hadoop:stop-dfs.sh

标签:strong info ado 回顾 名称 dir flume 密码 val

原文地址:https://www.cnblogs.com/dreamzone/p/12329971.html