标签:square info sgd 拟牛顿法 技术 练习 微软雅黑 operator 推导

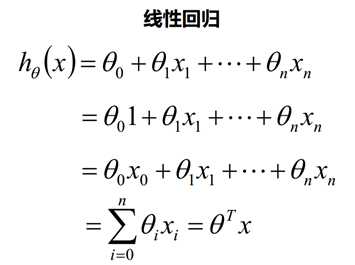

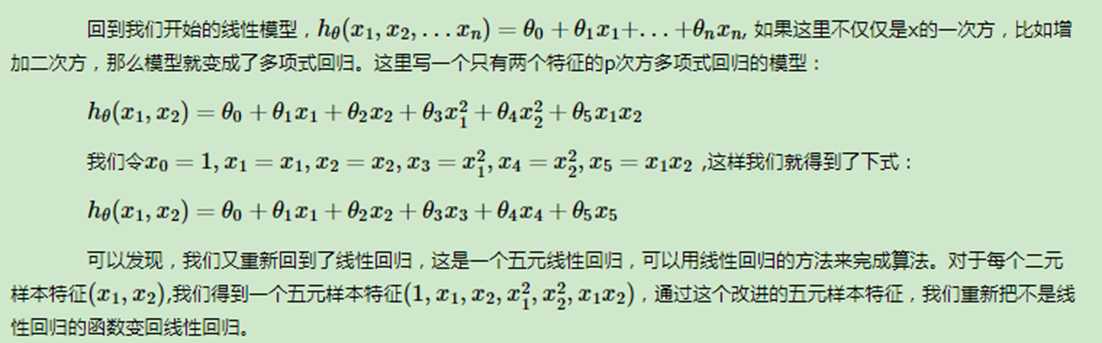

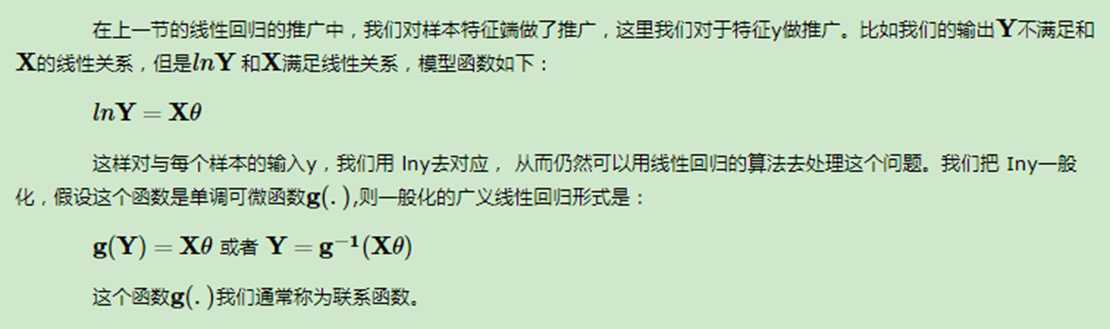

线性回归可以说是机器学习中最基本的问题类型了,这里就对线性回归的原理和算法做一个小结

附件:手写推导过程练习

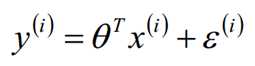

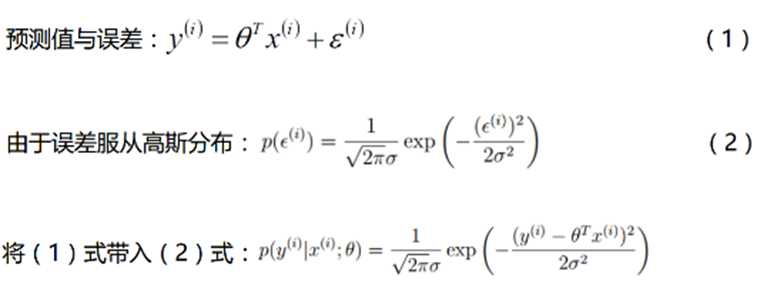

原因:中心极限定理

实际问题中,很多随机现象可以看做众多因素的独立影响的综合反应,往往服从正态分布

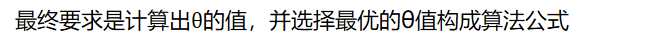

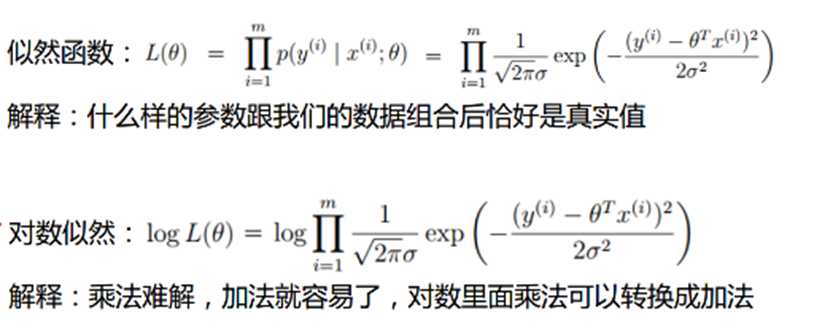

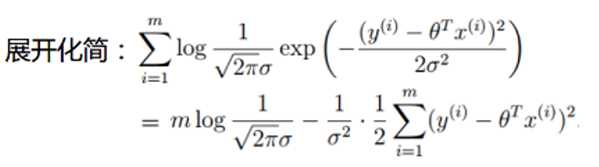

从最大似然函数角度出发,是使得最大似然越大越好,假设有m个样本,每个样本对应于n维特征和一个结果输出,如下:

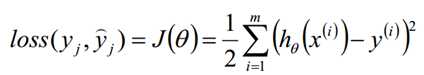

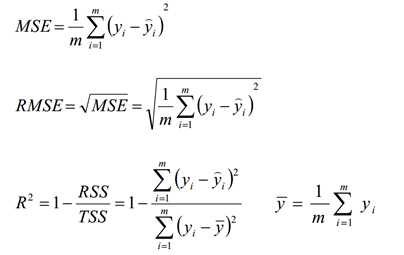

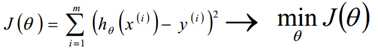

从上面式子的后半部分,要使得上式MAX,即使求解后半部分的MIN。这也和我们的目标减小ε的值,使其最小平方数和最小不谋而合:

由于矩阵法表达比较的简洁,后面我们将统一采用矩阵方式表达模型函数和损失函数。

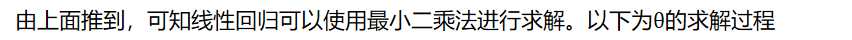

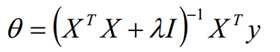

参数解析式:

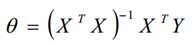

最小二乘法直接求解的难点:矩阵逆的求解是一个难处

具体可见另一篇文章:?最小二乘法(least squares)介绍

当然线性回归,还有其他的常用算法,比如牛顿法和拟牛顿法,这里不详细描述。

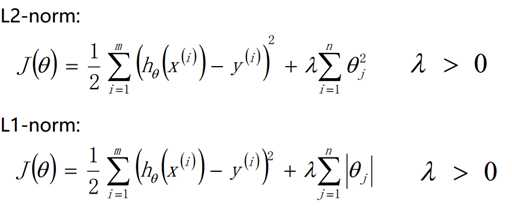

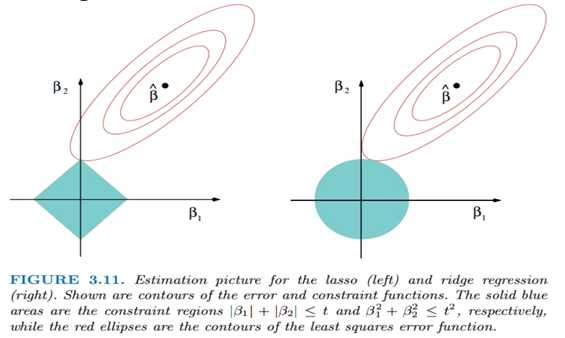

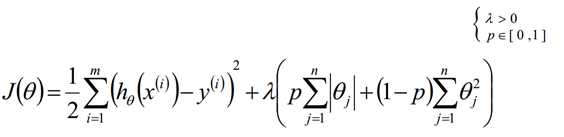

为了防止模型的过拟合,我们在建立线性模型的时候经常需要加入正则化项。一般有L1正则化和L2正则化。当然这种方法不是仅仅局限于在线性回归中使用,在后面很多机器学习方法中都有涉及。

使用L2正则的线性回归模型就称为Ridge回归(岭回归)。Ridge回归的求解比较简单,一般用最小二乘法。这里给出用最小二乘法的矩阵推导形式,和普通线性回归类似。

使用L1正则的线性回归模型就称为LASSO回归(Least Absolute Shrinkage andSelection Operator)

L1很容易产生为0的稀疏矩阵。因为这种情况下更容易交到坐标轴上。

总之:一般使用L2,除非希望得到系数解

? ?

标签:square info sgd 拟牛顿法 技术 练习 微软雅黑 operator 推导

原文地址:https://www.cnblogs.com/yifanrensheng/p/12354371.html