标签:过程 机器 机器学习 ima ack 根据 表示 期望值 训练

Softmax是用于分类过程,用来实现多分类的

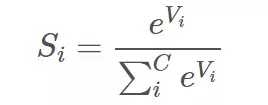

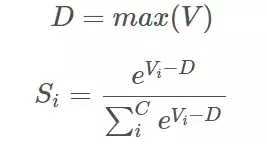

它把一些输出的神经元映射到(0-1)之间的实数,并且归一化保证和为1,从而使得多分类的概率之和也刚好为1。

Softmax可以分为soft和max,max也就是最大值,假设有两个变量a,b。如果a>b,则max为a,反之为b。那么在分类问题里面,如果只有max,

输出的分类结果只有a或者b,是个非黑即白的结果。但是在现实情况下,我们希望输出的是取到某个分类的概率,或者说,

我们希望分值大的那一项被经常取到,而分值较小的那一项也有一定的概率偶尔被取到,所以我们就应用到了soft的概念,即最后的输出是每个分类被取到的概率。

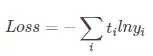

交叉熵:

标签:过程 机器 机器学习 ima ack 根据 表示 期望值 训练

原文地址:https://www.cnblogs.com/h694879357/p/12357003.html