标签:滤波器 数组 original 长度 form 浮点 环境 滤波 img

tf.get_variable(name, shape, initializer): name就是变量的名称,shape是变量的维度,initializer是变量初始化的方式,初始化的方式有以下几种:

tf.constant_initializer:常量初始化函数

tf.random_normal_initializer:正态分布

tf.truncated_normal_initializer:截取的正态分布

tf.random_uniform_initializer:均匀分布

tf.zeros_initializer:全部是0

tf.ones_initializer:全是1

tf.uniform_unit_scaling_initializer:满足均匀分布,但不影响输出数量级的随机值

import tensorflow as tf t = tf.truncated_normal_initializer(stddev=0.1, seed=1) v = tf.get_variable(‘v‘, [1], initializer=t) with tf.Session() as sess: for i in range(1, 10, 1): sess.run(tf.global_variables_initializer()) print(sess.run(v))

[-0.08113182]

[0.06396971]

[0.13587774]

[0.05517125]

[-0.02088852]

[-0.03633211]

[-0.06759059]

[-0.14034753]

[-0.16338211]

tf.truncated_normal_initializer 从截断的正态分布中输出随机值。

生成的值服从具有指定平均值和标准偏差的正态分布,如果生成的值大于平均值2个标准偏差的值则丢弃重新选择。

ARGS:

mean:一个python标量或一个标量张量。要生成的随机值的均值。

stddev:一个python标量或一个标量张量。要生成的随机值的标准偏差。

seed:一个Python整数。用于创建随机种子。查看 tf.set_random_seed 行为。

dtype:数据类型。只支持浮点类型

在tf.truncated_normal中如果x的取值在区间(μ-2σ,μ+2σ)之外则重新进行选择。这样保证了生成的值都在均值附近。

import tensorflow as tf

# 必须要使用global_variables_initializer的场合

# 含有tf.Variable的环境下,因为tf中建立的变量是没有初始化的,也就是在debug时还不是一个tensor量,而是一个Variable变量类型

size_out = 10

tensor = tf.Variable(tf.random_normal(shape=[size_out]))

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init) # initialization variables

print(sess.run(tensor))

# 可以不适用初始化的场合

# 不含有tf.Variable、tf.get_Variable的环境下

# 比如只有tf.random_normal或tf.constant等

size_out = 10

tensor = tf.random_normal(shape=[size_out]) # 这里debug是一个tensor量哦

init = tf.global_variables_initializer()

with tf.Session() as sess:

# sess.run(init) # initialization variables

print(sess.run(tensor))

tf.pad:填充函数

tf.pad( tensor,paddings, mode=‘CONSTANT‘,name=None)

1

tensor是要填充的张量

padings ,代表每一维填充多少行/列,它的维度一定要和tensor的维度是一样的,这里的维度不是传统上数学维度,如[[2,3,4],[4,5,6]]是一个3乘4的矩阵,但它依然是二维的,所以pad只能是[[1,2],[1,2]]这种。

mode 可以取三个值,分别是"CONSTANT" ,“REFLECT”,“SYMMETRIC”

mode=“CONSTANT” 填充0

mode="REFLECT"映射填充,上下(1维)填充顺序和paddings是相反的,左右(零维)顺序补齐

mode="SYMMETRIC"对称填充,上下(1维)填充顺序是和paddings相同的,左右(零维)对称补齐

t=[[2,3,4],[5,6,7]] print(tf.pad(t,[[1,1],[2,2]],"CONSTANT"))) 输出 [[0, 0, 0, 0, 0, 0, 0], [0, 0, 2, 3, 4, 0, 0], [0, 0, 5, 6, 7, 0, 0], [0, 0, 0, 0, 0, 0, 0]] 注:[1,1]是在pad里是第一个,代表第一维即矩阵的行,左边的1代表上方放一行0,右边的1代表下方放一行0 同理,2,2顺序是第二个,代表对列操作,左边的2代表在左边放两列0,右边2代表在右边放两列0 2. t=[[2,3,4],[5,6,7]] print(tf.pad(t,[[1,2],[2,3]],"CONSTANT"))) 输出 [[0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 2, 3, 4, 0, 0, 0], [0, 0, 5, 6, 7, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0]] 1,2代表上方一行0,下方2行0;2,3代表列坐标放2列0,右边放3列0 t=[[2,3,4],[5,6,7]] print(tf.pad(t,[[1,1],[2,2]],"REFLECT"))) 输出 [[7, 6, 5, 6, 7, 6, 5], [4, 3, 2, 3, 4, 3, 2], [7, 6, 5, 6, 7, 6, 5], [4, 3, 2, 3, 4, 3, 2]] 行上方复制和行下方和对应位置复制相反,列左边和列右边以原第一列和原第三列维中轴复制 t=[[2,3,4],[5,6,7]] print(tf.pad(t,[[1,1],[2,2]],"SYMMETRIC"))) 输出: [[3, 2, 2, 3, 4, 4, 3], [3, 2, 2, 3, 4, 4, 3], [6, 5, 5, 6, 7, 7, 6], [6, 5, 5, 6, 7, 7, 6]]

对于三维矩阵你可以理解为那是一幢楼,三维矩阵的由二维矩阵构成,每个二维矩阵相当于一个楼层。

1. 对于三维矩阵的pad,就是在 顶楼,底楼 ,每层楼的上 ,下,左,右补0

#pad1 = np.array([[‘顶’,‘底’],[‘上’,‘下’], [‘左’,‘右’ ]])

import numpy as np import tensorflow as tf tsr = tf.Variable(tf.ones([2, 3, 4]), name="tsr") pad_top = np.array([[1, 0], [0, 0], [0, 0]]) pad_left = np.array([[0, 0], [0, 0], [3, 0]]) pad_up= np.array([[0, 0], [1, 0], [3, 0]]) tsr_pad_top = tf.pad(tsr, pad_top, name=‘pad_top‘) tsr_pad_left = tf.pad(tsr, pad_left, name=‘pad_left‘) tsr_pad_up = tf.pad(tsr, pad_up, name=‘pad_up‘) with tf.Session() as sess: sess.run(tf.global_variables_initializer()) print(‘original tensor‘) print(sess.run(tsr)) print(‘ pad top‘) print(sess.run(tsr_pad_top)) print(‘pad left‘) print(sess.run(tsr_pad_left)) print(‘pad_up‘) print(sess.run(tsr_pad_up))

original tensor

[[[1. 1. 1. 1.]

[1. 1. 1. 1.]

[1. 1. 1. 1.]]

[[1. 1. 1. 1.]

[1. 1. 1. 1.]

[1. 1. 1. 1.]]]

pad top

[[[0. 0. 0. 0.]

[0. 0. 0. 0.]

[0. 0. 0. 0.]]

[[1. 1. 1. 1.]

[1. 1. 1. 1.]

[1. 1. 1. 1.]]

[[1. 1. 1. 1.]

[1. 1. 1. 1.]

[1. 1. 1. 1.]]]

pad left

[[[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]]

[[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]]]

pad_up

[[[0. 0. 0. 0. 0. 0. 0.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]]

[[0. 0. 0. 0. 0. 0. 0.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]

[0. 0. 0. 1. 1. 1. 1.]]]

tf.pad(tensor,paddings)

tesor 是要填充的张量;paddings 也是一个张量,代表每一维填充多少行/列。

x 是一个四维张量(batchsize, width, height, channels)

本例tensor的rank=4,即4维向量tensor.shape=[b,h,w,c],则padings=[a=[a1,a2],b=[b1,b2],c=[c1,c2],d=[d1,d2]]同样也是4维

填充后的行踪为[b+a1+a2,h+b1+b2,w+c1+c2,c+d1+d2](相应维度增加)

import tensorflow as tf input = np.ones([1, 5, 5, 1]) print(input.shape) kernel_size = 3 pad_begin = (kernel_size - 1) // 2 pad_end = kernel_size - 1 - pad_begin inputs = tf.pad(input, [[0, 0], [pad_begin, pad_end], [pad_begin, pad_end], [0, 0]]) print(pad_begin) print(pad_end) print(inputs) print(input) with tf.Session() as sess: inputs = sess.run(inputs) print(inputs)

(1, 5, 5, 1)

1

1

Tensor("Pad:0", shape=(1, 7, 7, 1), dtype=float64)

[[[[1.]

[1.]

[1.]

[1.]

[1.]]

[[1.]

[1.]

[1.]

[1.]

[1.]]

[[1.]

[1.]

[1.]

[1.]

[1.]]

[[1.]

[1.]

[1.]

[1.]

[1.]]

[[1.]

[1.]

[1.]

[1.]

[1.]]]]

[[[[0.]

[0.]

[0.]

[0.]

[0.]

[0.]

[0.]]

[[0.]

[1.]

[1.]

[1.]

[1.]

[1.]

[0.]]

[[0.]

[1.]

[1.]

[1.]

[1.]

[1.]

[0.]]

[[0.]

[1.]

[1.]

[1.]

[1.]

[1.]

[0.]]

[[0.]

[1.]

[1.]

[1.]

[1.]

[1.]

[0.]]

[[0.]

[1.]

[1.]

[1.]

[1.]

[1.]

[0.]]

[[0.]

[0.]

[0.]

[0.]

[0.]

[0.]

[0.]]]]

卷积操作 tf.nn.conv2d(input, filter, strides, padding, use_cudnn_on_gpu=None, data_format=None, name=None) data_format 可选参数,表示输入数据的格式,有两种分别为:“NHWC”和“NCHW”,默认格式为”NHWC“ “NHWC”输入数据的格式为为[batch, in_height, in_width, in_channels] “NCHW”输入数据的格式为为[batch, in_channels, in_height, in_width] use_cudnn_on_gpu 可选参数,表示是否使用GPU,默认为True,即有过有GPU,则默认使用GPU input 一个4维的数据格式,即输入数据的格式,跟data_format相关。即如果输入数据格式为”NCHW“的情况下需要设置data_format参数。 filter 一个长度为4的一维列表,[height,width,in_channels, out_channels],即filter的map大小,以及涉及到的输入特征图和输出特征图的个数。 strides 表示步长,是一个长为4的一维数组,跟data_format互相对应,表示在data_format每一维上的移动步长。例如输入格式默认格式”NHWC“,则strides的设置为[1,stride,stride,1]

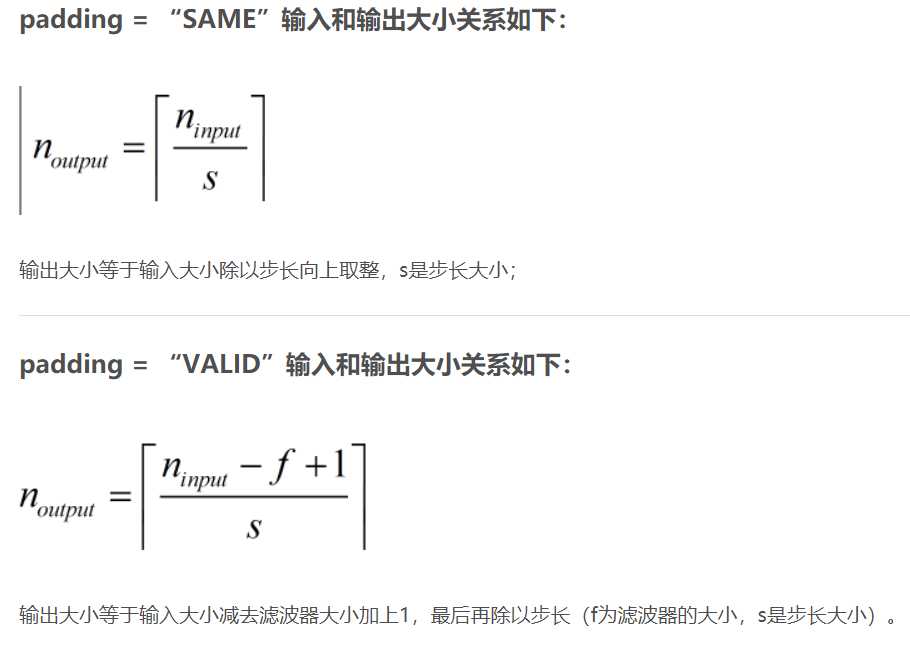

对应[batch,in_height, in_width, in_channels]第一个表示在一个样本的特征图上的移动,第二三个是在filter在特征图上的移动的跨度,第四个表示在一个样本的一个通道上移动。 padding 表示填充方式,”SAME”表示采用填充的方式 ,”VALID”表示采用不填充的方式,即输出大小跟输入大小不一样,输出大小= (输入图片大小-filter大小)/步长+1

输入图片大小 W×W

Filter大小 F×F (相当于卷积核大小,也可看作滤波器大小,卷积也是一种滤波)

步长 S(stride)

padding的像素个数 P

于是我们可以得出

N = (W − F + 2P )/S+1

输出图片大小为 N×N

图片输入大小和输出大小的关系

tensorflow官网定义的padding如下:

标签:滤波器 数组 original 长度 form 浮点 环境 滤波 img

原文地址:https://www.cnblogs.com/tingtin/p/12549445.html