标签:组成 stream 内推 架构 在服务器 mysql pps serve mys

作者:JackTian

微信公众号:杰哥的IT之旅(ID:Jake_Internet)

01. LAMP 系列教程(一)| 详解 Linux 环境下部署 HTTPD 服务

02. LAMP 系列教程(二)| 如何在 Linux 环境下部署 AWStats 分析系统来监控 Web 站点?

03. LAMP 系列教程(三)| 一文读懂 HTTPD 服务的访问控制

04. LAMP 系列教程(四)| MySQL 数据库系统(一)

05. LAMP 系列教程(五)| MySQL 数据库系统(二)- SQL语句的基本操作

06. LAMP 系列教程(六)| MySQL 数据库系统(三)- 数据库的用户授权

07. LAMP 系列教程(七)| MySQL 数据库系统(四)- 数据库的备份与恢复

08. LAMP 系列教程(八)| 带你轻松玩转 LAMP 网站架构平台(一)

09. LAMP 系列教程(九)| LAMP 架构应用案例 - 部署 PHPMyAdmin 系统(二)

01. Nginx 系列教程(一)| 手把手教你在 Linux 环境下搭建 Nginx 服务

02. Nginx 系列教程(二)| 一文带你读懂 Nginx 的正向与反向代理

当一台服务器的访问量越大时,服务器所承受的压力也就越大,超出自身所指定的访问压力就会崩掉,避免发生此类事情的发生,因此也就有了负载均衡来分担服务器的压力。

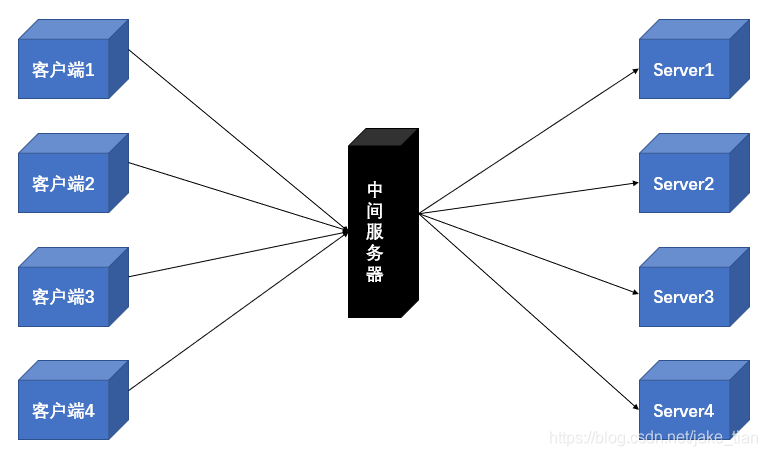

那么究竟什么是负载均衡呢?通俗些讲,就是我们有几十台、几百台甚至更多服务器,将这些服务器组成一个服务器集群,当客户端访问某台设备的数据时,首先发送的请求先到一台中间服务器,并通过中间服务器在服务器集群中平均分摊到其他服务器中,因此,当用户每次所发送的请求都将会保证服务器集群中的设备均与平摊,以此来分担服务器的压力,从而保持服务器集群的整理性能最优,避免出现有崩溃的现象。

转发功能:Nginx 会按照一定的算法轮询、权重将客户端发来的请求转发至不同的应用服务器上,同时减轻单台服务器的压力,提高服务器的并发量;

故障迁移:当一台服务器出现了故障时,客户端发来的请求将自动发送到其他服务器;

添加恢复:当故障服务器恢复正常工作时,将自动添加到处理用户请求中;

客户端发出的每个请求将按照时间顺序逐一分配到不同的后端服务器,如后端服务器down掉,能自动剔除。

upstream backserver {

server 192.168.1.10;

server 192.168.1.11;

}

weight 代表权重,默认为1,权重越高被分配的客户端也就越多。

指定轮询几率,weight和访问比率成正比,用于后端服务器性能不均的情况,也就是说:哪个 server 的连接数少,路由就到哪个 server 中去。

upstream backserver {

server 192.168.1.10 weight=3;

server 192.168.1.11 weight=7;

}

每个请求按访问 IP 的hash结果分配,每个访客固定访问一个后端服务器,可解决session的问题。

upstream backserver {

ip_hash;

server 192.168.1.10:80;

server 192.168.1.11:88;

}

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

upstream backserver {

server server1;

server server2;

fair;

}

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。

upstream backserver {

server squid1:3128;

server squid2:3128;

hash $request_uri;

hash_method crc32;

}

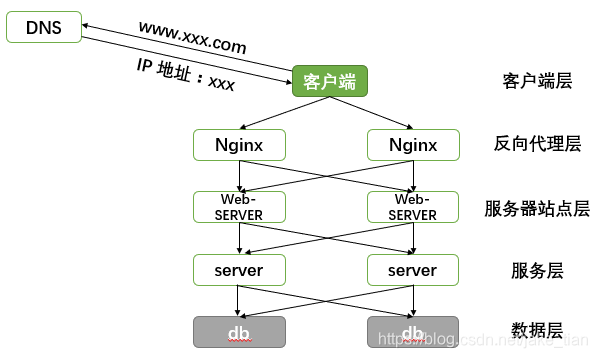

将下图进行拆分,其常见互联网分布式架构,主要分为:

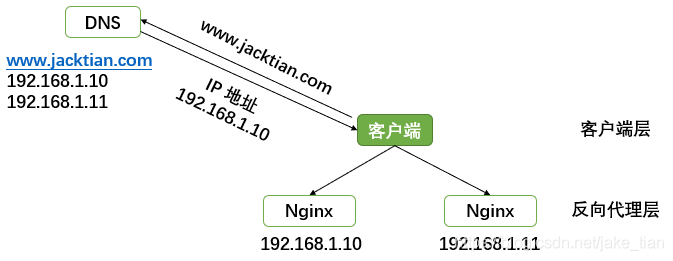

客户端层到反向代理层的负载均衡,通过DNS轮询实现,在DNS服务器上对应的域名配置多个IP,当客户端发出的请求到DNS服务器时,会轮询返回对应域名配置的 IP,保证解析的IP是必须与Nginx服务器的IP是相同的,以此Nginx服务器的请求分配也将是均衡的。

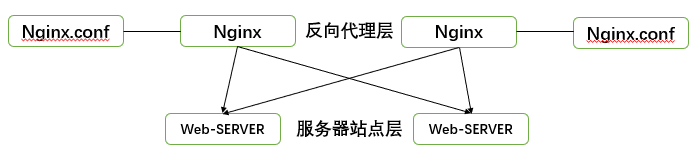

反向代理层到服务器站点层的负载均衡,通过Nginx实现,修改nginx.conf配置文件,实现多种负载均衡策略;

PS:这里我们通过

nginx.conf配置文件的方式进行实现,其主要实现的方式可参考上述:三、Nginx负载均衡的几种方式(主要包括:轮询、weight、ip_hash、fair(第三方)、url_hash(第三方)的相关描述)

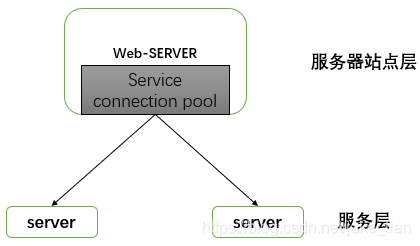

服务器站点层到服务层的负载均衡,是通过服务连接池实现的,上游连接池会建立与下游服务多个连接,每次请求将会随机选取连接来访问下游服务。

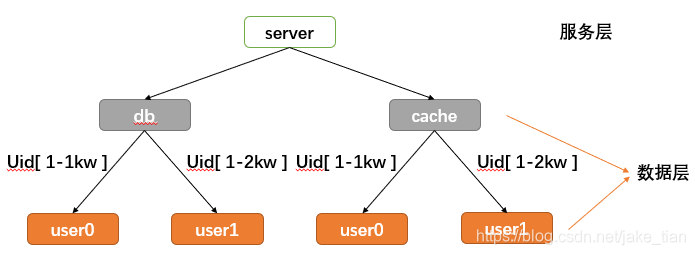

服务层到数据层时,数据量很大的情况下,数据层(db,cache)会涉及数据的水平切分,所以数据层的负载均衡会更加复杂一些,分为数据的均衡与请求的均衡。

数据的均衡:是指水平切分后的每个服务(db,cache),数据量是均匀的。

请求的均衡:是指水平切分后的每个服务(db,cache),请求量是均匀的。

常见的水平切分方式有两种:

第一种:按照range水平切分

每一个数据服务,存储一定范围的数据

user0 服务,存储 uid 范围:1-1kw;user1 服务,存储 uid 范围:1kw-2kw;这个方案的好处是:

规则简单,service 只需判断一下 uid 范围就能路由到对应的存储服务;数据均衡性较好;易扩展,可随时加一个 uid [2kw,3kw] 的数据服务;这个方案的不足是:

请求的负载不一定均衡,对新用户会比老用户更活跃,大 range 的服务请求压力会更大。

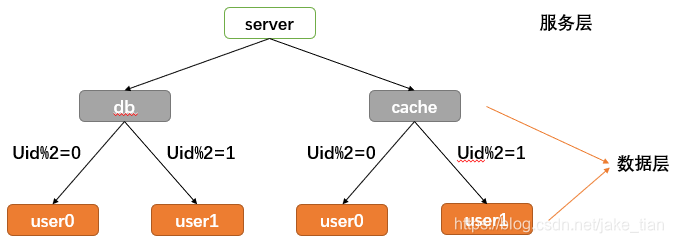

第二种:按照 id 哈希水平切分

每一个数据服务,存储某个 key 值 hash 后的部分数据

user0 服务,存储偶数 uid 数据;user1 服务,存储奇数 uid 数据;这个方案的好处是:

规则简单,service 需对 uid 进行 hash 能路由到对应的存储服务;数据均衡性较好;请求均匀性较好;这个方案的不足是:

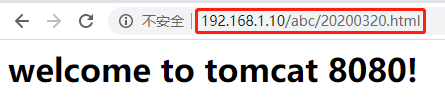

在浏览器地址栏中输入http://192.168.1.10/abc/20200320.html,负载均衡效果平均到端口号8080和8081中。

1) 准备两台Tomcat服务器,一台服务器为8080,另一台服务器为8081。

2) 分别在两台Tomcat服务器中的webapps目录中,创建名称是abc文件夹,在abc文件夹中创建页面20200325.html,进行测试。

在上一篇文章中,我们对其两台Tomcat服务创建好了8080和8081,所以这里我们就无需在创建了,并且分别查看8080和8081服务下webapps目录中是否都存在测试页面文件,如没有可自行创建即可。

Tomcat8080

# cat /root/tomcat8080/apache-tomcat-7.0.70/webapps/abc/20200320.html

<h1>welcome to tomcat 8080!</h1>

Tomcat8081

# cd /root/tomcat8081/apache-tomcat-7.0.70/webapps/

# mkdir abc

# cd abc/

# vim 20200320.html

<h1>welcome to tomcat 8081!</h1>

切换到/root/tomcat8081/apache-tomcat-7.0.70/bin/目录下,启动8081的Tomcat服务。

# ./startup.sh

Using CATALINA_BASE: /root/tomcat8081/apache-tomcat-7.0.70

Using CATALINA_HOME: /root/tomcat8081/apache-tomcat-7.0.70

Using CATALINA_TMPDIR: /root/tomcat8081/apache-tomcat-7.0.70/temp

Using JRE_HOME: /usr

Using CLASSPATH: /root/tomcat8081/apache-tomcat-7.0.70/bin/bootstrap.jar:/root/tomcat8081/apache-tomcat-7.0.70/bin/tomcat-juli.jar

Tomcat started.

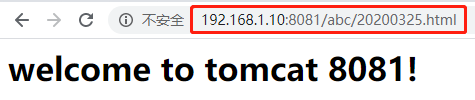

测试验证

在客户端浏览器中分别测试Tomcat8080:http://192.168.1.10/abc/20200320.html和Tomcat8081:http://192.168.1.10:8081/abc/20200325.html进行验证。

3) 在 Nginx 的配置文件中进行负载均衡的配置;

在http模块下添加upstream myserver配置、server_name 由原来的localhost改为Nginx服务器地址,在location下添加proxy_pass http://myserver;即可;

# vim /usr/local/nginx/conf/nginx.conf

17 http {

18 ......

34 upstream myserver {

35 server 192.168.1.10:8080;

36 server 192.168.1.10:8081;

37 }

38

39 server {

40 listen 80;

41 server_name 192.168.1.10;

42

43 #charset koi8-r;

44

45 #access_log logs/host.access.log main;

46

47 location / {

48 proxy_pass http://myserver;

49 root html;

50 index index.html index.htm;

51 }

52 ......

操作完 Nginx 文件的负载均衡的配置后,重启Nginx服务,出现如下问题:

# ./nginx -s stop

nginx: [warn] conflicting server name "192.168.1.10" on 0.0.0.0:80, ignored

# ./nginx

意思是重复绑定了server name,该警告不会影响到服务器运行。而且,这个重复绑定的意思是现在运行的Nginx服务和将要加载的新配置中的重复,所以,这个警告其实是不必的。

测试验证

在客户端浏览器中输入:http://192.168.1.10/abc/20200320.html,不断刷新,观察变化,这就是在将客户端发出的请求分担到不同的Tomcat服务中去,也就是所谓负载均衡的一个效果。

通过本篇文章介绍了什么的负载均衡、Nginx负载均衡的作用、Nginx负载均衡的几种策略方式、常见的负载均衡方案、Nginx负载均衡配置实例等;负载均衡是分布式系统架构设计中必须考虑的因素之一,通常是指:将请求/数据均匀分摊到多个操作单元上执行,其的关键在于均匀:

反向代理层的负载均衡,是通过DNS轮询实现;

服务器站点层的负载均衡,是通过Nginx实现;

服务层的负载均衡,是通过服务连接池实现;

数据层的负载均衡,要考虑数据的均衡与请求的均衡两点,其常见的方式有按照范围水平切分与hash水平切分

扫描下方二维码,添加杰哥微信,备注:地区/城市-职业方向/学校-昵称,即可加入杰哥的IT之旅读者群,群内仅供学习交流、日常互动、资源分享、经验分享等,一定要记得备注,我会尽快通过好友验证的。

1、 万字长文带你了解最常用的开源 Squid 代理服务器

2、 一款常用的 Squid 日志分析工具

3、 为什么要学习 Markdown?究竟有什么用?

4、 GitHub 标星 2.5K+!教你通过玩游戏的方式学习 VIM!

5、 GitHub 标星 8K+!一款开源替代 ls 的工具你值得拥有!

6、 Linux 环境下实战 Rsync 备份工具及配置 rsync+inotify 实时同步

7、 没有一行代码,「2020 新冠肺炎记忆」这个项目却登上了 GitHub 中文趋势榜第一!

8、 RHEL 6 下 DHCP+TFTP+FTP+PXE+Kickstart 实现无人值守安装

9、 Nginx系列教程(一)| 手把手教你在Linux环境下搭建Nginx服务

10、 Nginx系列教程(二)| 一文带你读懂Nginx的正向与反向代理

今天的推荐不知道大家喜欢吗?如果你喜欢,请在文章底部留言和点赞,以表示对我的支持,你们的留言和点赞是我持续更新的动力哦,感谢大家!

1、点个赞,让更多的人看到这篇文章,顺便激励下我,嘻嘻。

2、关注我的原创微信公众号「杰哥的IT之旅」,专注于IT技术干货文章,以及不定期的分享学习资料,实用工具,面试经验等,当然了还有内推机会哦,期待你的关注!

Nginx系列教程(三)| 一文带你读懂 Nginx 的负载均衡

标签:组成 stream 内推 架构 在服务器 mysql pps serve mys

原文地址:https://www.cnblogs.com/jacktian-it/p/12571128.html