systemctl restart ceph-mgr.target

systemctl restart ceph-mon.target mon 监控

systemctl restart ceph-osd.target osd 分布式存储,6.块存储

块存储服务(cinder)提供块存储。

存储的分配和消耗是由块存储驱动器或者多后端配置的驱动器决定的。还有很多驱动程序可用:NAS/SAN、NFS、ISCSI、CEPH等。CEPH在生产环境中用的比较多

块存储适合性能敏感性业务场景,例如数据库存储大规模可扩展的文件系统或服务器需要访问到块级的裸设备存储。

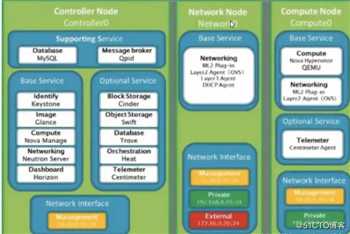

典型情况下,块服务API和调度器服务运行在控制节点上。取决于使用的驱动,卷服务器可以运行在控制节点、计算节点或单独的存储结点上。

块存储服务为openstack中的实例提供持久的存储,块存储提供一个基础设施,用于管理卷以及和openstack计算服务交互,为实现提供卷、快照、卷类型等功能。

站在实例的角度,挂载的每个卷都是一块独立的硬盘。

cinder提供了从创建卷到删除卷整个生命周期的管理。

功能:

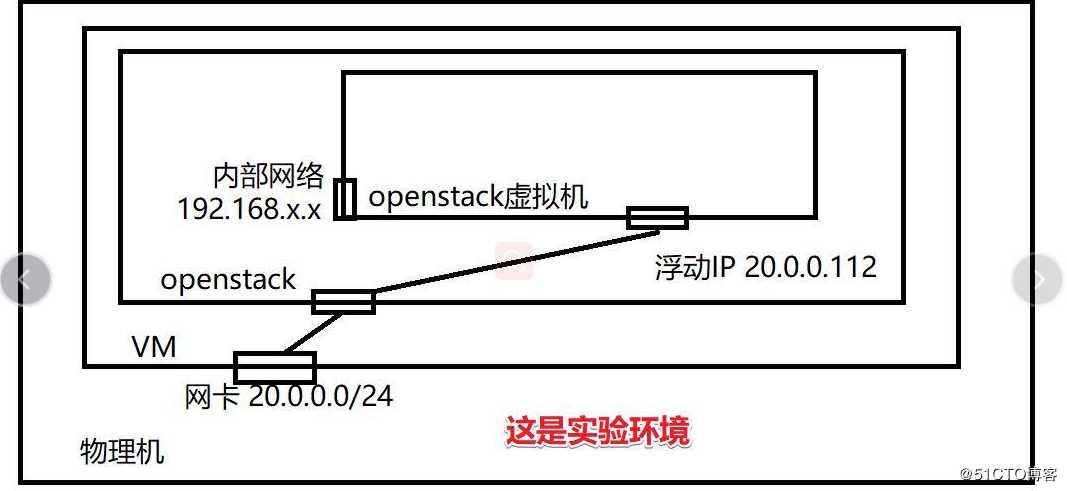

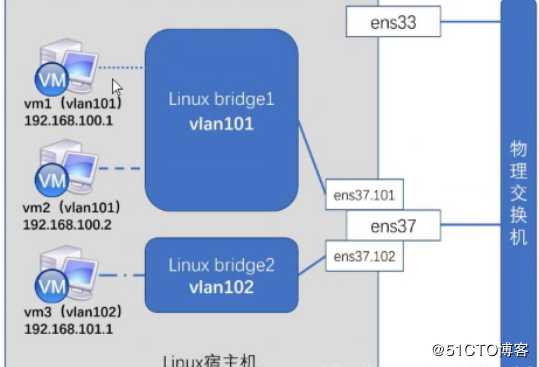

该物理网卡不能配置IP地址,所有连接到此网络的虚拟机共享一个私有IP网段。

flat组网模型适用于一下应用场景

(1)flat网络直接连接虚拟机和外部网络

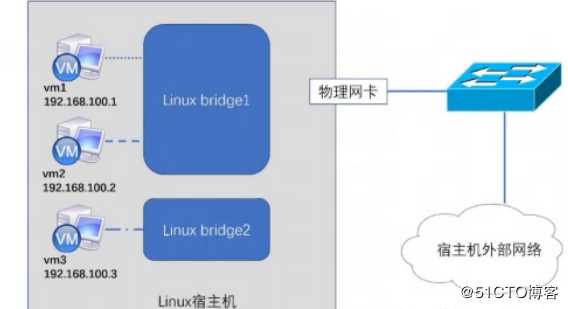

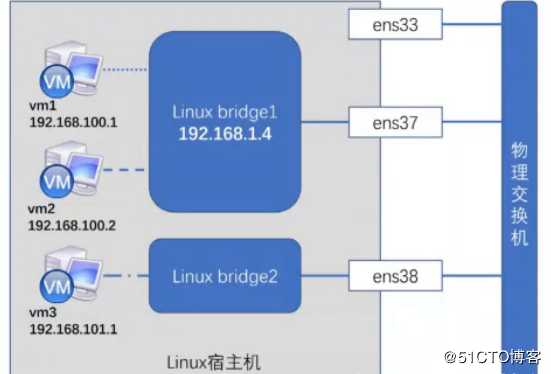

如下图所示,linux bridge 1 连接 vm 1 和 vm 2,并绑定物理网卡ens37

linux bridge 2 连接vm 3,并绑定物理网卡ens38

vm 1 和vm 2 可以直接相互通信,并通过ens37 访问外部网络,

vm 3 通过ens 38访问外部网络

(2)flat网络连接路由器和外部网络

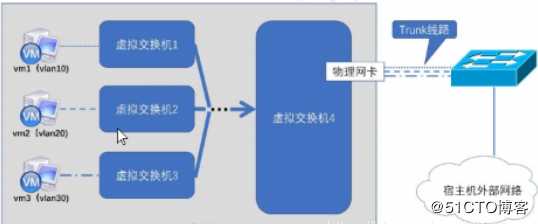

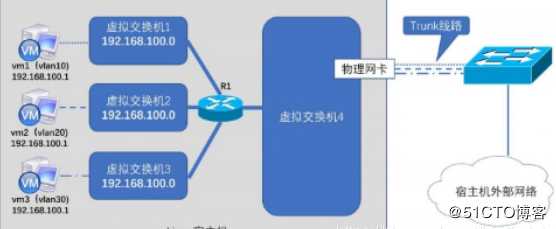

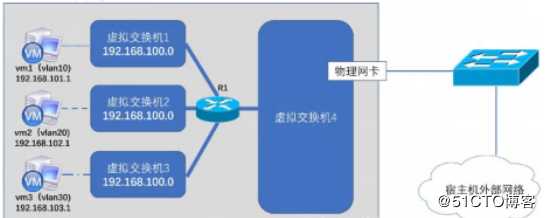

如下图所示,虚拟机链接vlan 类型的网络,并通过vlan对租户进行隔离,对外通过虚拟路由器R1链接虚拟交换机4,并通过虚拟交换机4俩捏物理网卡实现访问外部网络。

通过vlan隔离的租户被限制在虚拟交换机1-3所在的vlan网络,而虚拟机发起的流量经过路由器转发后不携带任何vlan标签到达虚拟交换机4,并通过物理网卡访问外部网络。

虚拟交换机4所在的网络就可以被设计为flat网络

flat网络存在以下缺点:

原文地址:https://blog.51cto.com/14557905/2486810