标签:输出 参数 建模 agg algorithm 网络模型 learning 独立 ack

简介:在包括违约预测在内的诸多场景中,越来越多的建模人员将模型集成的方式应用在实际工作中,并且取得了不错的成效。本节课将介绍三种基本的集成方式:Bagging,boosting,stacking。

目录:

1.元模型与集成模型

2.多模型的bagging

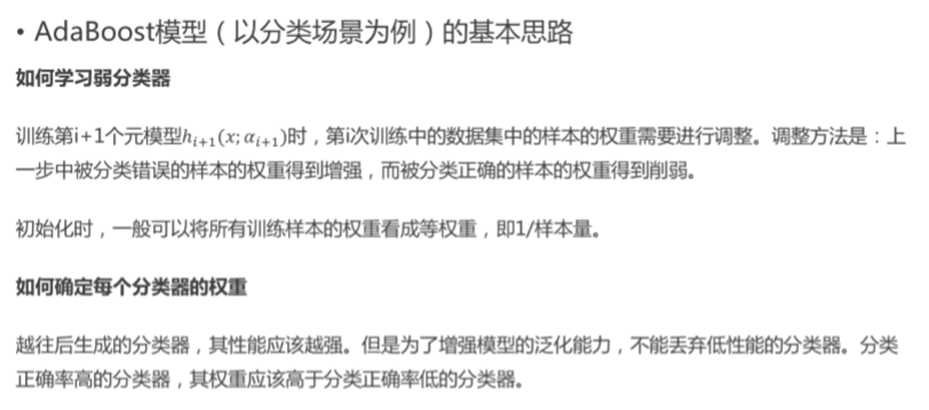

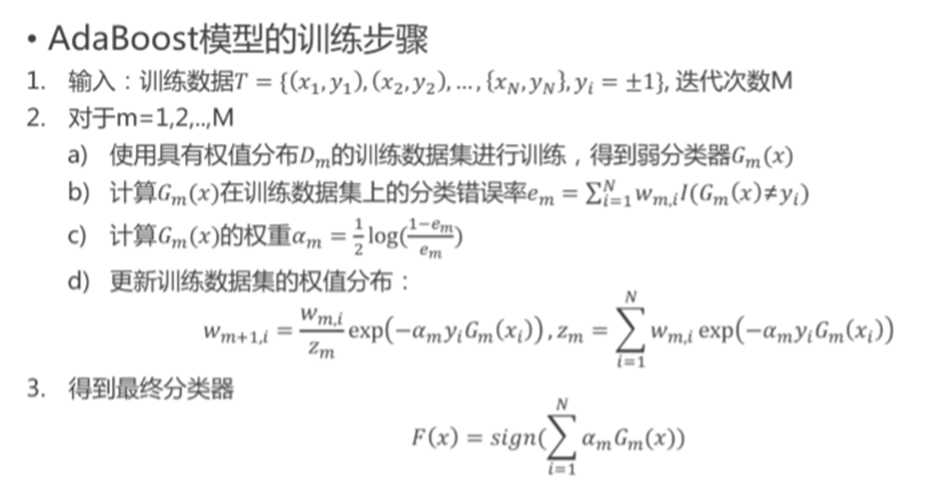

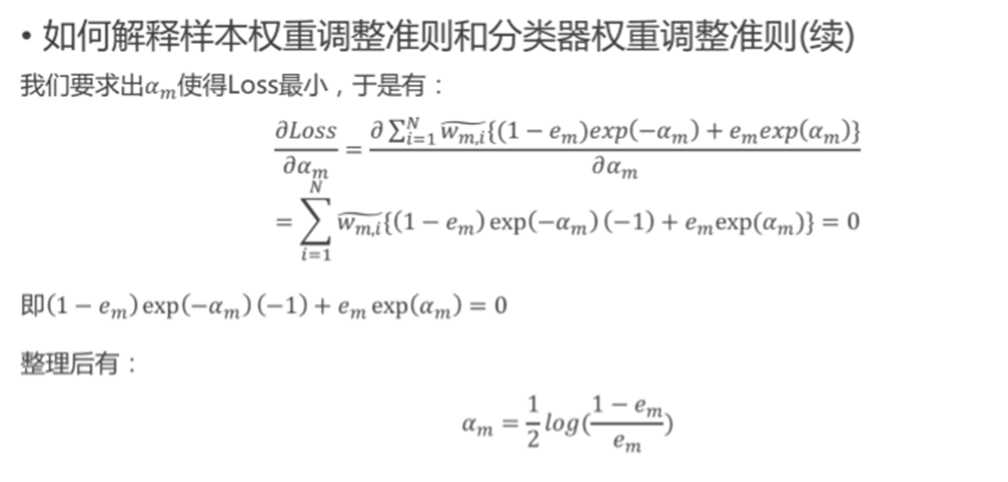

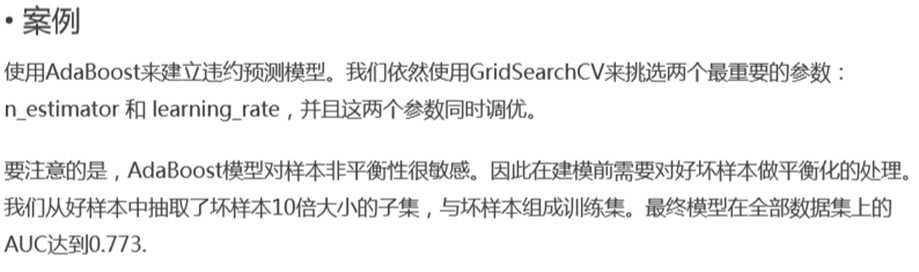

3.多模型的boosting

4.多模型的stacking

1.元模型与集成模型

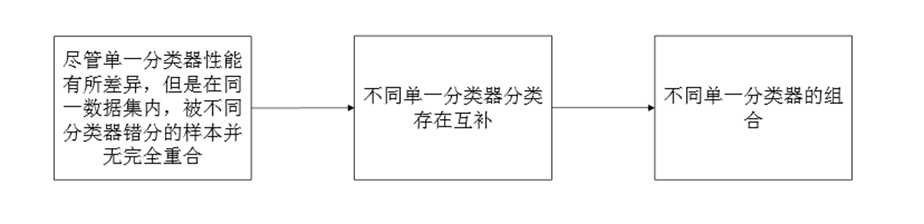

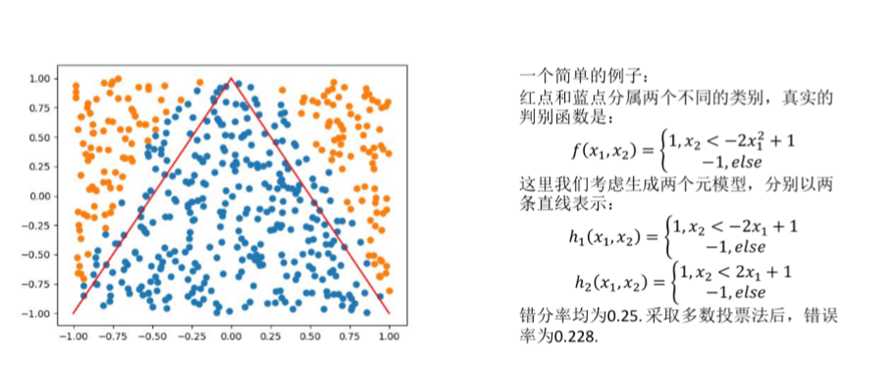

什么是集成模型:把多种单一问题组合起来共同解决一个问题

集成模型的必要性

集成模型原理:

?

单一分类器:基学习模型或称为元模型(base learner) 相应的算法:基学习算法(base learning algorithm) 组合方法:Boosting , Bagging&Stacking

? 集成模型中的元模型的选择

根据元模型之间的种类关系可以把集成模型划分为异态集成与同态集成两种。

异态集成

使用不同的分类、回归算法建立单一模型并进行集成

同态集成

使用同一算法(参数不同或者建立在不同的训练集上)建立单一模型并进行集成

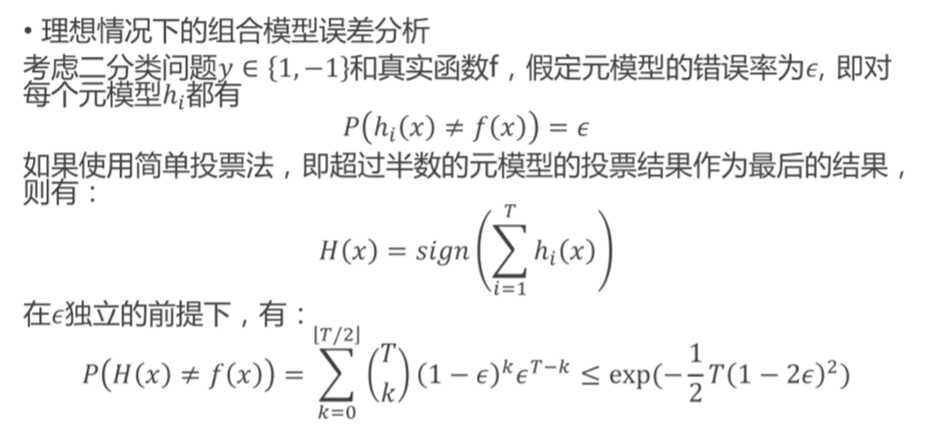

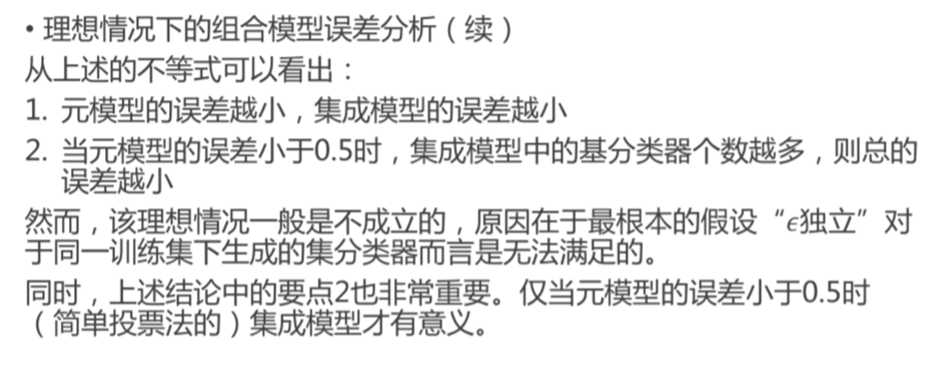

单一模型需要满足以下基本要求

? 单一模型之间的数据或者假设要求要基本相同

? 单一模型的分类错误率要低于0.5

? 单一模型之间要保证相互独立

? 单一模型的复杂度也要适度

? 单一模型的数量并非越多越好

2.多模型的bagging

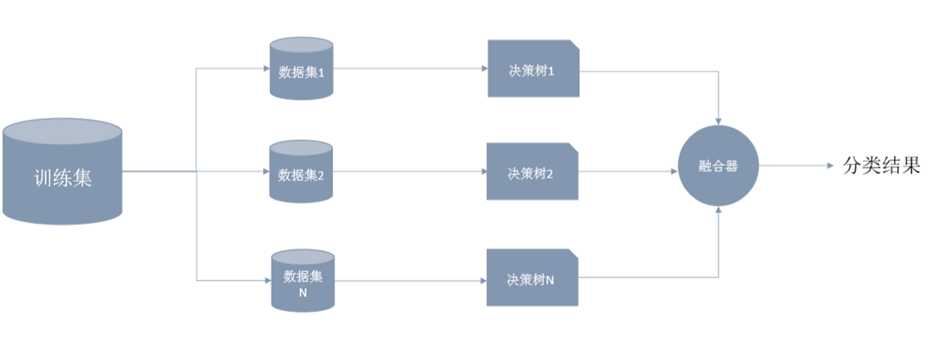

? 集成方式一:Bagging

Bagging的代表是随机森林模型。这种集成方式的步骤是

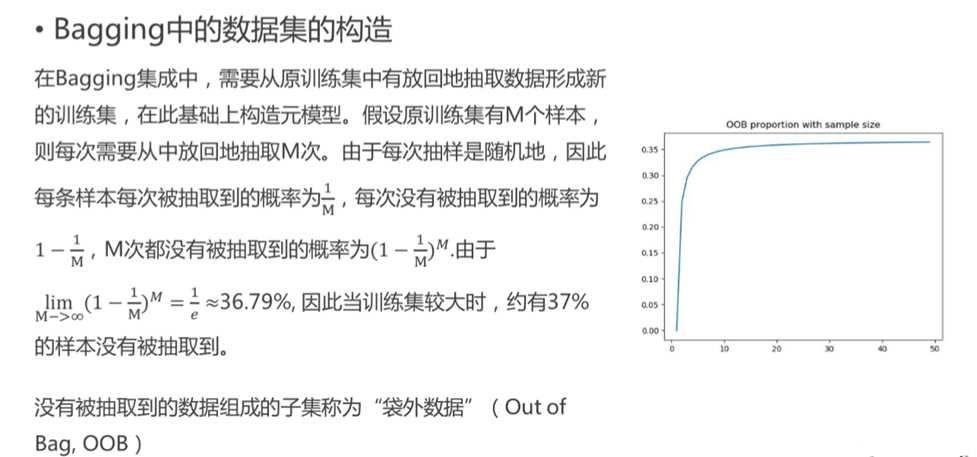

案例 我们使用三种模型来作为Bagging的元模型:逻辑回归模型、XGBoost模型和人工神经网络模型。对于每个模型,我们都从原始训练集中有放回地抽取样本形成同样大小的集合作为元模型的训练集。得到的每一个模型的结果是概率,求平均值后作为Bagging集成的输出。这是典型的异态集成。

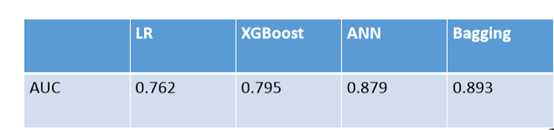

在我们的案例中,元模型的AUC以及集成模型的AUC见下表。数据预处理和特征衍生参考评分卡模型的处理方法。

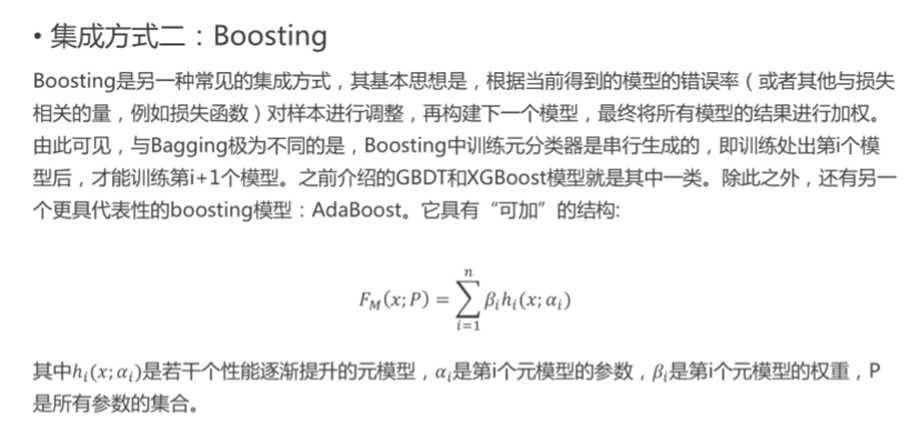

3.多模型的boosting

?

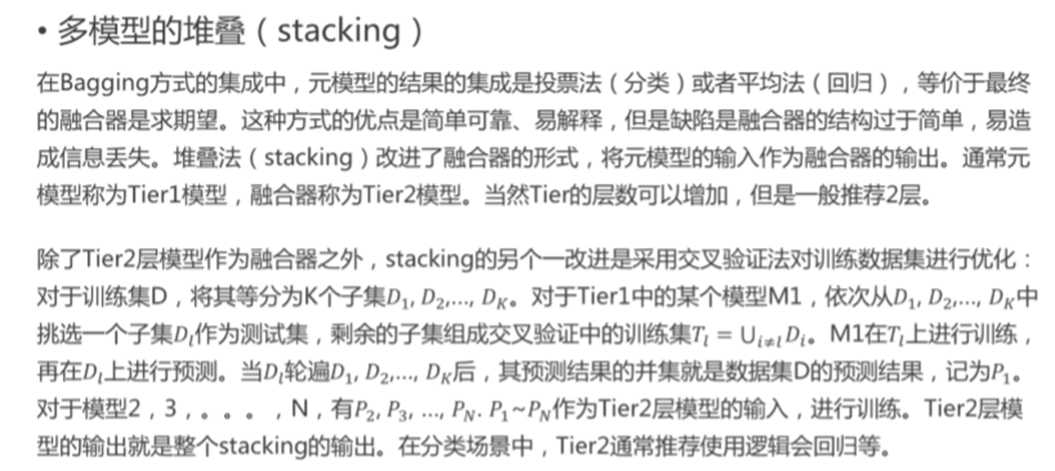

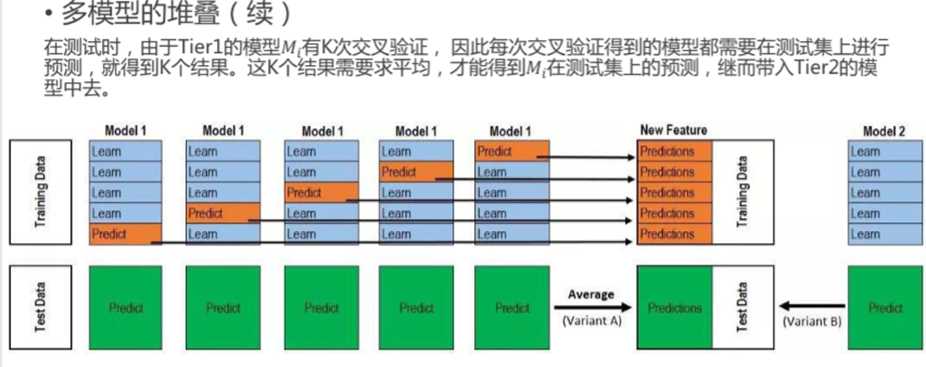

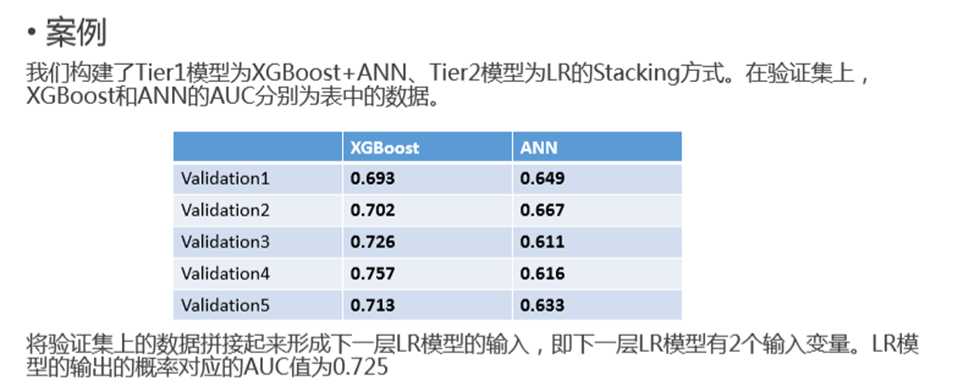

4.多模型的stacking

?

标签:输出 参数 建模 agg algorithm 网络模型 learning 独立 ack

原文地址:https://www.cnblogs.com/wuxiping2019/p/12996427.html