标签:data- master 副本 ado res jdbc src ast ima

本文源码:GitHub·点这里 || GitEE·点这里版本:kafka2.11,zookeeper3.4注意:这里zookeeper3.4也是基于集群模式部署。

tar -zxvf kafka_2.11-0.11.0.0.tgz

mv kafka_2.11-0.11.0.0 kafka2.11创建日志目录

[root@en-master kafka2.11]# mkdir logs注意:以上操作需要同步到集群下其他服务上。

vim /etc/profile

export KAFKA_HOME=/opt/kafka2.11

export PATH=$PATH:$KAFKA_HOME/bin

source /etc/profile[root@en-master /opt/kafka2.11/config]# vim server.properties

-- 核心修改如下

# 唯一编号

broker.id=0

# 开启topic删除

delete.topic.enable=true

# 日志地址

log.dirs=/opt/kafka2.11/logs

# zk集群

zookeeper.connect=zk01:2181,zk02:2181,zk03:2181注意:broker.id安装集群服务个数编排即可,集群下不能重复。

# 启动命令

[root@node02 kafka2.11]# bin/kafka-server-start.sh -daemon config/server.properties

# 停止命令

[root@node02 kafka2.11]# bin/kafka-server-stop.sh

# 进程查看

[root@node02 kafka2.11]# jps注意:这里默认启动了zookeeper集群服务,并且集群下的kafka分别启动。

创建topic

bin/kafka-topics.sh --zookeeper zk01:2181 --create --replication-factor 3 --partitions 1 --topic one-topic参数说明:

查看topic列表

bin/kafka-topics.sh --zookeeper zk01:2181 --list修改topic分区

bin/kafka-topics.sh --zookeeper zk01:2181 --alter --topic one-topic --partitions 5查看topic

bin/kafka-topics.sh --zookeeper zk01:2181 --describe --topic one-topic发送消息

bin/kafka-console-producer.sh --broker-list 192.168.72.133:9092 --topic one-topic消费消息

bin/kafka-console-consumer.sh --bootstrap-server 192.168.72.133:9092 --from-beginning --topic one-topic删除topic

bin/kafka-topics.sh --zookeeper zk01:2181 --delete --topic firstKafka集群中有一个broker会被选举为Controller,Controller依赖Zookeeper环境,管理集群broker的上下线,所有topic的分区副本分配和leader选举等工作。

Kafka中间件的Producer拦截器主要用于实现消息发送的自定义控制逻辑。用户可以在消息发送前以及回调逻辑执行前有机会对消息做一些自定义,比如消息修改等,发送状态监控等,用户可以指定多个拦截器按顺序执行拦截。

核心方法

注意:这里说的拦截器是针对消息发送流程。

定义方式:实现ProducerInterceptor接口即可。

拦截器一:在onSend方法中,对拦截的消息进行修改。

@Component

public class SendStartInterceptor implements ProducerInterceptor<String, String> {

private final Logger LOGGER = LoggerFactory.getLogger("SendStartInterceptor");

@Override

public void configure(Map<String, ?> configs) {

LOGGER.info("configs...");

}

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> record) {

// 修改消息内容

return new ProducerRecord<>(record.topic(), record.partition(),

record.timestamp(), record.key(),

"onSend:{" + record.value()+"}");

}

@Override

public void onAcknowledgement(RecordMetadata metadata, Exception exception) {

LOGGER.info("onAcknowledgement...");

}

@Override

public void close() {

LOGGER.info("SendStart close...");

}

}拦截器二:在onAcknowledgement方法中,判断消息是否发送成功。

@Component

public class SendOverInterceptor implements ProducerInterceptor<String, String> {

private final Logger LOGGER = LoggerFactory.getLogger("SendOverInterceptor");

@Override

public void configure(Map<String, ?> configs) {

LOGGER.info("configs...");

}

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> record) {

LOGGER.info("record...{}", record.value());

return record ;

}

@Override

public void onAcknowledgement(RecordMetadata metadata, Exception exception) {

if (exception != null){

LOGGER.info("Send Fail...exe-msg",exception.getMessage());

}

LOGGER.info("Send success...");

}

@Override

public void close() {

LOGGER.info("SendOver close...");

}

}加载拦截器:基于一个KafkaProducer配置Bean,加入拦截器。

@Configuration

public class KafkaConfig {

@Bean

public Producer producer (){

Properties props = new Properties();

// 省略其他配置...

// 添加拦截器

List<String> interceptors = new ArrayList<>();

interceptors.add("com.kafka.cluster.interceptor.SendStartInterceptor");

interceptors.add("com.kafka.cluster.interceptor.SendOverInterceptor");

props.put(ProducerConfig.INTERCEPTOR_CLASSES_CONFIG, interceptors);

return new KafkaProducer<>(props) ;

}

}@RestController

public class SendMsgWeb {

@Resource

private KafkaProducer<String,String> producer ;

@GetMapping("/sendMsg")

public String sendMsg (){

producer.send(new ProducerRecord<>("one-topic", "msgKey", "msgValue"));

return "success" ;

}

}基于上述自定义Bean类型,进行消息发送,关注拦截器中打印日志信息。

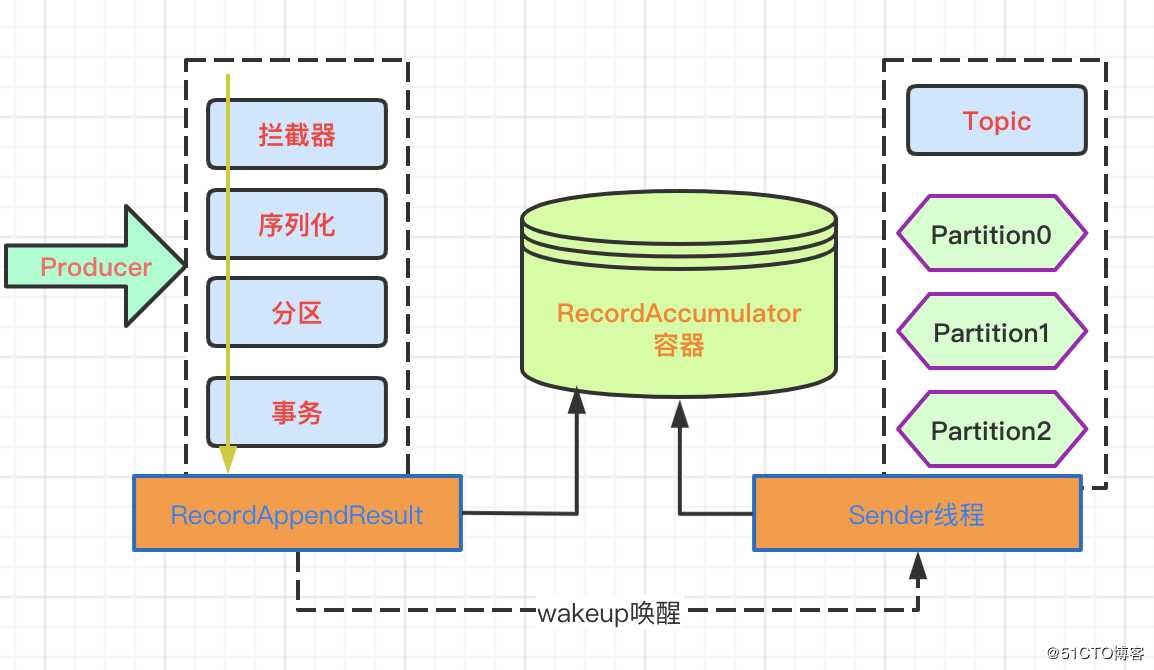

说明:该过程基于上述案例producer.send方法追踪的源码执行流程,源码中的过程相对清楚,涉及的核心流程如下。

Producer发送消息采用的是异步发送的方式,消息发送过程如下:

絮叨一句:读这些中间件的源码,不仅能开阔思维,也会让自己意识到平时写的代码可能真的叫搬砖。

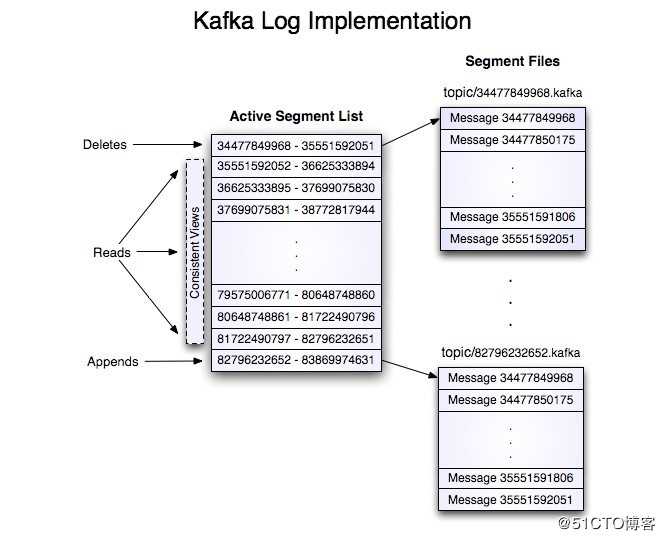

Kafka中消息是以topic进行标识分类,生产者面向topic生产消息,topic分区(partition)是物理上的存储,基于消息日志文件的方式。

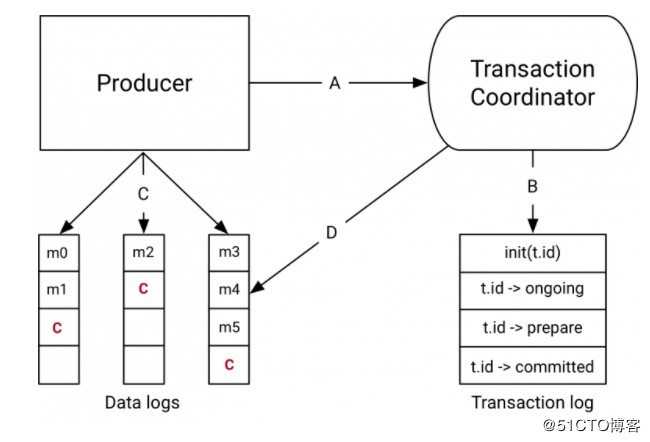

Kafka支持消息的事务控制

Producer事务

跨分区跨会话的事务原理,引入全局唯一的TransactionID,并将Producer获得的PID和TransactionID绑定。Producer重启后可以通过正在进行的TransactionID获得原来的PID。

Kafka基于TransactionCoordinator组件管理Transaction,Producer通过和TransactionCoordinator交互获得TransactionID对应的任务状态。TransactionCoordinator将事务状态写入Kafka的内部Topic,即使整个服务重启,进行中的事务状态可以得到恢复。

Consumer事务

Consumer消息消费,事务的保证强度很低,无法保证消息被精确消费,因为同一事务的消息可能会出现重启后已经被删除的情况。

GitHub·地址

https://github.com/cicadasmile/data-manage-parent

GitEE·地址

https://gitee.com/cicadasmile/data-manage-parent

推荐关联阅读:数据源管理系列

标签:data- master 副本 ado res jdbc src ast ima

原文地址:https://blog.51cto.com/14439672/2503491