标签:alpha 必须 details 简单的 sns 输入 最大 空间 相互

通常神经网络的问题:

具有以下特点:

假设有ESN是一个可调谐的sin波生成器:

典型RNN存在的问题:

为什么需要循环神经网络:

为什么使用ESN:

统计信号处理的典型方法是建立在三个基本假设:线性、稳定和高斯分布。为了便于数学计算而引入的假设。

大多数的实际物理信号是由动态过程产生,这些过程是非线性的、非稳定的和非高斯的

ESNs和一般RNNs在非线性领域推广了简单的自适应线性滤波器,可用于任何非线性动力系统的建模

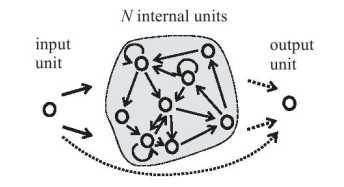

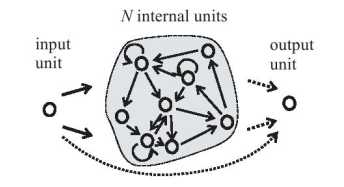

输入到水库是全连接,水库到输出是全连接,水库内部不是全连接

ESN描述:

非线性系统描述:

\(x(n+1)=f(Wx(n)+w^{in}u(n+1)+v(n+1))\)

\(y(n+1)=f^{out}(w^{out}(u(n+1),x(n+1)))\)

(内部状态\(x(n)\)指的是什么?)

在确定条件下网络状态逐渐独立于初始状态,并只依赖于输入历史,体现网络的记忆能力:

\(W\)有谱半径\(|\lambda_{max}|>1\),谱半径是矩阵的最大特征值,此时就会丢失回声特性,需要对其做归一化处理,\(W_{new}=W/|\lambda_{max}|\)

\(W\)最好是稀疏矩阵

通常\(W\)是由\([-1,1]\)的均匀分布随机生成,然后使用\(|\lambda_{max}|\)做归一化处理使谱半径\(\alpha\)小于1,\(\alpha\)是ESN成功的重要参数,小的\(\alpha\)对应快的信号,大的\(\alpha\)对应慢信号和更长的短时记忆。

在训练时我们计算输出权值,误差描述为:

\(e_{train}(n) = (f^{out})^{-1}y_{teach}(n)-w^{out}(u_{teach}(n),x(n))\)

离线训练算法过程:

由此,就得到了输出权值

ESN将非线性问题转换为线性回归问题,只需要训练输出系数\(w^{out}\)。

4个决定性能的参数:

参考资料:

[1] ESN介绍

标签:alpha 必须 details 简单的 sns 输入 最大 空间 相互

原文地址:https://www.cnblogs.com/oneflyleader/p/13284142.html