标签:squeeze png object 一个 kernel transform 级别 beyond pdf

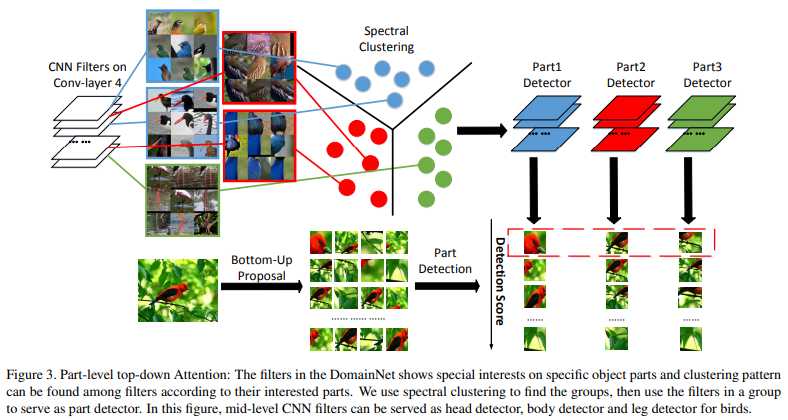

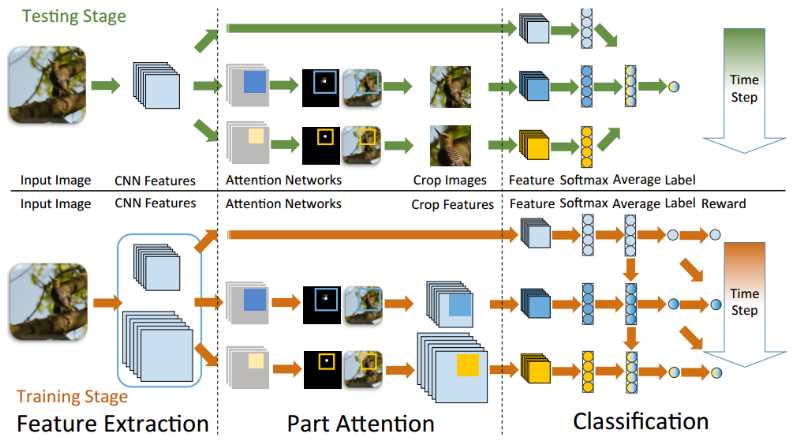

1、The Application of Two-level Attention Models in Deep Convolutional Neural Network for Fine-grained Image Classification

地址:https://arxiv.org/pdf/1411.6447.pdf

object-level和part-level两个级别分别对图像进行分类,将得到的分数相加综合后得到最后的分类结果。

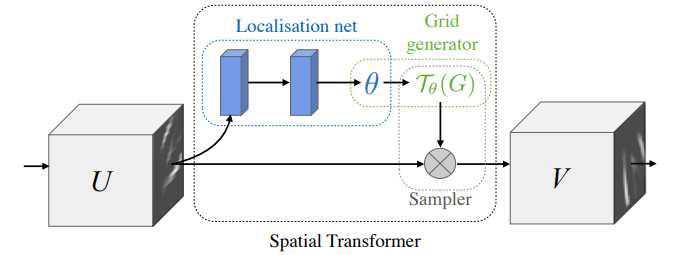

2、Spatial Transformer Networks

通过注意力机制,将原始图片中的空间信息变换到另一个空间中并保留了关键信息。

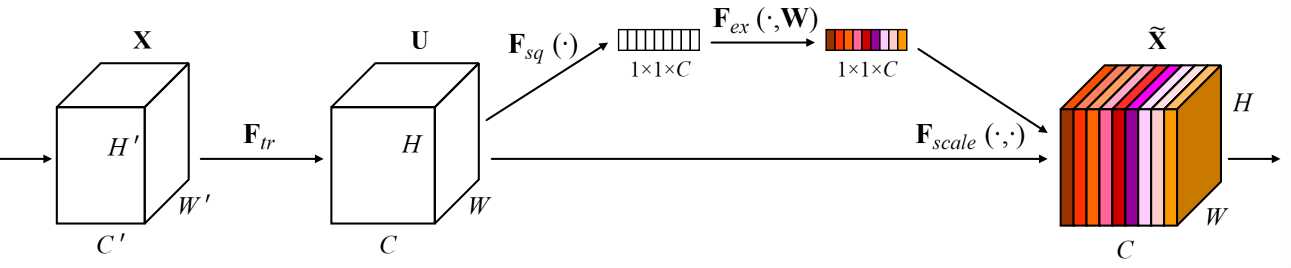

3、 Squeeze-and-Excitation Networks

通道注意力机制。

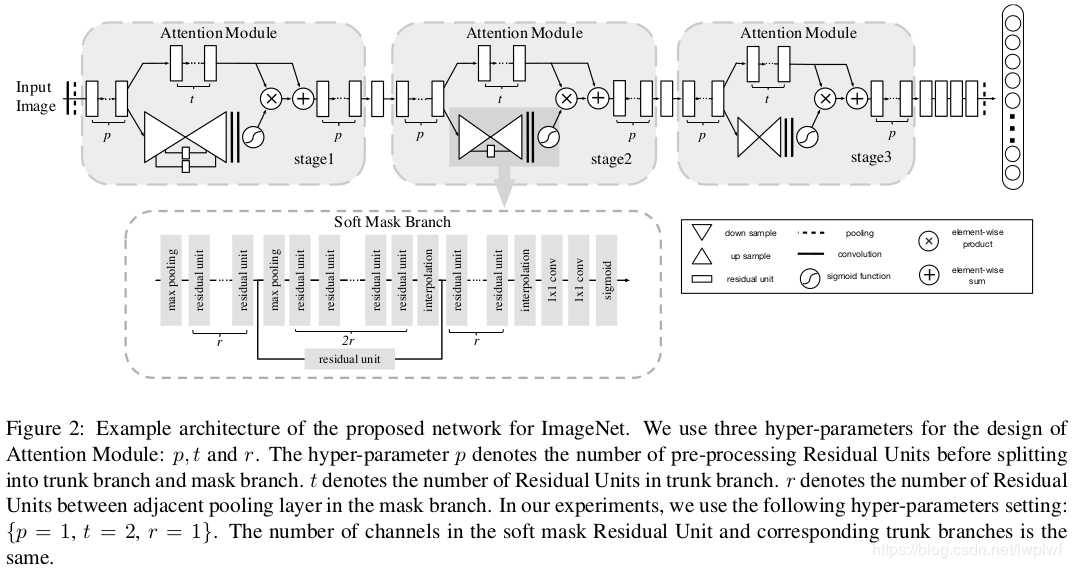

4、Residual Attention Network for Image Classification

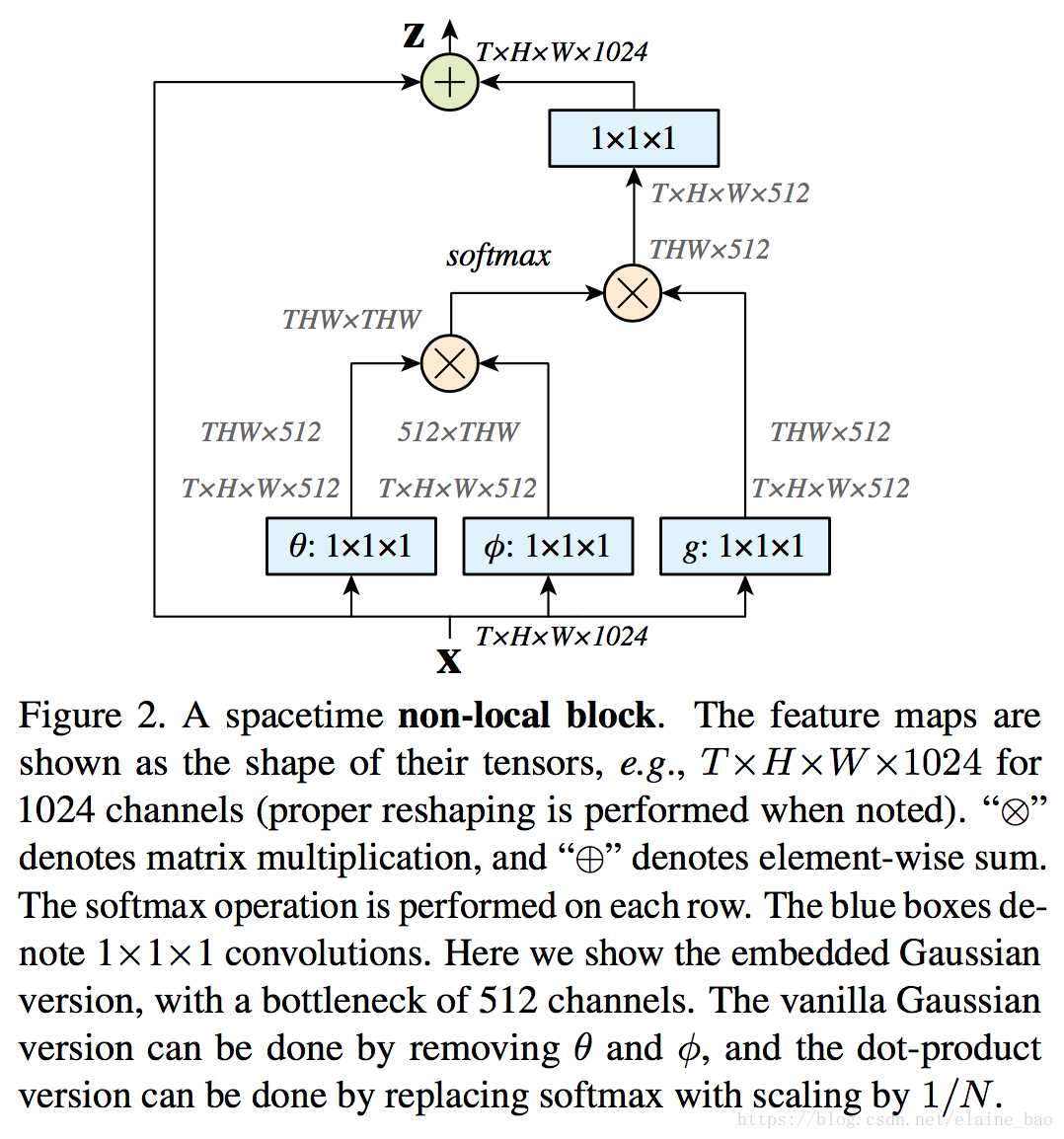

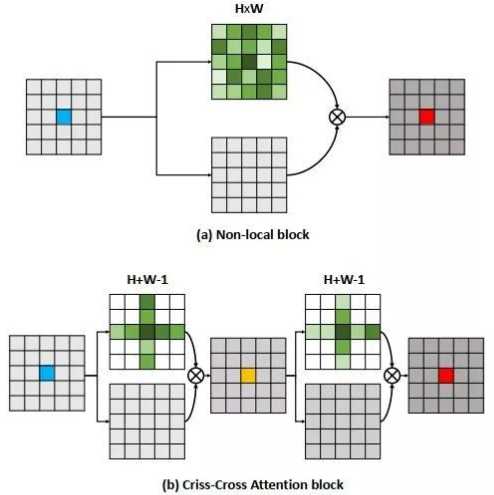

5、non-locla neural networks

CNN中的 convolution单元每次只关注邻域 kernel size 的区域,就算后期感受野越来越大,终究还是局部区域的运算,这样就忽略了全局其他片区(比如很远的像素)对当前区域的贡献。

6、interaction-ware attention

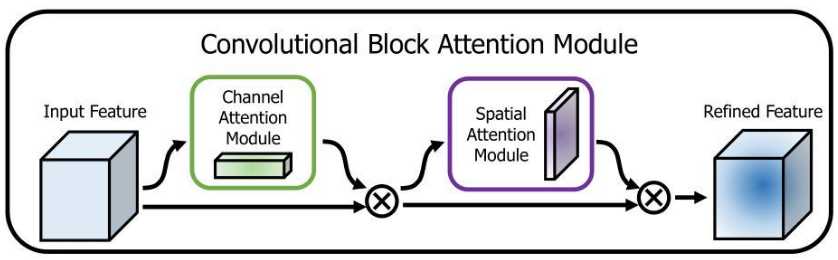

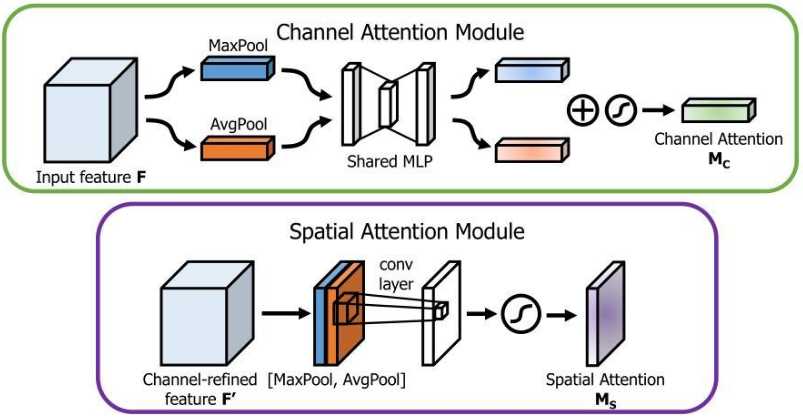

7、CBAM: Convolutional Block Attention Module

空间注意力和通道注意力混合。

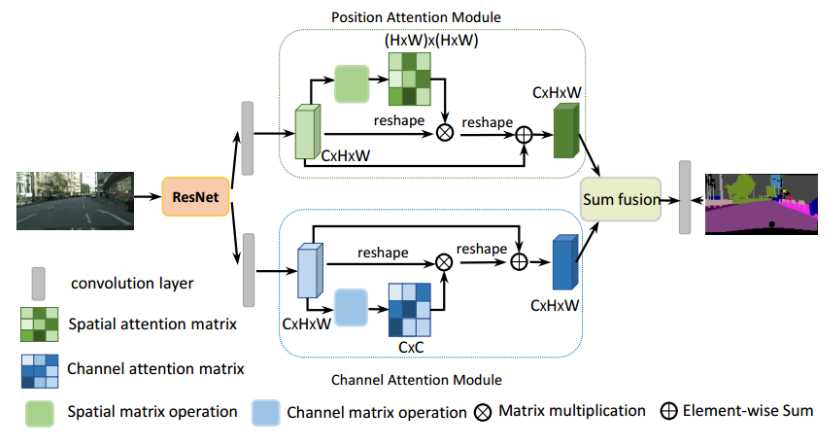

8、DANet:Dual Attention Network for Scene Segmentation

9、Criss-Cross Attention for Semantic Segmentation

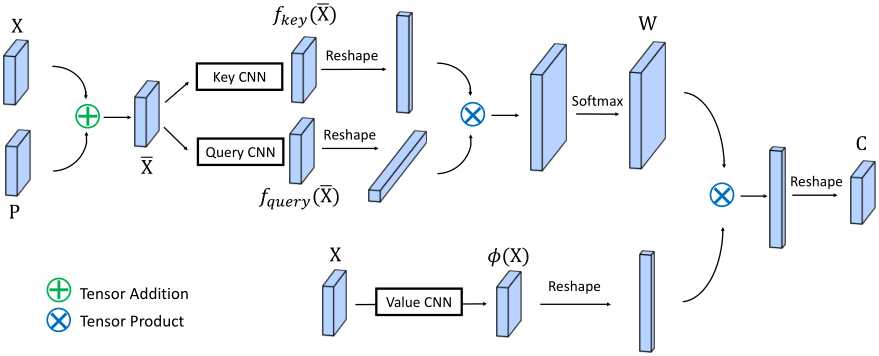

10、OCNet: Object Context Network for Scene Parsing

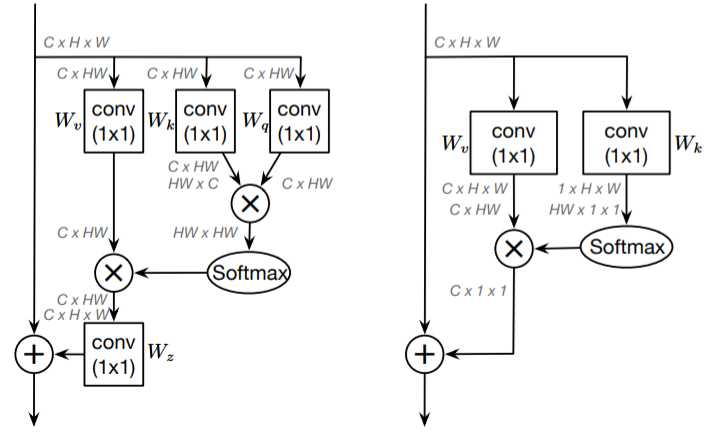

11、GCNet:Non-local Networks Meet Squeeze-Excitation Networks and Beyond

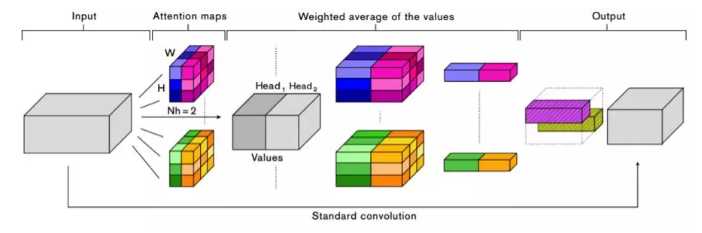

12、attention augmented convolutional networks

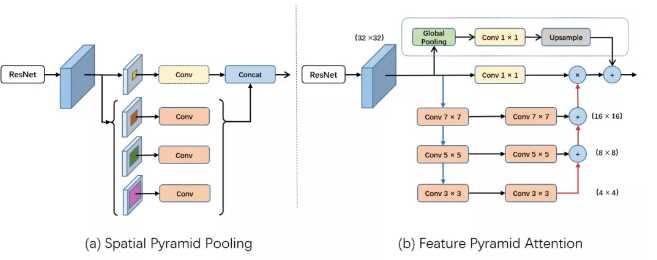

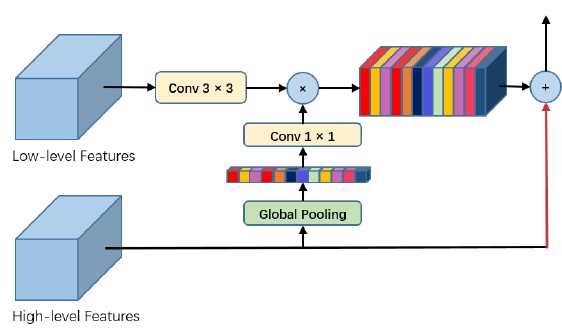

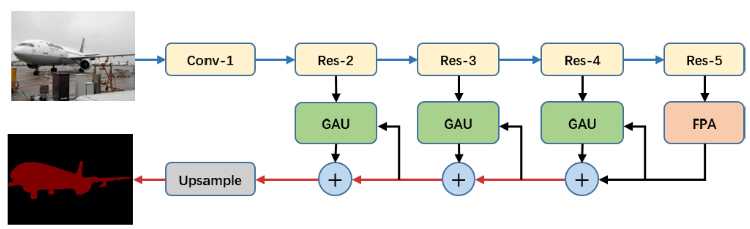

13、PAN: Pyramid Attention Network for Semantic Segmentation

14、 Fully Convolutional Attention Networks for Fine-Grained Recognition

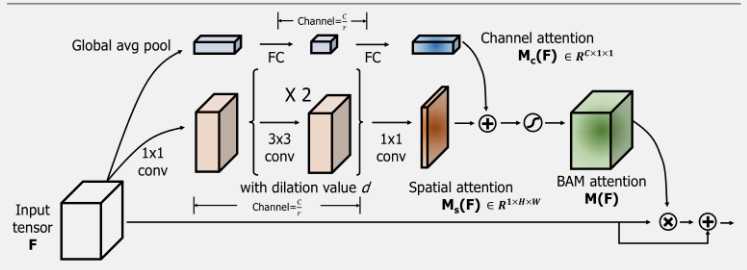

15、BAM: Bottleneck Attention Module

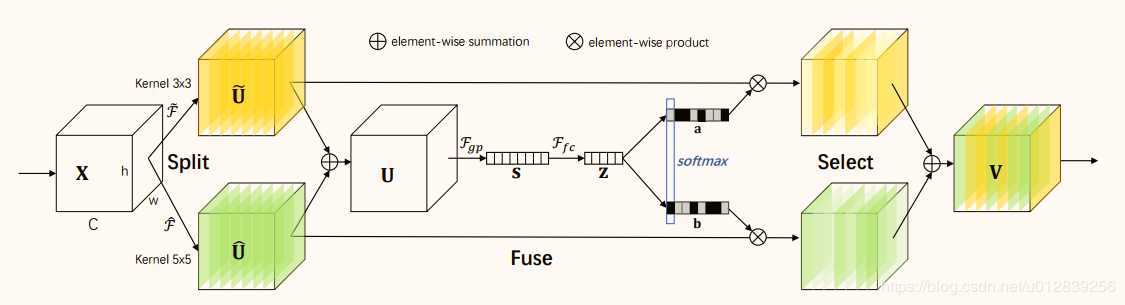

16、selective kernel networks

标签:squeeze png object 一个 kernel transform 级别 beyond pdf

原文地址:https://www.cnblogs.com/xiximayou/p/13308381.html