标签:访问速度 ca证书 查询 mic src 监听 code perm bre

1. 前言我们真实的服务器不应该直接暴露到公网上去,否则更加容易泄露服务器的信息,也更加容易受到***。一个比较“平民化”的方案是使用Nginx反向代理它。使用Nginx反向代理的一些能力能帮助我们实现很多非常有效的API控制功能。

Nginx已经不用太多的赞美了,它已经得到了业界的广泛认可。我们就聊聊它具体能够实现什么功能。

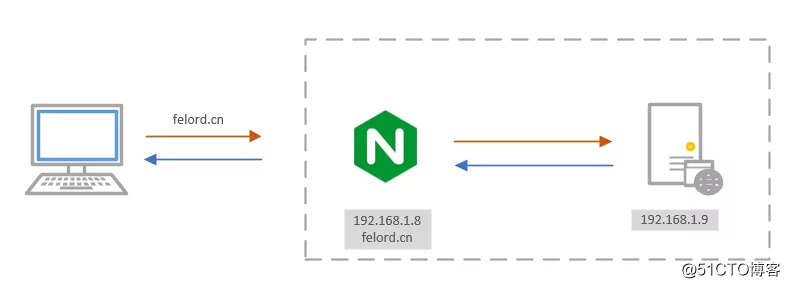

这是针对服务器端我们最常用的功能,一台具有公网的Nginx服务器可以代理和它能进行内网通信的真实的服务器。让我们的服务器不直接对外暴露,增加其抗风险能力。

Nginx反向代理web应用

Nginx反向代理web应用

假如Nginx服务器192.168.1.8可以和同一内网网段的192.168.1.9的应用服务器进行通信,同时Nginx服务器具有公网能力,我们将公网绑定到域名felord.cn上。那么我们Nginx代理的对应的配置(nginx.conf)是这样的:

server {

listen 80;

server_name felord.cn;

# ^~ 表示uri以某个常规字符串开头,如果匹配到,则不继续往下匹配。不是正则匹配

location ^~ /api/v1 {

proxy_set_header Host $host;

proxy_pass http://192.168.1.9:8080/;

}

}经过以上配置后我们服务器真实的接口地址是http://192.168.1.9:8080/foo/get就可以通过http://felord.cn/api/v1/foo/get访问。

proxy_pass如果以

/结尾,就相当于是绝对根路径,那么Nginx不会把location中匹配的路径部分代理走;如果不以/结尾,也会代理匹配的路径部分。

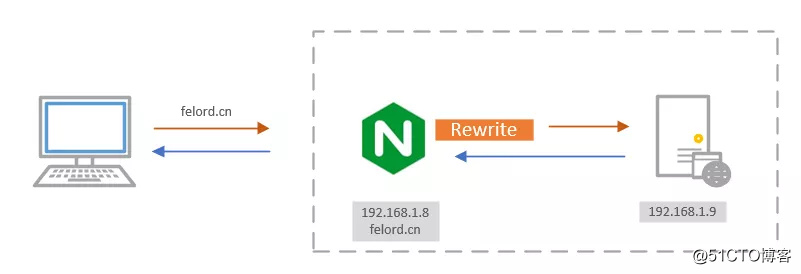

Nginx还提供了一个rewrite功能让我们在请求到达服务器时重写URI,有点类似Servlet Filter的意味,对请求进行一些预处理。

Nginx包含rewrite的流程

Nginx包含rewrite的流程

在2.1的例子中如果我们要实现如果判断请求为POST的话返回405,只需要更改配置为:

location ^~ /api/v1 {

proxy_set_header Host $host;

if ($request_method = POST){

return 405;

}

proxy_pass http://192.168.1.9:8080/;

}你可以使用Nginx提供的全局变量(如上面配置中的$request_method)或自己设置的变量作为条件,结合正则表达式和标志位(last、break、redirect、permanent)实现URI重写以及重定向。

之前很多同学在群里问如何在Spring Boot项目中配置HTTPS,我都推荐使用Nginx来做这个事情。Nginx比Spring Boot中配置SSL要方便的多,而且不影响我们本地开发。Nginx中HTTPS的相关配置根据下面的改一改就能用:

http{

#http节点中可以添加多个server节点

server{

#ssl 需要监听443端口

listen 443;

# CA证书对应的域名

server_name felord.cn;

# 开启ssl

ssl on;

# 服务器证书绝对路径

ssl_certificate /etc/ssl/cert_felord.cn.crt;

# 服务器端证书key绝对路径

ssl_certificate_key /etc/ssl/cert_felord.cn.key;

ssl_session_timeout 5m;

# 协议类型

ssl_protocols TLSv1 TLSv1.1 TLSv1.2;

# ssl算法列表

ssl_ciphers ECDHE-RSA-AES128-GCM-SHA256:HIGH:!aNULL:!MD5:!RC4:!DHE;

# 是否让服务器决定使用哪种算法 on/off TLSv1.1 的话需要开启

ssl_prefer_server_ciphers on;

location ^~ /api/v1 {

proxy_set_header Host $host;

proxy_pass http://192.168.1.9:8080/;

}

}

# 如果用户通过 http 访问 直接重写 跳转到 https 这个是一个很有必要的操作

server{

listen 80;

server_name felord.cn;

rewrite ^/(.*)$ https://felord.cn:443/$1 permanent;

}

}这里就用到了rewrite来提高用户体验,实现http自动跳转https。

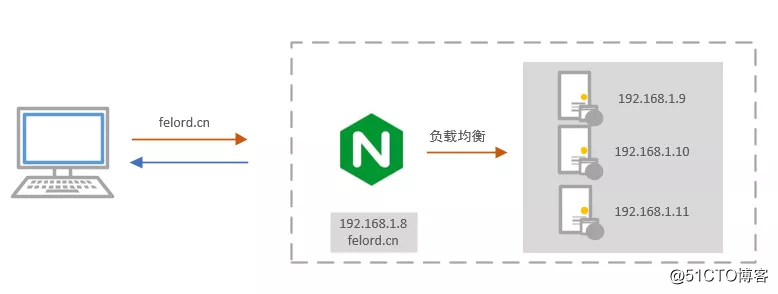

一般项目都是从小做到大起来的,起步的时候部署一个服务器就够用了,如果你的项目用户多了起来,首先恭喜你,说明你的项目方向很对。但是伴随而来还有服务器压力,你一定不想服务器宕机带来的各种损失,你需要快速提高服务器的抗压能力,或者你想不停机维护以避免业务中断,这些都可以通过Nginx的负载均衡来实现,而且非常简单。按下图felord.cn我们部署了三个节点:

Nginx 负载均衡

Nginx 负载均衡

轮番派发请求,这种配置是最简单的:

http {

upstream app {

# 节点1

server 192.168.1.9:8080;

# 节点2

server 192.168.1.10:8081;

# 节点3

server 192.168.1.11:8082;

}

server {

listen 80;

server_name felord.cn;

# ^~ 表示uri以某个常规字符串开头,如果匹配到,则不继续往下匹配。不是正则匹配

location ^~ /api/v1 {

proxy_set_header Host $host;

# 负载均衡

proxy_pass http://app/;

}

}

}指定轮询几率,weight和访问比率成正比,用于后端服务器性能不均的情况:

upstream app {

# 节点1

server 192.168.1.9:8080 weight = 6;

# 节点2

server 192.168.1.10:8081 weight = 3;

# 节点3

server 192.168.1.11:8082 weight = 1;

}最终请求处理数将为 6:3:1 进行分配。其实简单轮询可以看作所有的权重均分为 1。轮询宕机可自动剔除。

根据访问 IP 进行Hash,这样每个客户端将固定访问服务器,如果服务器宕机,需要手动剔除。

upstream app {

ip_hash;

# 节点1

server 192.168.1.9:8080 weight = 6;

# 节点2

server 192.168.1.10:8081 weight = 3;

# 节点3

server 192.168.1.11:8082 weight = 1;

}请求将转发到连接数较少的服务器上,充分利用服务器资源:

upstream app {

least_conn;

# 节点1

server 192.168.1.9:8080 weight = 6;

# 节点2

server 192.168.1.10:8081 weight = 3;

# 节点3

server 192.168.1.11:8082 weight = 1;

}我们可以借助一些插件来实现其它模式的负载均衡,例如借助于nginx-upsync-module实现动态负载均衡。我们是不是借助于此可以开发一个灰度发布功能呢?

通过对Nginx的配置,我们可以实现漏桶算法和令牌桶算法,通过限制单位时间的请求数、同一时间的连接数来限制访问速度。这一块我并没有深入研究过这里就提一提,你可以查询相关的资料研究。

Nginx非常强大,推荐使用它来代理我们的后端应用,我们可以通过配置实现很多有用的功能,而不必进行一些非业务逻辑的编码来实现,如果你在Spring Boot中实现限流、配置SSL的话,麻烦不说,还影响本地开发,使用Nginx可以让我们专心到业务中去。可以说Nginx在这里充当了一个小网关的作用,其实很多知名网关底层都是Nginx,比如Kong、Orange、Apache APISIX等,如果你有兴趣可以玩一玩Nginx的高级形态Openresty。

标签:访问速度 ca证书 查询 mic src 监听 code perm bre

原文地址:https://blog.51cto.com/14901317/2523041