标签:引入 翻译 问题 卷积神经网络 cloc loading com rate learn

基本应用: 机器翻译 股票预测 作词 模仿写论文、写代码 图像理解 视觉问答

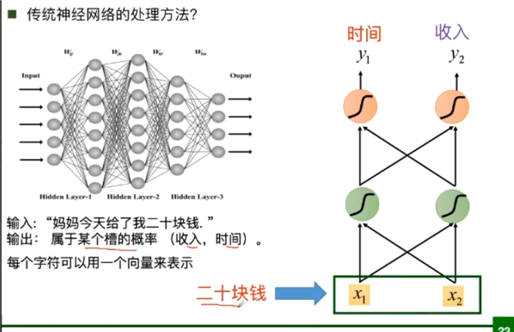

与卷积神经网络相比

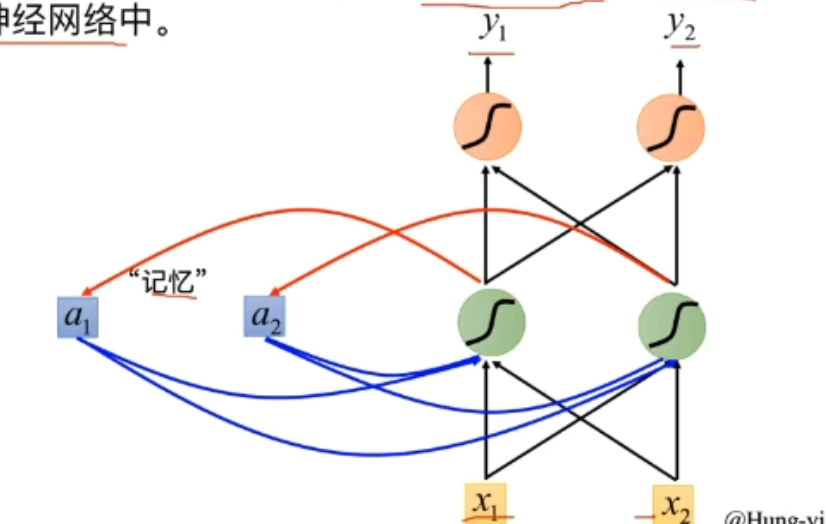

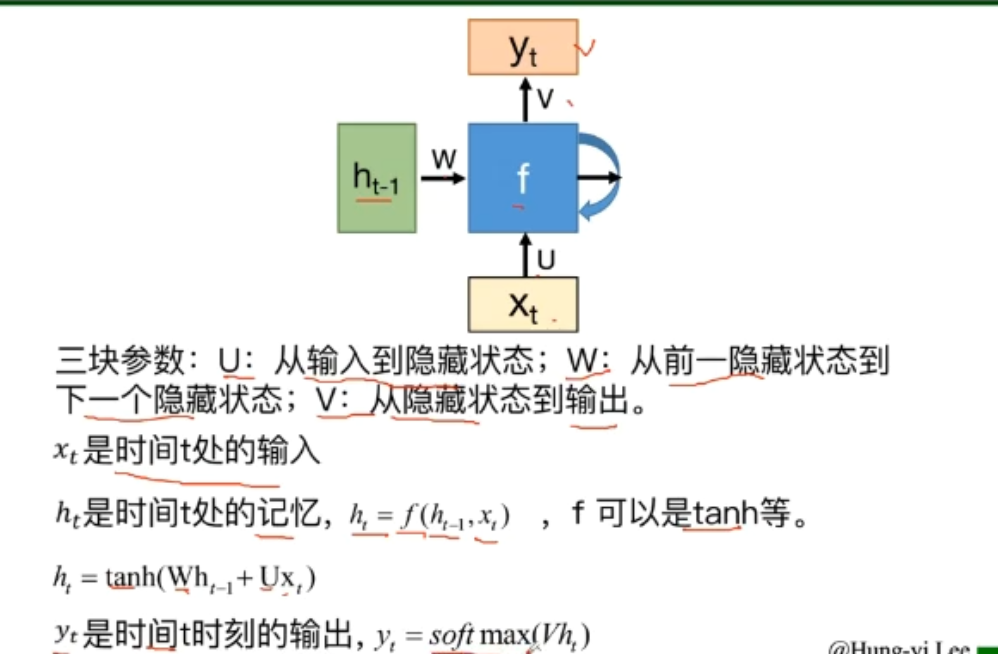

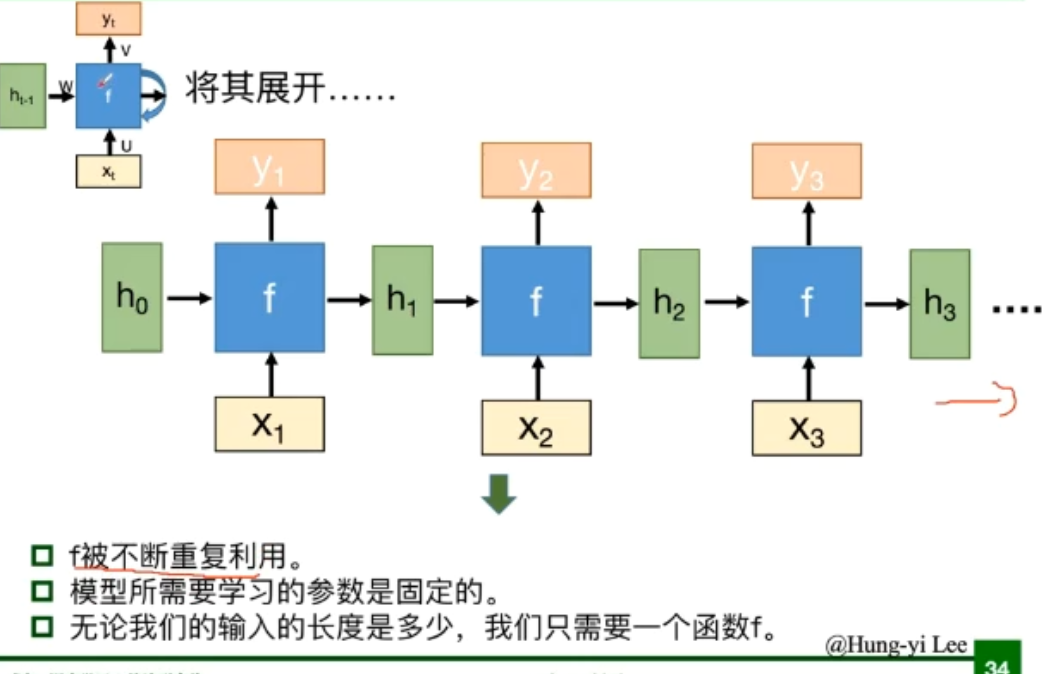

循环神经网络可以更好的处理具有时序关系的任务;

循环神经网络通过循环结构引入“记忆”的概念;

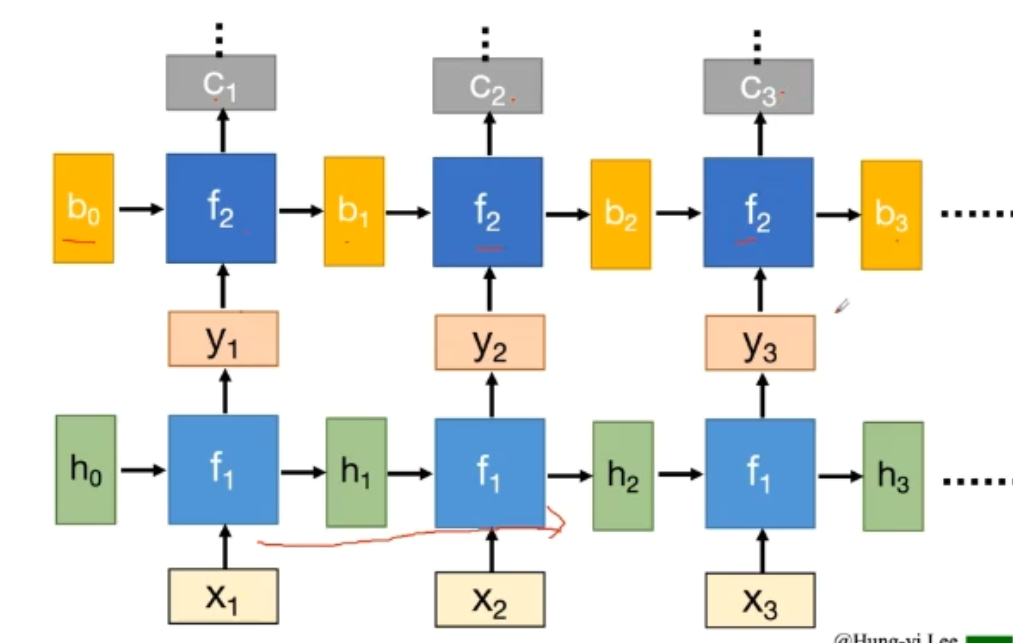

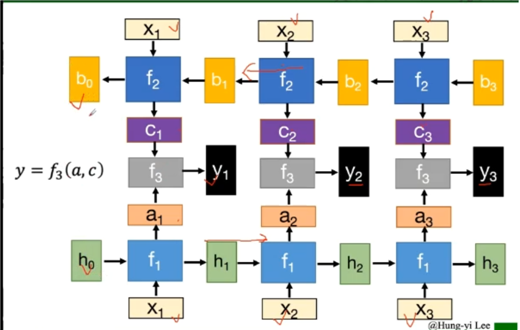

等价于下面这个形式

在深度上延伸

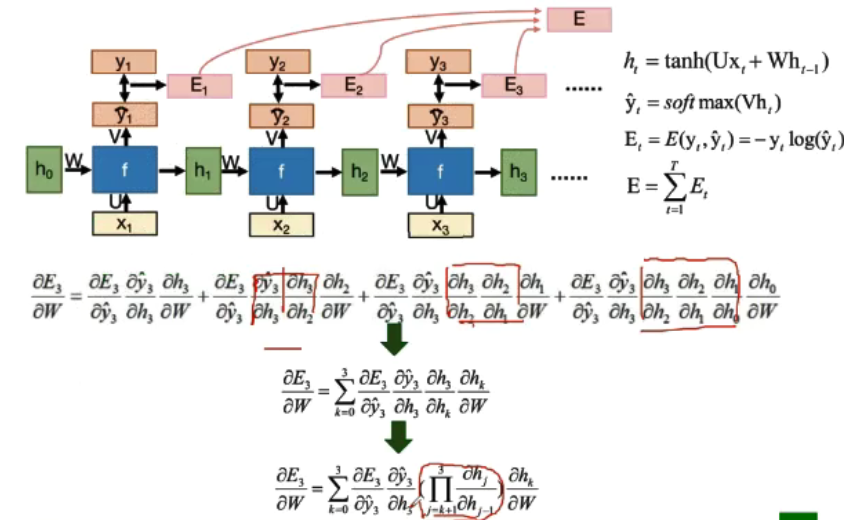

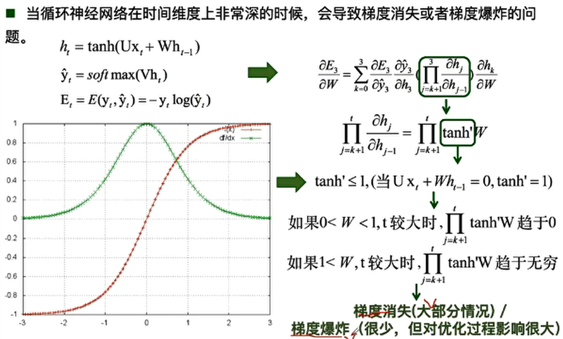

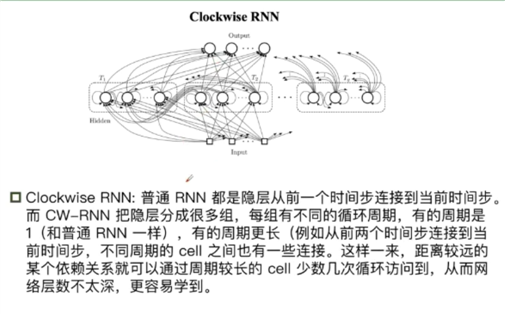

传统RNN 在时间维度上非常深的时候,会导致梯度消失或者梯度爆炸问题。

梯度消失会导致长时依赖问题,从而使得RNN随着时间间隔的不断增大,丧失学习到连接远距离的信息的能力。

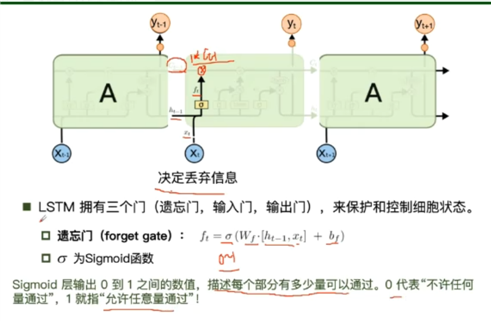

遗忘门

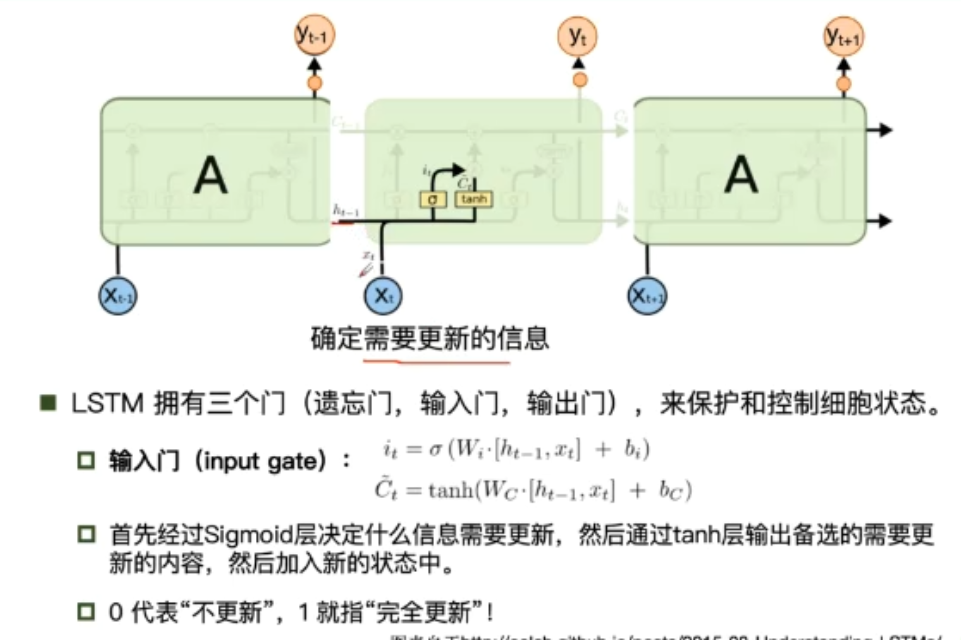

输入门

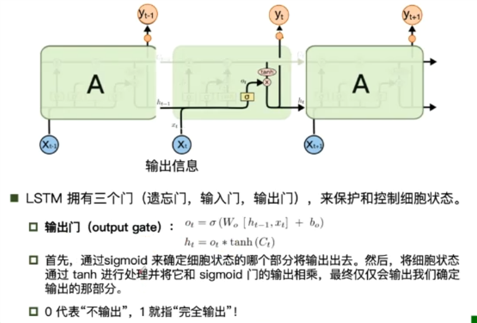

输出门

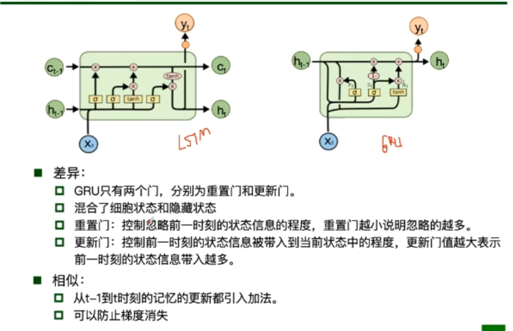

传统RNN与LSTM的不同

GRU只有两个门,分别是重置门和更新门,重置门主要是用来控制上一时刻状态信息保留的多少,而更新门则控制上一时刻用以计算当前时刻数据的影响的大小,更新门值越大则表示前一时刻的状态信息带入的越多

标签:引入 翻译 问题 卷积神经网络 cloc loading com rate learn

原文地址:https://www.cnblogs.com/zhihaoli/p/13543917.html