标签:mic 今天 简单 ola 业界 search into cat 影响力

https://mp.weixin.qq.com/s/VyKUmG512pFJ3XTgVf4QjgBy 超神经

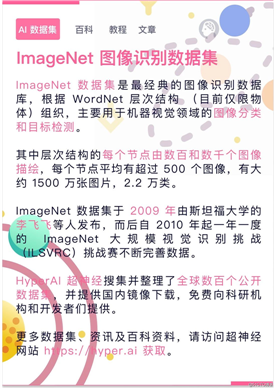

场景描述:作为最经典的数据集,ImageNet 引领了计算机视觉的飞速发展。那么这个数据集建立的背后,又经历了哪些挑战,它又是如何影响了深度学习的发展,在机器学习火热的今天,又能带给我们什么样的启发?

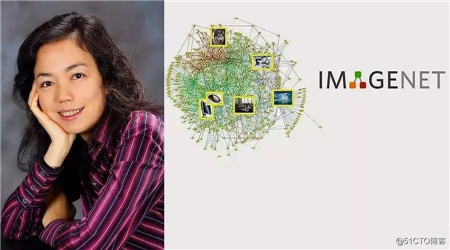

关键词:ImageNet 数据集 李飞飞 深度学习著名的计算机科学家李飞飞,曾在多个场合说过:人工智能会改变世界,那谁会改变人工智能?

李飞飞之所以在行业中举足轻重,每一句话都能引发行业震动,不仅因为她多项重要的研究成果。很重要的一点,就是她着手建立了 ImageNet 项目,对整个行业起到了重要的推动作用。

计算机视觉是当前 AI 发展最好的一个方向。而 ImageNet 是这个领域里经典的数据集,不夸张的说,如果没有 ImageNet,现在的面部识别都会是一种奢望。

ImageNet 是由李飞飞等人在 CVPR 2009 一篇论文中推出,ImageNet 数量之大,质量之高都是空前的。它包含标注过的 1500 万张图片,涵盖 22000 种类别,旨在教计算机认识这个世界的多样性。

ImageNet 带动了计算机视觉方向的飞速发展

最近十年来,发布 ImageNet 的介绍论文《ImageNet: A Large-Scale Hierarchical Image Database》影响巨大,在 Google Scholar 上,该论文目前被引用 11914 次。

而另一篇论文描述了 ImageNet 数据挑战赛,以及物体识别领域的研究进展的论文《ImageNet Large Scale Visual Recognition Challenge》,引用量也达到了惊人的 11056 次。

谷歌学术中两篇论文的引用量都高的惊人

ImageNet 成为了计算机视觉识别领域的标杆,它还引领了行业走向优质数据集的时代:在 2010 年之后,谷歌、微软等大厂,以及多个研究所都相继开始推出高质量的数据集。

ImageNet 也经受住了时间考验,在 2019 年的顶会 CVPR 上,表彰十年以来对计算机视觉影像最深远的奖项——Longuet-Higgins 奖,毫无悬念地颁给了发布 ImageNet 的论文。

回到 2009 年,业界内的主流思想还在于模型,体现在理论上、手动编码的机器学习,以及用数学的方法去解决通用难题。

而李飞飞做了很「另类」的事情,正如她后来在采访所说的,「做研究要做长远的有影响的,不要只看眼前的潮流,要致力于做踏实、有影响力的研究。」

2006年,李飞飞在伊利诺伊大学香槟分校担任计算机教授,她发现整个圈子都在研究更好的算法指定策略,但却轻视了数据的作用。

她通过冷静的分析,看到了这样做的弊端:如果使用的数据,都是用于研究而制作出来的,就无法反映真实世界的状况,即使最好的算法也没有意义。

这让她下定决心,打算在数据上做文章。

十年前的计算机识别物体,还是抓取特征,然后给出结果。但这样弊端很多,比如针对同一物体的多种姿态和角度,计算机抽象出来的模型,经常会出现认错的情况。

最大的问题在于:训练数据的单一性,如果喂给计算机的只是一类图片,就会训练出「刻板」的认知,一旦稍有改变,它就辨认不出来了。

李飞飞很敏锐地发现,这个问题将是计算机视觉的最大瓶颈。

要解决这个问题,李飞飞的的思路回归到了人的身上,她的理解里,一个三岁的小孩能够认识并分辨物体,是因为通过眼睛看到了大量的物体,收集了大量的图像。

如果把大量标注过的图片「喂」给计算机, AI 也许就能学会认识图片。按照这个思路发展,最关键的还在于数据,但如何建立起一个全面的体系呢?

在这个时候,一个叫 WordNet 的项目,出现在李飞飞的视野里。

这是根据词汇分类的方式,建立起来的英语体系结构,每个单词会按照和其他单词的关系来显示,整个项目涵盖了世界上大量物体的单词。

ImageNet 层次结构源自 WordNet

在 2006 年会见了 WordNet 的研究者 Christiane Fellbaum 教授之后,李飞飞有了答案:她要模仿 WordNet 的方式,建立起一个大的数据集,为每个单词提供示例的图片。

次年,李飞飞于普林斯顿大学任职期间,启动了 ImageNet 项目,开始组建团队来完成这行巨大的工作,他们的目标是:得到足够多的标注图像,建立起一完整庞大的图片体系。

但这项工作任务量实在太大,起初他们想雇用大学生们,通过查找筛选和标记在线图片,添加到数据集中。

但很快李飞飞就意识到,这种采集图像的速度太慢了。粗略估计来看,如果一个人一刻不停,不吃不喝地标记,也需要几十年之久。

一个偶然的机会,李飞飞又发现了转机。经人介绍,他们知道了亚马逊 Mechanical Turk 在线众包的方式,在这个平台上,雇主可以在线雇佣很多人来完成一些简单标记。

亚马逊 Mechanical Turk 用于图片分类的界面

最终通过使用亚马逊的众包服务,有 167 个国家的 49000 人次,花费两年半的时间完成了这项巨大的工程。

在历经了不被支持、资金不足、人手匮乏的多重挑战之下,ImageNet 还是在他们的坚持下,顽强地诞生了。

作为新生事物,ImageNet 一开始还没有得到重视,在 2009 年的会议 CVPR 上,ImageNet 的论文只作为一个研究海报,张贴在不显眼的位置。

而这一现状,随着 ImageNet 衍生的挑战比赛,被彻底的扭转了。

ImageNet 发布一年之后,在李飞飞等人的努力下, ImageNet 大规模视觉识别挑战(ILSVRC)出现了。

ILSVRC 也被称为 ImageNet 比赛,它从 2010 年开始,一年一度地召开。在这个比赛上,参赛者要用 ImageNet 数据集作为标准,来评估它们在大规模物体检测和图像分类上的性能。

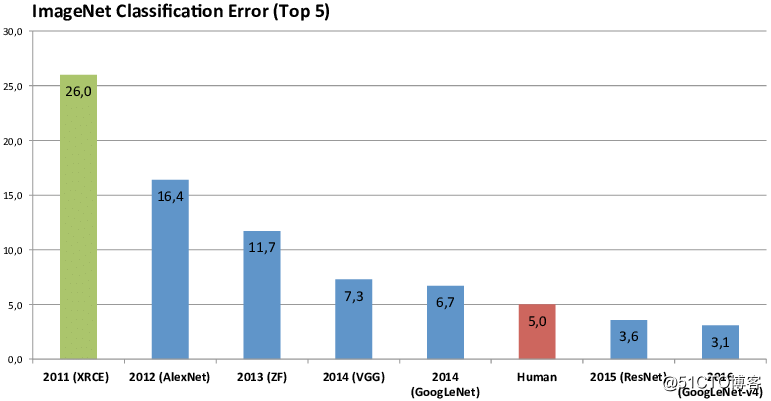

ImageNet 挑战赛图片分类的错误率逐年减低,

已经超过人类(5.0)

很快这项赛事就成了筛选算法竞赛中的奥林匹克。各大机构纷纷拿它作为练兵场,测试自家算法优劣。一时间,各种突破和成果也纷纷涌现。

但 ImageNet 大赛最高光的一幕,还在于它促进了神经网络和深度学习的腾飞。

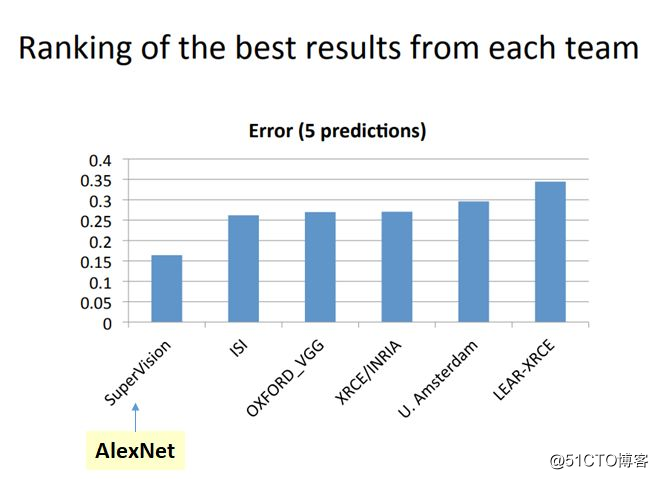

在 2012 年的 ImageNet 竞赛中,Hinton 带领团队参赛,在那一年,Hinton 团队使用的深度学习方法,在识别图片的比赛中一骑绝尘,远远超过其他所有的方法。他们提交了的深度卷积神经网络结构模型 Alexnet,足足提升了 10.8 % 的性能,比第二名的成绩高出 41%。

深度学习的奠基人、2018 图灵奖得主:Hinton

这是什么概念呢?在当时,1% 的性能提升都会是「Major Contribution」(突出贡献),而神经网络这种沉寂了十多年的方法,竟然超过了 10 个百分点,瞬间就引发了巨大地震。

AlexNet 当时的错误率是 0.16422

第二、三名是 0.2617 和 0.2679

在此之前,深层的神经网络并没有如此经历过如此规模的数据训练,而 AlexNet 之后,深度神经网络的优秀能力在 ImagNet 的映衬下完全被彰显。

两年之后,ImageNet 挑战赛的队伍,全部都使用了深度学习。

在 2017 年,历经八年之后,ImagNet 挑战赛的使命完成了:计算机的识别错误率已经低于人类。已经成熟的 image identification 不再具有挑战,新的征程指向了 image understanding ,于是大赛走向了圆满的落幕。

借着 ImageNet 和挑战赛的推动,计算机对物体分类的准确率从 71.8% 上升到 97.3%,远远超过了人类的水平。

回顾 ImageNet 的建立过程,在当时并不是主流的工作,但这件「逆潮流」的事情,却因为李飞飞等人的坚持,最终推动了 AI 的历史进程。同时,李飞飞也因为 ImageNet ,在计算机视觉领域留下了最浓重的一笔。

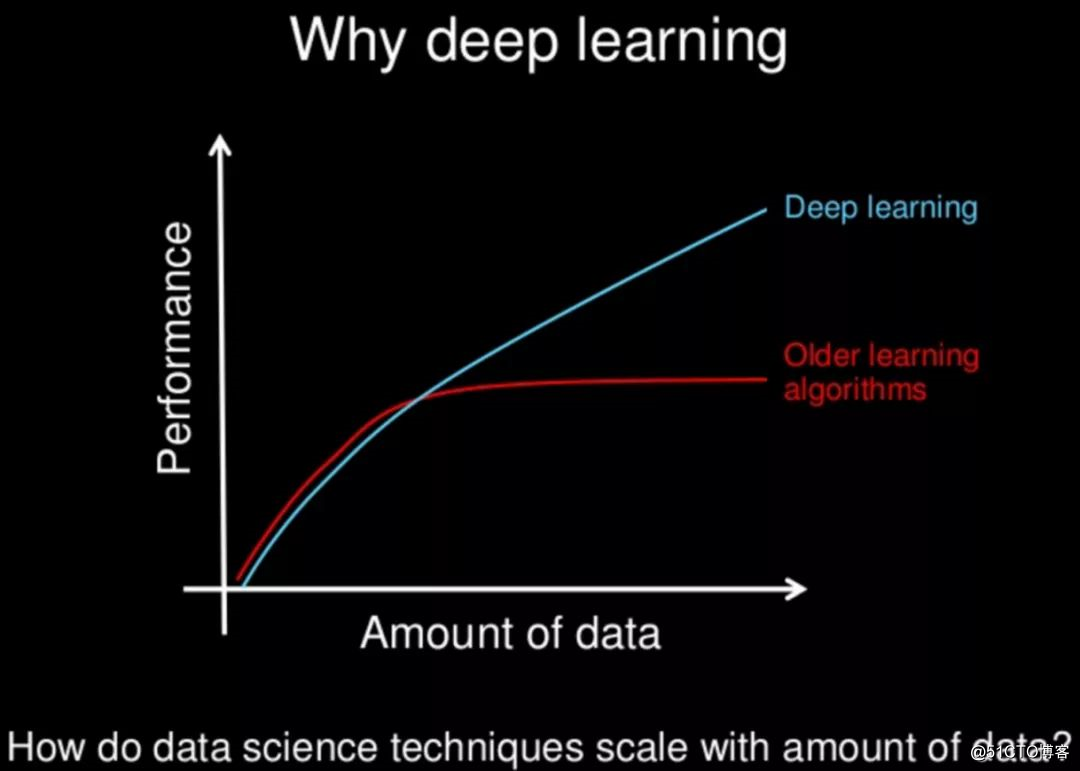

大规模数据对深度学习的重要性

如果数据比作机器学习的「火箭燃料」,而 ImageNet 无疑是第一桶、分量最足的燃料。

正如李飞飞团队所说的那样,「你不一定要做最流行的事情,但一定要做自己相信、会有影响的事情。」

参考资料:

2.How we‘reteaching computers to understand pictures

https://www.ted.com/talks/fei_fei_li_how_we_re_teaching_computers_to_understand_pictures

3.CVPR 2019 Attracts 9K Attendees; Best Papers Announced; ImageNet Honoured 10 Years Later

https://medium.com/syncedreview/cvpr-2019-attracts-9k-attendees-best-papers-announced-imagenet-honoured-10-years-later-bc244888907a

5.ImageNet 出版和引用情况

http://image-net.org/about-publication

6.Large ScaleVisual Recognition Challenge

http://image-net.org/challenges/LSVRC/

—— 完 ——

扫描二维码,加入讨论群

获得优质数据集

回复「进群」自动入群

更多精彩内容(点击图片阅读)

标签:mic 今天 简单 ola 业界 search into cat 影响力

原文地址:https://blog.51cto.com/14929242/2535124