标签:ade 打开 ora 解决 id_rsa 安全模式 通过 blog mapred

? 在 Linux(VM15pro/CentOS8) 环境下完成Hadoop-3.2.1伪分布式环境的搭建,并运行 Hadoop 自带的 WordCount 实例检测是否运行正常。

? Java 环境可选择 Oracle 的 JDK,或是 OpenJDK,现在一般 Linux 系统默认安装的基本是 OpenJDK。通过 yum 进行安装 JDK,安装过程中会让输入 [y/N],输入 y 即可:

[root@localhost ~]# yum install java-1.8.0-openjdk java-1.8.0-openjdk-devel

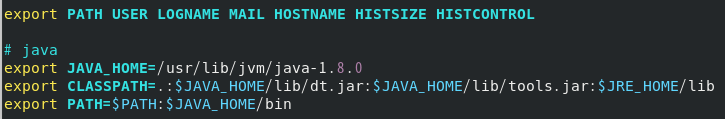

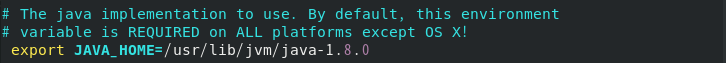

? 接着我们需要配置Java的环境变量,打开/etc/profile文件最后面添加如图内容,并让该环境变量生效。

[root@localhost ~]# source /etc/profile

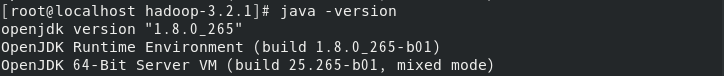

? 测试Java版本信息,了解环境变量配置是否成功

[root@localhost ~]# wget https://mirrors.bfsu.edu.cn/apache/hadoop/common/hadoop-3.2.1/hadoop-3.2.1.tar.gz

[root@localhost ~]# tar -xzvf hadoop-3.2.1.tar.gz

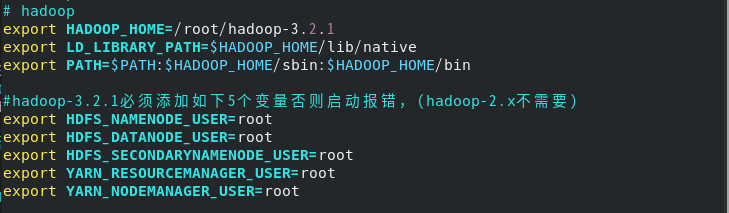

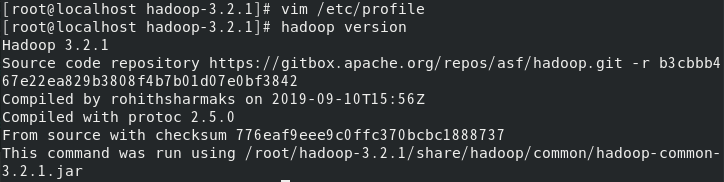

? 将hadoop配置写入/etc/profile中,并测试是否配置成功。

? 1、修改 hadoop-3.2.1/etc/hadoop/hadoop-env.sh,取消并修改添加export JAVA_HOME=,使其值为我们解压出jdk的位置。

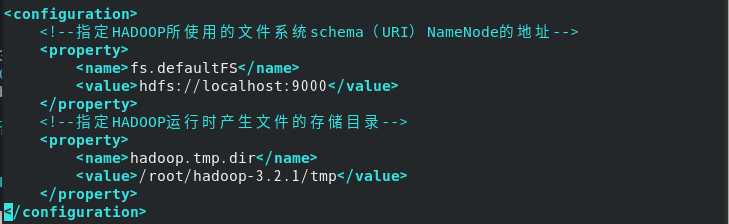

? 2、修改hadoop-3.2.1/etc/hadoop/core-site.xml

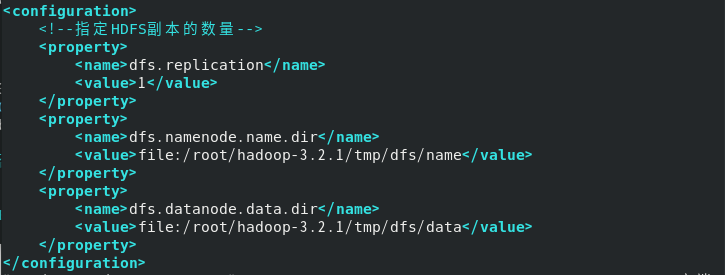

? 3、修改hadoop-3.2.1/etc/hadoop/hdfs-site.xml

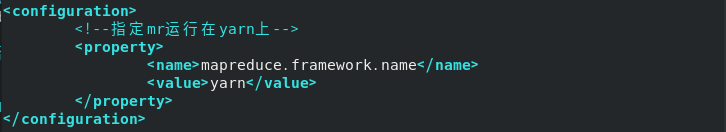

? 4、修改hadoop-3.2.1/etc/hadoop/mapred-site.xml

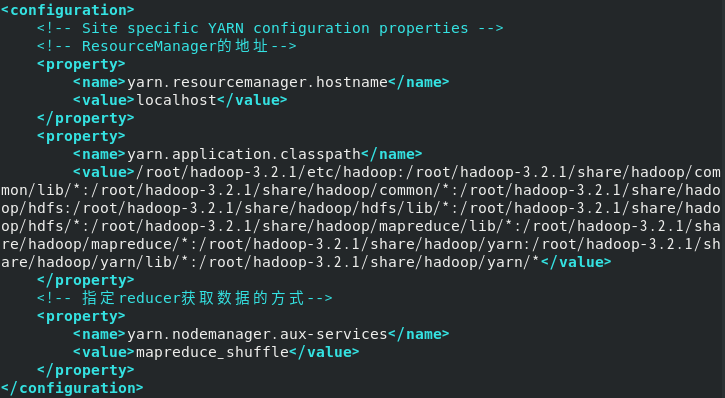

? 5、修改hadoop-3.2.1/etc/hadoop/yarn-site.xml

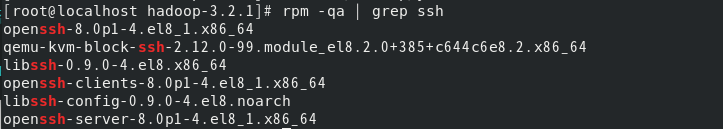

? 执行下面命令检测是否已安装ssh

? 利用 ssh-keygen 生成密钥,并将密钥加入到授权中,配置成SSH无密码登陆

[root@localhost hadoop-3.2.1]# ssh localhost # 测试

[root@localhost hadoop-3.2.1]# exit # 退出刚才的 ssh localhost

[root@localhost hadoop-3.2.1]# cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

[root@localhost hadoop-3.2.1]# ssh-keygen -t rsa # 会有提示,都按回车就可以

[root@localhost hadoop-3.2.1]# cat id_rsa.pub >> authorized_keys # 加入授权

[root@localhost hadoop-3.2.1]# chmod 600 ./authorized_keys # 修改文件权限

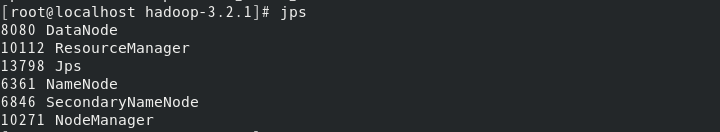

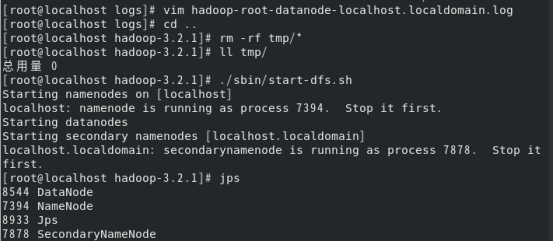

? 1、格式化NameNode,使用start-all开启所有进程,并且使用jps查看进程情况。

[root@localhost hadoop-3.2.1]# hdfs namenode -format

[root@localhost hadoop-3.2.1]# start-all.sh

[root@localhost hadoop-3.2.1]# jps

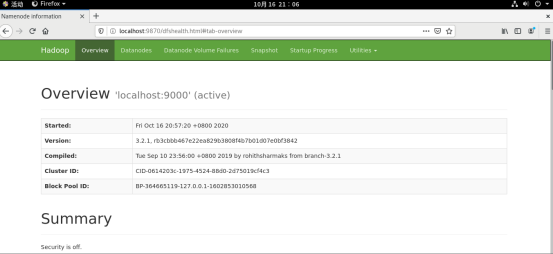

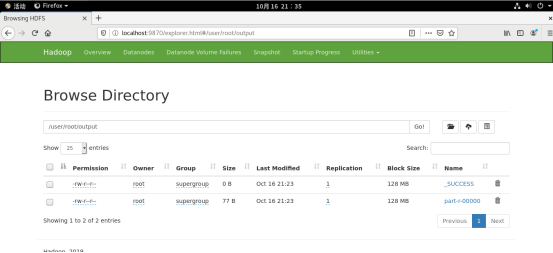

? 2、浏览器进行hadoop服务的访问,http://localhost:9870

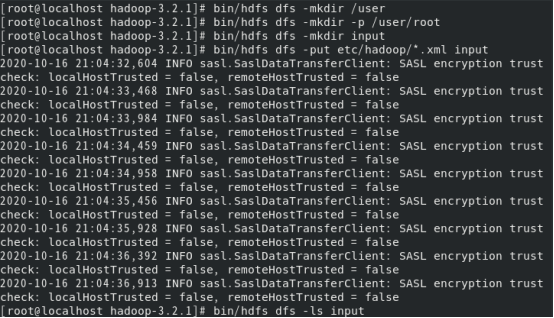

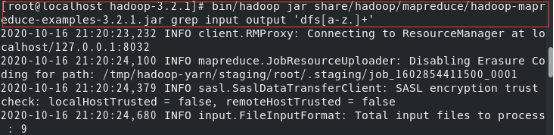

? 1、单机模式读取的是本地数据,伪分布式读取的则是 HDFS 上的数据。要使用 HDFS,首先需要在 HDFS 中创建用户目录,接着将 ./etc/hadoop 中的 xml 文件作为输入文件复制到分布式文件系统中 。

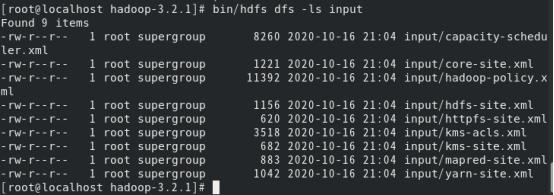

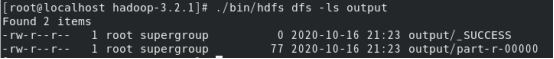

? 2、复制完成后,可以通过如下命令查看 HDFS 中的文件列表:

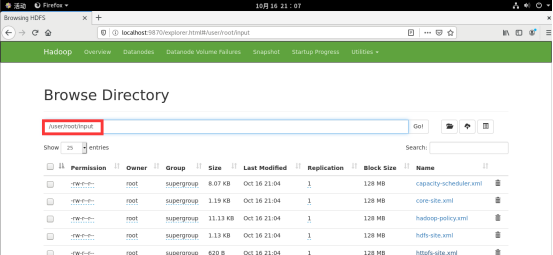

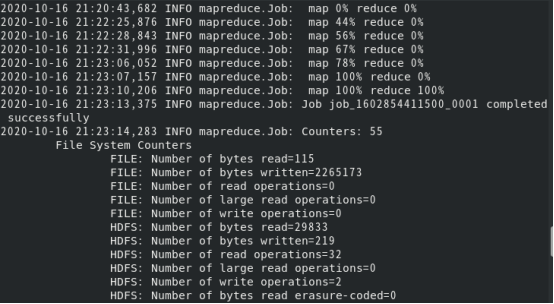

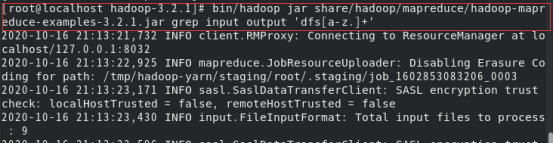

? 3、伪分布式读取的是HDFS中的文件,运行 MapReduce 作业

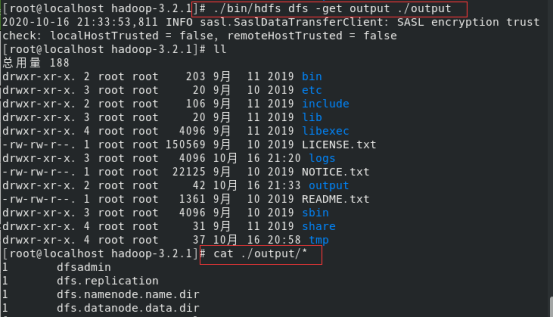

? 4、将输出文件从分布式文件系统复制到本地文件系统并查看

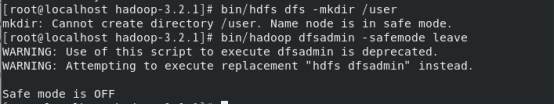

? 1、HDFS创建用户目录时报“Name node is in safe mode”,使用下面命令退出安全模式。

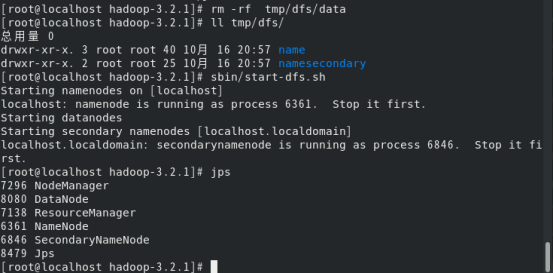

? 2、jps发现DataNode进程没有开启,查看日志发现报没法找到/dfs/data目录,造成原因是在每次执行hadoop namenode -format时,都会为NameNode生成namespaceID,,但是在hadoop.tmp.dir目录下的DataNode还是保留上次的namespaceID,因为namespaceID的不一致,而导致DataNode无法启动,解决方法如下:

? 3、jps发现NameNode进程没有开启,日志报错是/tmp/hadoop-hadoop/dfs/name目录不存在或目录不可访问,解决方法是重新格式化文件系统如下:

HADOOP_HOME/sbin/stop-all.sh #先停止hadoop相关进程

HADOOP_HOME/bin/hdfs namenode -format #重新格式化文件系统

HADOOP_HOME/sbin/start-all.sh #重启hadoop,此时hadoop的相关进程正常启动

? 4、要是上面情况出现依次走到这里,又发现jpsDataNode进程没有开启,这时候删掉/dfs/data文件,重启服务就行。

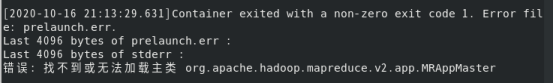

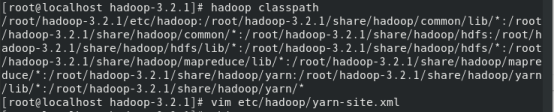

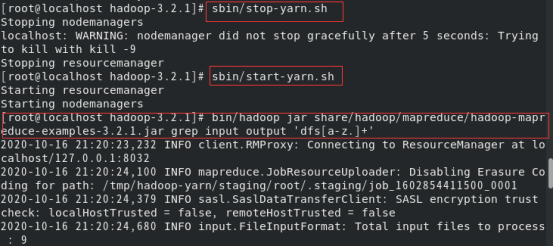

? 5、运行wordcount报错找不到或无法加载主类,设置classpath,重启yarn服务,具体如下:

[https://www.cnblogs.com/hanhaotian/p/11754393.html]:

[https://blog.csdn.net/weixin_49736959/article/details/108815976]:

[https://blog.csdn.net/haveqing/article/details/106006860]:

标签:ade 打开 ora 解决 id_rsa 安全模式 通过 blog mapred

原文地址:https://www.cnblogs.com/wys7541/p/13831280.html