标签:http inf fan style 更新 idg var 机器学习 img

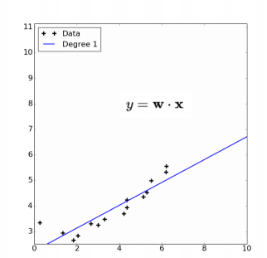

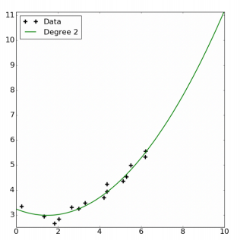

X,Y是线性的

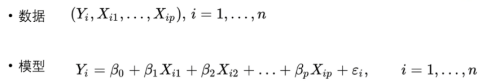

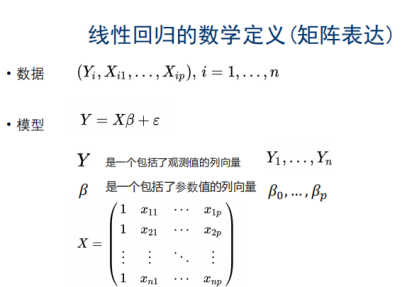

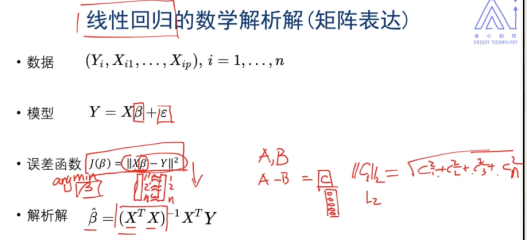

是偏置(有点像截距),防止Y为0,矩阵表示时,为全1

是偏置(有点像截距),防止Y为0,矩阵表示时,为全1

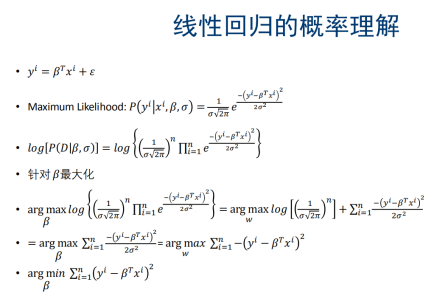

:数据集收集的时候有误差(高斯误差,均值为0)

:数据集收集的时候有误差(高斯误差,均值为0)

表达向量很相似

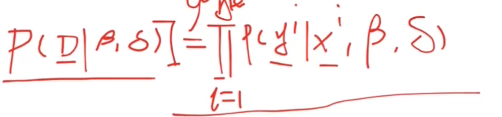

D: 和

和 ,代表所有的数据,

,代表所有的数据, 和

和 相互独立

相互独立

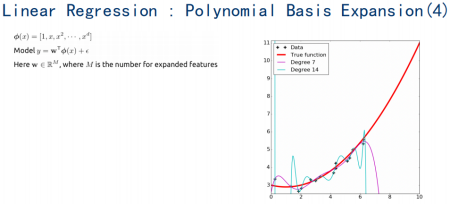

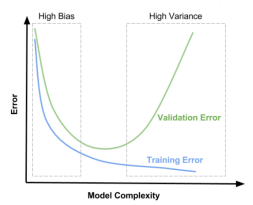

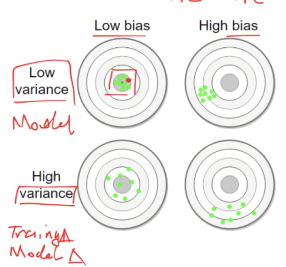

过拟合

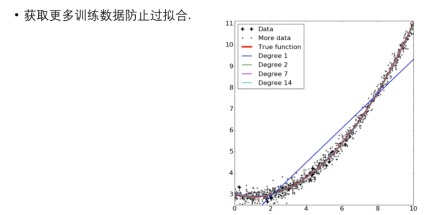

获取更多训练数据防止过拟合

模型与train和valid集的关系

High Varinance:数据对于模型的影响很大

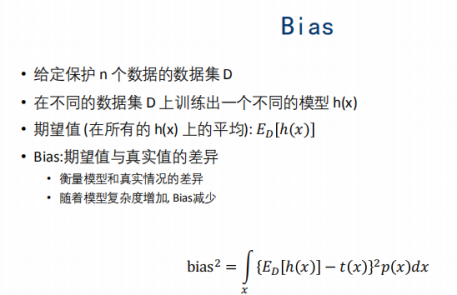

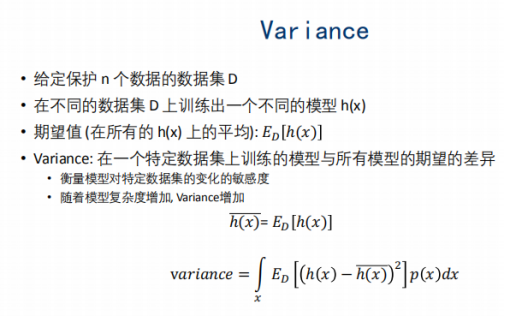

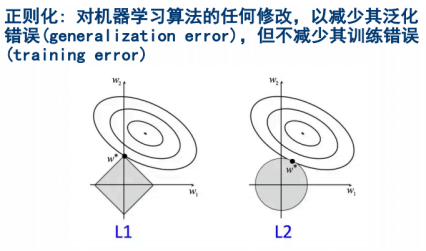

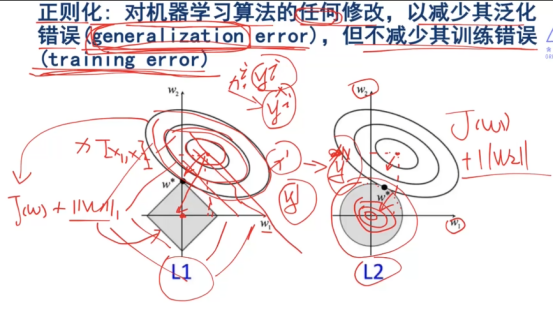

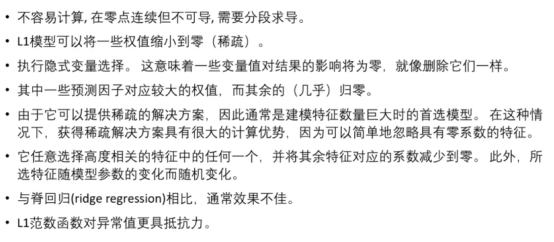

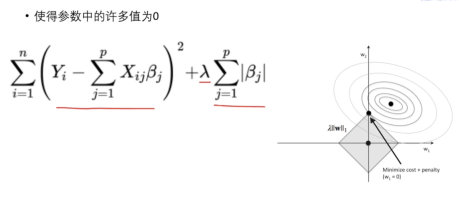

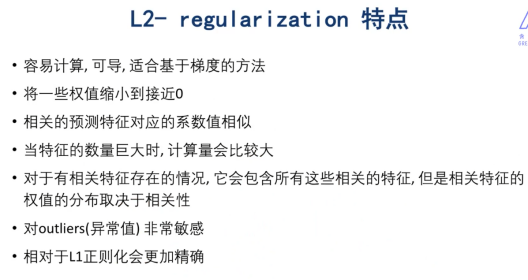

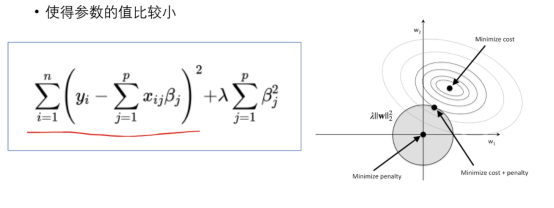

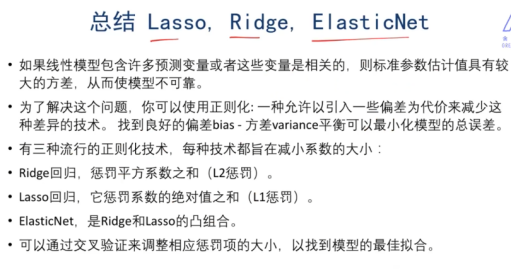

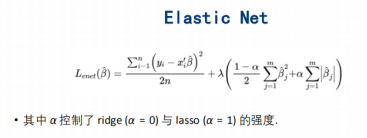

解决一个bias和variance之间的平衡问题。

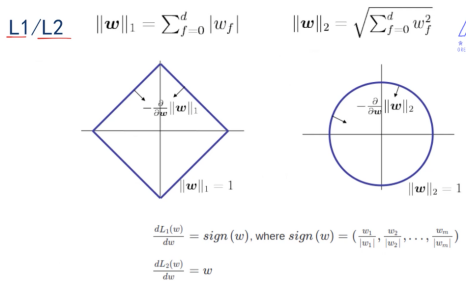

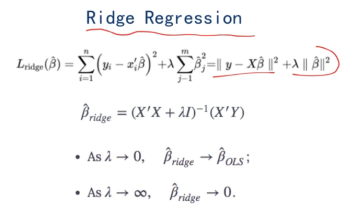

梯度的反方向朝着圆心,圆心取得最小值

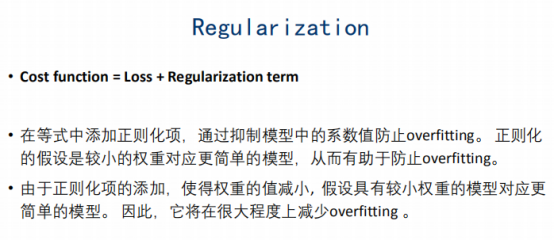

综合损失函数和正则化的函数的等高线拼接在一起,得到最小值

Lamda 的大小可调整

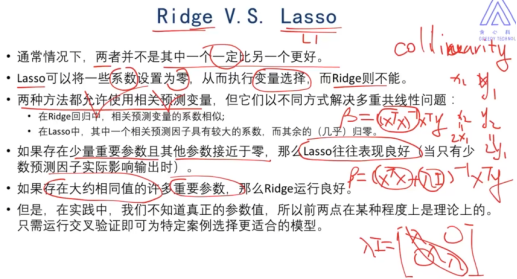

Lasso可以相当于做了一系列的特征工程,但是ridge做不到

允许相关预测变量的存在:是因为当lamda足够大的时候可以忽略x*x^T

实际模型应用中,需要交叉验证进行测试,看看L1好还是L2好,应该选择啥

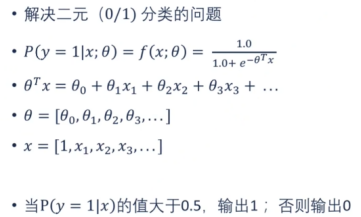

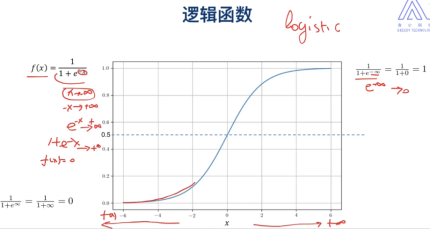

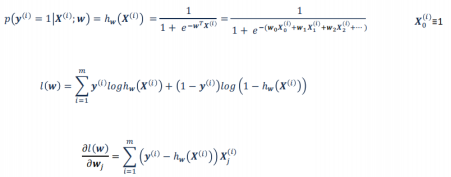

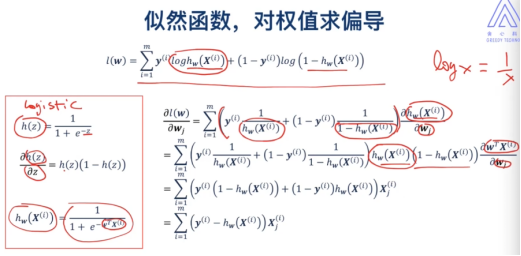

逻辑回归=分类!= 回归

希望我们y在[0,1]

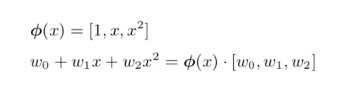

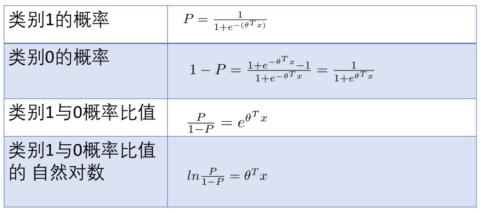

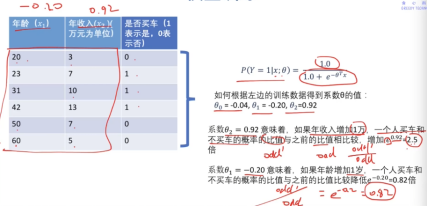

因为sigmod的特殊性,我们可以用线性的方式来表示非线性:

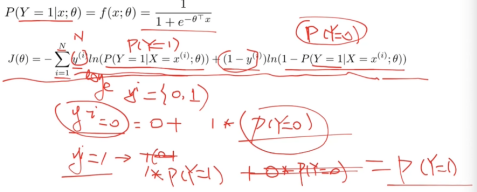

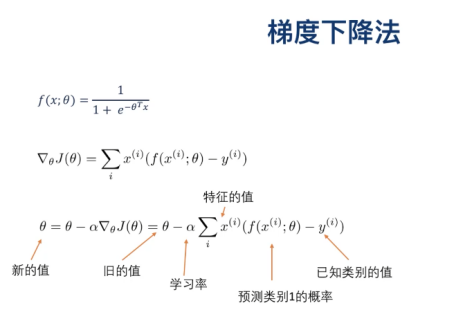

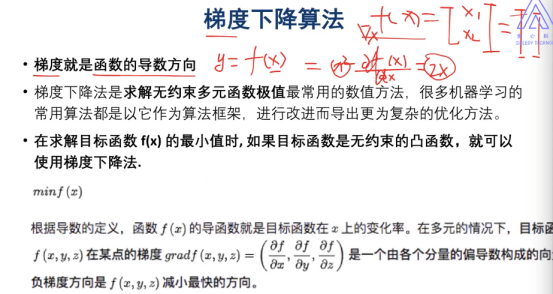

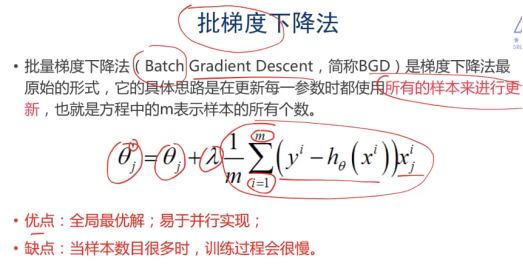

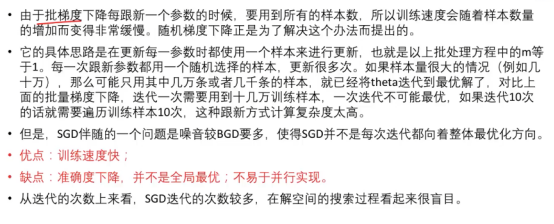

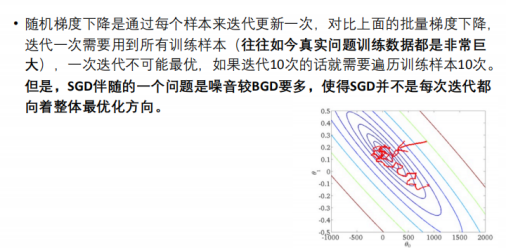

梯度下降法更新

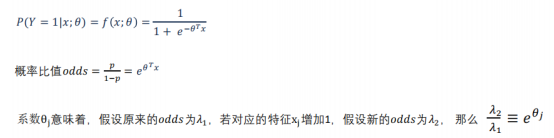

逻辑回归的 的物理意义:

的物理意义:

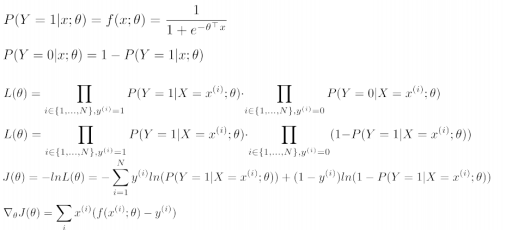

似然函数和损失函数之间差了个‘负’

标签:http inf fan style 更新 idg var 机器学习 img

原文地址:https://www.cnblogs.com/Towerb/p/14014771.html