标签:ppt 知识点 金融 val 为什么 公众 disco 观测 课堂

本文我们总结一下马尔科夫决策过程之Markov Reward Process(马尔科夫奖励过程),value function等知识点。

马尔科夫奖励过程在马尔科夫过程的基础上增加了奖励R和衰减系数γ:<S,P,R,γ>。

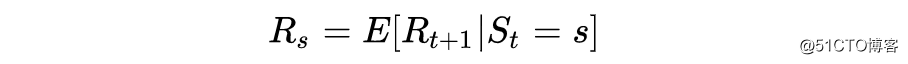

R是一个奖励函数。S状态下的奖励是某一时刻(t)处在状态s下在下一个时刻(t+1)能获得的奖励期望,如下:

这里大家可能有疑问的是为什么 Rt+1而不是Rt,我们更倾向于理解起来这相当于离开这个状态才能获得奖励而不是进入这个状态即获得奖励。视频中也有学生请教了David。

David的回答:David指出这仅是一个约定,为了在描述RL问题中涉及到的观测O、行为A、和奖励R时比较方便。

他同时指出如果把奖励改为Rt而不是Rt+1,只要规定好,本质上意义是相同的,在表述上可以把奖励描述为“当进入某个状态会获得相应的奖励”。大家认为是约定就好。

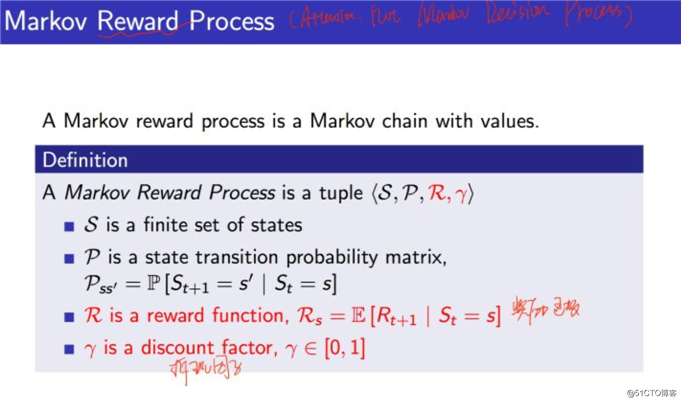

详细的定义如下:

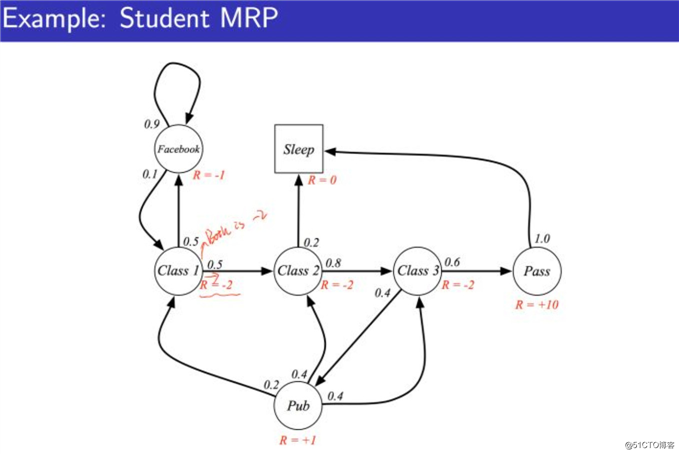

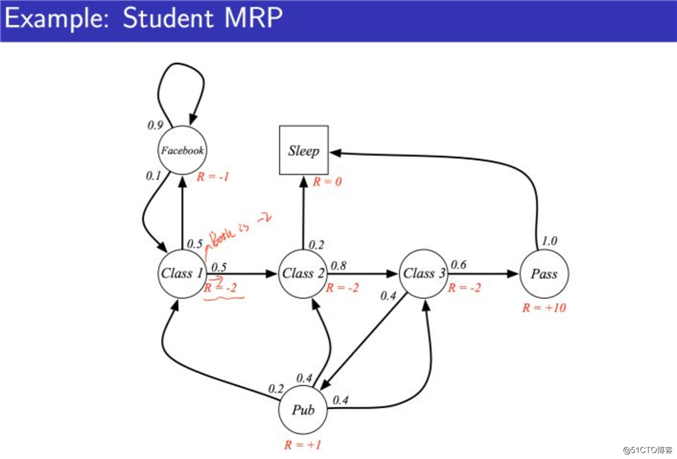

下图是一个“马尔科夫奖励过程”图示的例子,在“马尔科夫过程”基础上增加了针对每一个状态的奖励。

举例说明:当学生处在第一节课(Class1)时,他/她参加第2节课(Class2)后获得的Reward是-1;同时进入到浏览facebook这个状态中获得的Reward也是-1。

在浏览facebook这个状态时,会有在下一时刻继续浏览获得的Reward为-1,返回到课堂内容上来的获得的Reward为-1。

当学生进入到第二节课(Class2)时,继续参加第三节课(Class3)获得的Reward为-2,较进行Sleep的Reward为-2。

当学生处于第三节课这个状态时,他通过考试的Reward为+10,进行到其它状态的Reward也是同样道理。

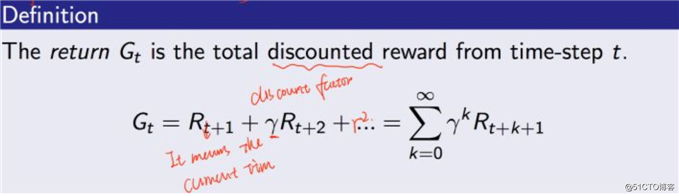

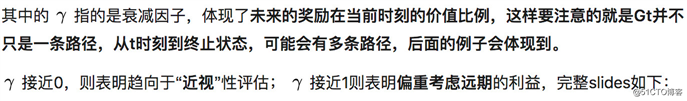

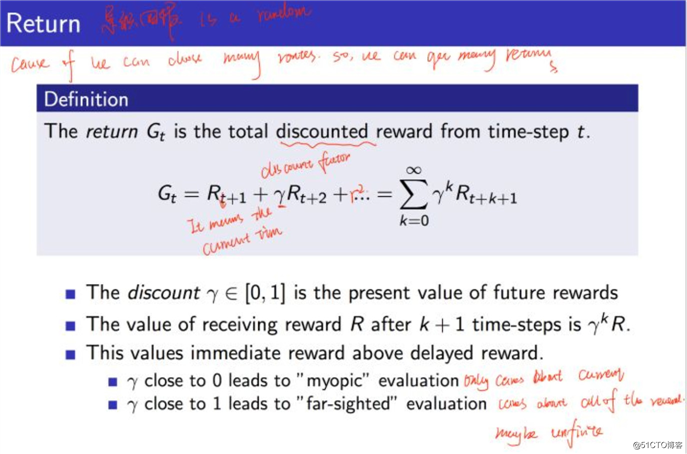

定义:收获Gt为在一个马尔科夫奖励链上从t时刻开始往后所有的奖励的有衰减的收益总和。

定义公式如下:

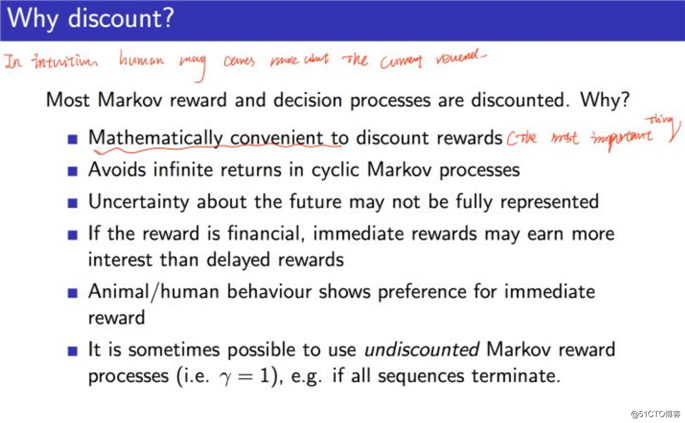

关于Return的计算为什么需要 折扣系数。David给出了下面几条的解释:

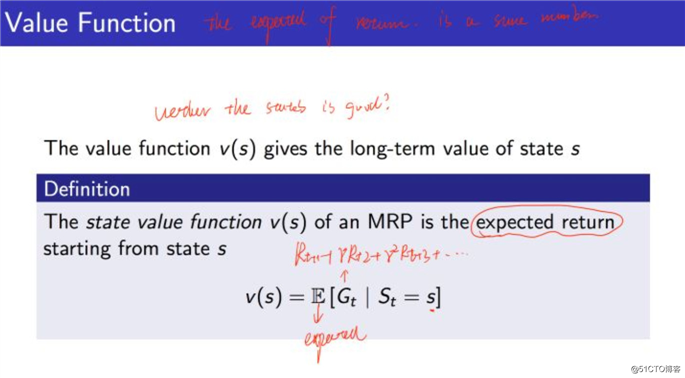

价值函数给出了某一状态或某一行为的长期价值。

定义:一个马尔科夫奖励过程中某一状态的价值函数为从该状态开始的马尔可夫链收获的期望:

为什么会有期望符号,因为Gt我们在上面说过,从t时刻到终止状态的马尔科夫链不止一条,每一条都有对应的概率和Return收益,所以对应的概率乘以相应的收益自然就会有期望符号,ppt如下:

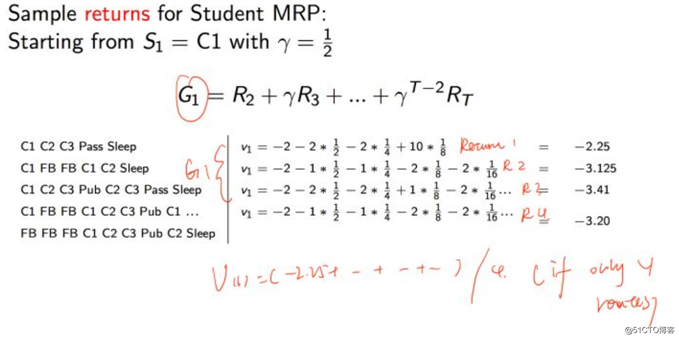

我们来看G1的例子:

上图的计算其实就是对下面这个Markov Reward Process图的计算:

我们能够看出G1其实就有4条路径了,每一条路径都有对应的概率,那么从我们就能理解value function在评估某个状态下的价值的时候,是需要加上期望符号的。

而上面这个例子如果计算value function为(如果总共只有这四条路径,并且每条的概率为1/4):

v(s) = (-2.25+(-3.125)+(-3.41)+(-3.20))/4 =2.996

暂时总结到这,下一讲总结Bellman Equation, Markov Decision Process等知识点~

参考:

David Silver深度强化学习课程

第2课 - 马尔科夫决策过程叶强:《强化学习》第二讲 马尔科夫决策过程

马尔科夫决策过程之Markov Processes(马尔科夫过程)

【深度学习实战】pytorch中如何处理RNN输入变长序列padding

【机器学习基本理论】详解最大后验概率估计(MAP)的理解

欢迎关注公众号学习交流~

马尔科夫决策过程之Markov Reward Process(马尔科夫奖励过程)

标签:ppt 知识点 金融 val 为什么 公众 disco 观测 课堂

原文地址:https://blog.51cto.com/15009309/2554225