标签:类型 美的 阶段 tps 不兼容 其它 评分 直接 不为

算法当然是种族主义者,因为它是人类的产物。

——斯蒂芬·布什(《新政治家》周刊美国版编辑)

大多数时候,机器学习并不涉及特别敏感的社会、道德或伦理问题。数据集可以根据给定的属性预测房价,或将图片分成不同类别,或教会电脑玩《吃豆人》游戏的最佳方式。

但是如果数据在进行预测时涉及受保护的属性,那么根据反歧视法,我们要怎么做呢?如何确保算法中不会植入直接或间接的种族主义、性别歧视或其它潜在的偏见呢?

美国已经有过几起关于这个话题的重要诉讼。其中最引人注目的是Northpointe公司推出的COMPAS(有关替代性制裁的惩教罪犯管理概况)软件,它可以预测被告再次犯罪的概率。该软件中的专有算法是基于一个有137个问题的问卷的部分答案来预测这种风险的。

2013年2月,警方发现Eric Loomis正驾驶着一辆曾在某场枪击案中使用过的汽车。随后他被逮捕,并承认犯有逃避警察追捕罪。在量刑审判时,法官不仅要看他的犯罪记录,还要看COMPAS软件给判定的分数。

COMPAS是目前在美国各地使用的几种风险评估算法之一,可用于预测暴力犯罪的热点地区,确定囚犯可能需要的监管类型,或者像Loomis的案例一样,提供对量刑可能有用的信息。最后COMPAS将Loomis列为再次犯罪的高风险人物,他被判处六年徒刑。

他上诉的理由是,法官在考虑算法的结果时,违反了正当程序,因为该算法的内部工作是保密的,无法进行检查。上诉被提交到威斯康星州最高法院,该法院否决了这一上诉,指出即使不参考COMPAS软件,判决仍然一样。然而,法院的裁决使得人们对算法的使用开始持谨慎和怀疑的态度。

可想而知,这个案例在机器学习领域引起了不小的轰动。毕竟不是所有人都想被算法审判,但是我们又不能责怪算法缺乏职业操守,难道不是吗?

到2014年,该软件引起的争议变得更加激烈。

从算法中剔除更具争议的结果并仔细检查后,它再次吸引了公众的目光。美国司法部长Eric Holder警告称,风险评分可能会为法院带来偏见。他呼吁美国量刑委员会研究其使用情况。他说:“尽管这些措施的出发点是好的,但我担心它们会在无意中破坏我们在确保个性化和司法平等方面所做的努力。”他补充说,“这些措施可能会加剧我们在刑事司法和社会中出现的非常普遍的毫无根据且不公正的差异。”

然而,量刑委员会没有开展风险评分研究,但ProPublica做到了,它能在部分程度上进一步审查算法在美国人生活中隐藏的重大影响。

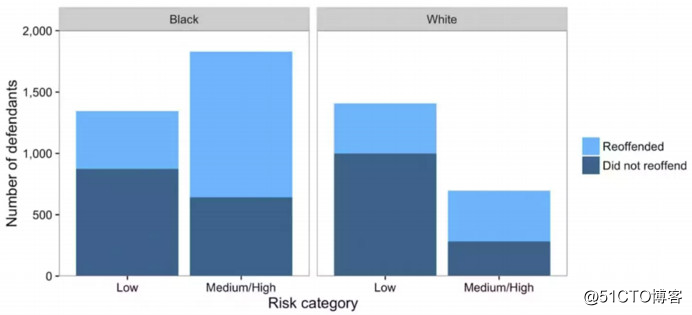

ProPublica的审查得出了一些有趣的结论。正如Holder所担心的那样,该算法不仅惊人的不准(准确性不到20%),而且还显示出明显的种族差异。在预测谁会再次犯罪时,该算法对黑人和白人被告的预测上犯了错误,虽然犯罪比率大致相同,但是犯罪方式截然不同。

这种模式特别容易错误地将黑人被告标记为未来的罪犯,并且以这种方式为黑人被告贴上错误的标签的概率几乎是白人被告的两倍。白人被告比黑人被告更容易被错误地贴上低风险的标签。黑人被告被认为仍有可能犯下暴力犯罪的风险高达77%,犯下任何罪行的可能性达到45%。

这可能听起来很糟糕,但是这个故事比表面上看的要复杂得多。根据分析的方式,发现算法既带有种族主义,又不存在种族主义,这取决于我们在模型中定义“平等”的方式。模型实际上是以人们可以接受的方式设计的,但仍然可以产生据称的带有种族主义的结果,对于这点,我们将在本文接下来的部分进行解释,帮助理解。

首先需要定义算法中可能存在的歧视类型,以及在前面的示例中涉及到的类型。我们把两种形式的歧视称为差别影响和差别对待。

差别对待包括以人们不允许的方式对某人进行分类。它涉及到歧视的意图,体现在明确提及群体成员。

差别影响着眼于分类/决策对特定群体的影响,这不需要任何意图,它是表面中立的。

差别影响通常被称为无意识的歧视,而差别对待则是有意识的歧视。

最高法院认为,如果“基于合理的商业考量因素”,对特定群体产生的不成比例的影响的做法,则不会造成差别影响。

如果考虑以下任何受保护属性时,可能会导致差别对待或差别影响。

受保护属性(来自美国平等就业委员会):

年龄

残疾

国籍

种族/肤色

信仰

性别

所有这些属性都可以用作机器学习算法中的特征,因此我们的算法有可能在这些属性的基础上进行区分。一些常见的例子是面部识别、再犯罪可能性和招聘。我们可以做些什么来帮助解决这个问题?

解决差别对待问题很简单。明显的歧视偏见使分类不那么准确,因此没有理由要差别对待。但是,如果歧视已被植入历史数据时要怎么办呢?或者说这些属性是过去社会不公正的结果且至今仍然存在,要怎么办呢?

如果分类和决策基于不正确的信息(例如认为7英尺以上的人都是坏保姆),那么歧视会影响社会商品的流动。这些想法常被人类的偏见所延续,并植入用于训练算法的数据中。

在这种情况下,机器学习算法不会减轻人的偏见。事实上,这些偏见会再现于分类当中。为什么会发生这种情况呢?Northpointe公司的软件所做的再犯评分是基于先前的逮捕记录、初次与警方接触的年龄及父母的入狱记录。这些信息是由世界上的偏见(如文化价值观和民族主义)和更普遍的不公正(如种族偏见)所形成的。

这种偏见也存在于自然语言处理的文本数据中。这方面的一个很好的例子是一篇名为《男人就是计算机程序员,女人就是家庭主妇吗?消除词嵌入向量!》的科研论文,它显示了该软件在向量中自动生成的类比,例如男人→计算机程序员,而女人→家庭主妇。这些例子都反映了原始文本中的性别歧视。

更普遍地说,这些偏差通常来源于:

过采样和欠采样

偏态样本

特征选择/有限特征

代理/冗余编码

世界上存在的偏见和不公正

如何消除这些偏见呢?机器学习算法会使歧视永久化,因为它们是针对有偏见的数据进行训练的。解决方案是识别或生成一个无偏差数据集,从中可以得出准确的归纳。

种族、性别和社会经济阶层特征决定了我们与某些绩效任务的结果相关的其他特征。这些都是受保护的属性,但它们仍然是与某些绩效任务相关,而这些绩效任务则是公认的社会产品。例如:

白人家庭的平均财富是黑人家庭的7倍。

财富与是否能偿还贷款有关。

财富的差异取决于过去和现在的不公正。

机器学习在本质上基于历史事件。为了有效解决歧视问题,需要改变模式。然而,机器学习加强了这些模式。因此,机器学习可能是问题的一部分。

“即使历史是一条向正义倾斜的弧线,机器学习也不会向正义倾斜。”那么我们该何去何从?难道算法注定要带有种族主义和性别歧视吗?即使优化准确性,即使使用的是没有偏见的数据集,执行绩效任务时也考虑到社会产品,机器学习算法也可能永远存在歧视。

我们还能做些什么?

顺序学习

更多理论

因果模型

优化公平

在这些所有措施中,优化公平似乎时最简单且最好的做法。在下一节中,将概述一个优化公平模型的方法。

可以通过以下4种方式构建并优化机器学习算法,以消除歧视:

将非歧视标准正式化

人口统计平等

均衡可能性

良好的校准系统

我们将依次讨论这些问题。

将非歧视标准正式化基本上是其它3种方式也涉及到的内容,这些标准类型旨在使非歧视标准正式化。但是,这份清单并非详尽无遗,可能还有更好的方法尚未提出。

人口统计平等提出决策(目标变量)应该独立于受保护的属性,如种族和性别等与决策无关的属性。

对于二元决策Y和受保护属性A来说:

P(Y=1 ∣ A=0) = P(Y=1∣A=1)

无论受保护的属性是(A=1)还是(A=0),做出某个决策的概率(Y=1)应该是相同的。但是,使用完美预测器C=Y排除了人口统计平等,其中C是预测器,Y是目标变量。

要理解异议,请考虑以下情况。假设想要预测一个人是否会买有机洗发水,且某些团队的成员是否购买有机洗发水并不独立于该团队的全体成员。但是,人口统计平等将排除使用完美预测器。也许这不是最好的程序,也许其他人会给我们更好的结果。

均衡可能性提出预测器和受保护属性应该是独立的,并以结果为条件。对于预测变量R、结果Y和受保护属性A,这三个都是二进制变量:

P(R=1|A=0,Y=1) = P(R=1|A=1, Y=1).

无论是(A=1)还是(A=0),该属性不应该改变对某个相关预测器(R=1)对候选对象是否适用的可能性的估计(P)。相反,某些决定的结果(Y=1)则应该改变。这种方法的一个优点是它与理想预测器兼容,R=Y。

看看以下案例,由于是在毕业典礼上致告别辞的最优生,所以耶鲁大学录取了该生。均衡可能性假定不管是否知道学生是同性恋,都不会改变该生是毕业演讲代表的概率。

预测器R=是(1)或不是(0)高中毕业演讲代表

结果Y=进(1)或不进入(0)耶律大学

属性A= 是(1)或不是(0)同性恋

P(Y=1|A=0,R=1) = P(Y=1|A=1, R=1)

良好的校准系统建议结果和受保护属性互相独立,以预测器为条件。对于预测变量R,结果Y和受保护属性A来说,这三个都是二进制变量。

某些结果发生的概率(Y=1)应该不受某些受保护属性(无论是(A=0)还是(A=1))的影响,而应该取决于相关的预测器(R=1)。这一提法的优点是,不会意识到它使每个人都遵循相同的标准。

与之前的例子相比,知道这个学生是同性恋并不会改变这个学生进入耶鲁的概率。均衡可能性和良好的校准系统之间的区别虽是微妙的,但很重要。

事实上,这种差异是我们开始时讨论的COMPAS软件存在分歧的基础。

均衡可能性和良好的校准系统是两个互不兼容的标准。有时候,在特定的经验条件下,无法同时拥有一个经过良好校准和得到均衡可能性的系统。在ProPublica和Northpointe关于COMPAS是否对黑人被告有偏见的辩论中,我们来看看这个事实。

Y=被告是否会再次犯罪

A=被告的种族

R=COMPAS使用的累犯预测器

Northpointe的辩词:COMPAS软件经过精心校准等等,

P(Y=1|A=0,R=1) = P(Y=1|A=1, R=1)

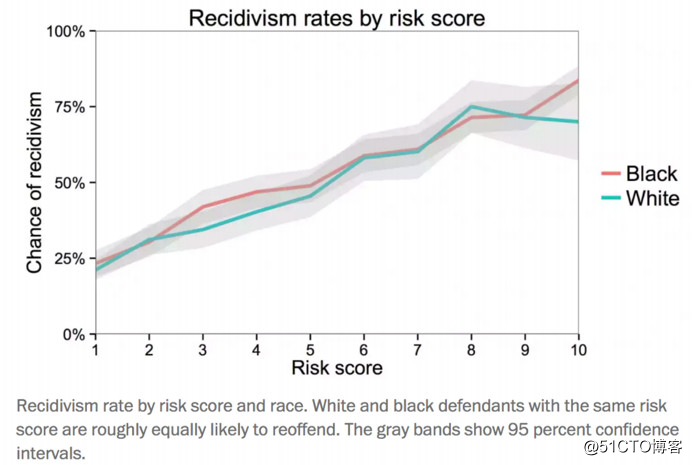

COMPAS系统对被告的累犯预测大致相同,无论其种族如何。

ProPublica的反驳:COMPAS对黑人被告的假阳性率较高,对白人被告的假阴性率较高,即不满足均衡可能性。

P(R=1|A=0,Y=1) ≠ P(R=1|A=1, Y=1)

被告的种族对于个人是处于低风险还是中/高风险类别有所不同。无论是(A = 0)还是(A = 1),COMPAS已经确定一些累犯风险预测因子适合被告(P(R = 1))的概率有所不同,而不仅仅是被告是否会重新犯罪(Y = 1)。

当某些经验事实成立的时候,具有良好校准系统和均衡可能性系统的能力就会出现问题。似乎产生这个问题的原因是我们之前讨论过的东西:不公正造成的背景事实。例如,由于警方审查力度加大,再次犯罪被抓的几率也更高。

很难确定何时适用某些公平的标准。如果某些标准没有为其他标准付出代价,那么不确定时,会更少担心应用它。但是,由于情况并非如此,我们需要了解未达到某些标准的影响。

那么我们讨论的哪个标准最适合选择?所有这些方法都具有很好的特征,但都有其缺点。

我们不能仅在一个小角落里划分公平,而不为了改变世界上的不公正和在机器学习系统之外发生的歧视而抗争。我们必须为某些领域的公平性制定一些标准,同时努力改变基础比率。

尽管存在一些争议以及在一些人中不受欢迎,但COMPAS软件仍在继续使用。开发算法的人不会因为在不知不觉中开发出带有种族主义的算法而被指控或监禁,但必须选择一些标准来对COMPAS试图解决的情况进行预测。

COMPAS 软件可能只是一个算法,它也可能不完美,但这是一个开始,而且必须得从某个地方开始。

机器学习是一个非常强大的工具。随着人类开始从人文主义的视角转向数据主义的视角,这种情况越来越明显:我们开始更多地信任算法和数据,而不是人类或自己的想法(有些人在GPS的导航下,开车开进了湖泊!)。

这使得我们使算法尽可能保持中立,这样他们就不会在不知不觉中在历史数据中永远植入社会的不公,这一点非常重要。然而,算法也有巨大的潜力创造一个更公正和更平等的社会。一个很好的例子就是招聘过程。

假设你正在申请梦寐以求的工作,并且已经进入了面试的最后阶段。招聘经理有权决定你是否被录用。你是否想要公正的算法来决定你是否适合这份工作?

如果你知道招聘经理是种族主义者或性别歧视者,还会更喜欢这样吗?

也许招聘经理是一个非常中立的人,并且纯粹基于绩效来完成工作,然而,每个人都有自己的倾向和潜在的认知偏差,这可能使他们更有可能选择他们最喜欢的候选人,而不是最好的人来工作。

如果能够开发出公正的算法,招聘过程可能会变得更快、花费更少成本,而且数据可能会让招聘人员找到技能更高、更适合他们公司的人。另一个潜在的结果是:工作场所更加多样化。该软件依靠数据从各种各样的地方找到候选人,使他们的技能与工作要求相匹配,没有人为的偏见。

这可能不是完美的解决方案,事实上,在司法方面很少有完美的答案。然而,历史的弧线似乎倾向于正义,所以也许这将使正义进一步向前发展。

另一个很好的例子是自动贷款承销。与传统的人工承销相比,自动承销能更准确地预测某人是否会拖欠贷款,而且它的准确性更高,使得借款人的批准率更高,尤其是对服务水平不高的申请人来说。这样做的结果是,有时机器学习算法在做出最准确的分类方面比人类做得更好,也可以解决招聘和信贷审批等领域存在的歧视问题。

机会均等优化只是用于改进机器学习系统的众多工具之一,仅靠数学不太可能带来最佳解决方案。解决机器学习中的歧视问题最终需要采取严谨的多学科方法。

——谷歌

编译组:陈枫、徐梦瑶

相关链接:

https://towardsdatascience.com/machine-learning-and-discrimination-2ed1a8b01038

如需转载,请后台留言,遵守转载规范ACL2018论文集50篇解读

EMNLP2017论文集28篇论文解读

2018年AI三大顶会中国学术成果全链接

ACL2017 论文集:34篇解读干货全在这里

10篇AAAI2017经典论文回顾

标签:类型 美的 阶段 tps 不兼容 其它 评分 直接 不为

原文地址:https://blog.51cto.com/15057819/2567778