标签:官方 info center 架构 资源 ted 用户 功能 ssl

scrapy框架学习----------初识

Scrapy,Python开发的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

安装:pip install scrapy

因为安装scrapy需要相应的库支持,如果安装不成功,可以分步安装。

1、安装wheel

pip install wheel

2、安装lxml

https://pypi.python.org/pypi/lxml/4.5.1

3、安装pyopenssl

https://pypi.python.org/pypi/pyOpenSSL/19.1.0

4、安装Twisted

https://www.lfd.uci.edu/~gohlke/pythonlibs/

5、安装pywin32

https://sourceforge.net/projects/pywin32/files/

6、安装scrapy

pip install scrapy

1.调度器(Scheduler):

调度器,说白了把它假设成为一个URL(抓取网页的网址或者说是链接)的优先队列,由它来决定下一个要抓取的网址是 什么,同时去除重复的网址(不做无用功)。用户可以自己的需求定制调度器。

2.下载器(Downloader):

下载器,是所有组件中负担最大的,它用于高速地下载网络上的资源。

3. 爬虫(Spider):

爬虫,是用户最关心的部份。用户定制自己的爬虫(通过定制正则表达式等语法),用于从特定的网页中提取自己需要的信息。

4. 管道(ItemPipeline):

管道,用于处理爬虫(spider)提取的信息。主要的功能是持久化信息、验证信息的有效性、清除不需要的信息。

6.Scrapy引擎(Scrapy Engine):

Scrapy引擎是整个框架的核心.它用来控制调试器、下载器、爬虫。控制着整个流程。

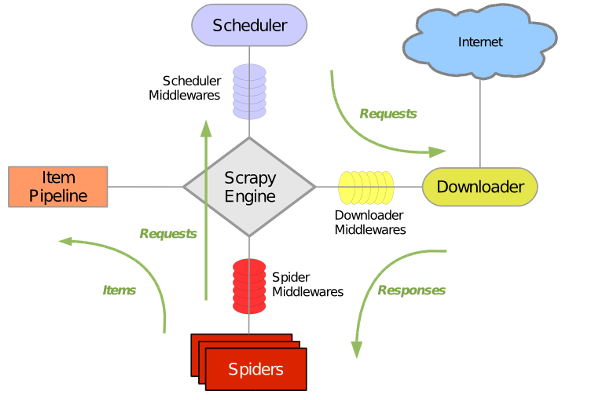

官方架构图

Scrapy运行流程大概如下:

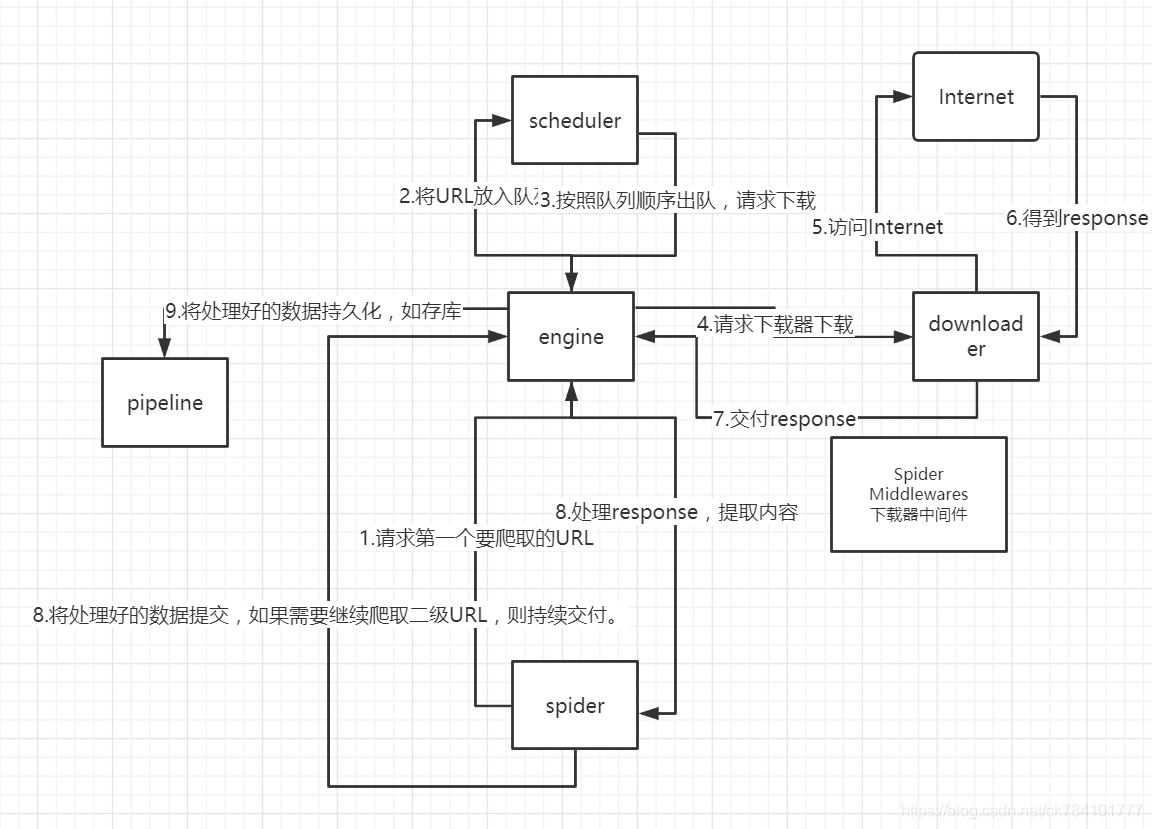

1.引擎从调度器中取出一个链接(URL)用于接下来的抓取

2.引擎把URL封装成一个请求(Request)传给下载器

3.下载器把资源下载下来,并封装成应答包(Response)

4.爬虫解析Response

5.解析出数据(Item),则交给实体管道进行进一步的处理

6.解析出的是链接(URL),则把URL交给调度器等待抓取

找了张别人画的图

标签:官方 info center 架构 资源 ted 用户 功能 ssl

原文地址:https://www.cnblogs.com/gostClimbers/p/14323130.html