标签:线性回归 img 算法 目录 idt 图片 调整 info 没有

模型误差 = 偏差(Bias) + 方差(Variance) + 不可避免的误差

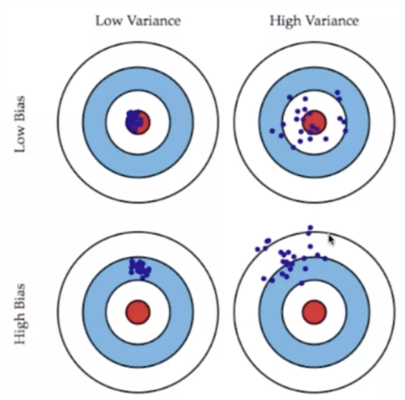

偏差方差权衡

Bias Variance Trade off

导致偏差的主要原因:对问题本身的假设不正确!

如:非线性数据 使用线性回归

欠拟合

数据的一点点扰动都会较大地影响模型。模型没有完全的学习到问题的实质,而学习到了很多噪音。

通常原因:使用的模型太复杂。

如:高阶多项式回归。

过拟合。

有一些算法天生是高方差的算法。如kNN。

非参数学习通常都是高方差算法。因为不对数据进行任何假设

有一些算法天生是高偏差算法。如线性回归。

参数学习通常都是高偏差算法。因为堆数据具有极强的假设。

大多数算法具有相应的参数,可以调整偏差和方差;

如kNN中的k,线性回归中使用多项式回归。

偏差和方差通常是矛盾的。

在算法层面,机器学习的主要挑战,来自于方差。解决高方差的通常手段:

标签:线性回归 img 算法 目录 idt 图片 调整 info 没有

原文地址:https://www.cnblogs.com/fldev/p/14370758.html