标签:分析 net cond 操作 output 参数 内存 复杂 csdn

参数量以参数个数为单位,要计算内存或显存的,用参数量乘以每个参数所占的字节数即可。网络训练的快慢

计算量以计算机做乘加次数为单位,即完成某个操作,需要执行多少次乘法和加法操作。计算设备需要多大的内存或显存。

计算量:

FLOPS:注意全大写,是floating point operations per second的缩写,意指每秒浮点运算次数,理解为计算速度。是一个衡量硬件性能的指标。

FLOPs:注意s小写,是floating point operations的缩写(s表复数),意指浮点运算数,理解为计算量。可以用来衡量算法/模型的复杂度。

本问题针对模型,应指的是FLOPs。以下答案不考虑activation function的运算。

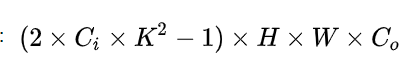

卷积层:

Ci=input channel, k=kernel size, HW=output feature map size, Co=output channel.

2是因为一个MAC算2个operations。不考虑bias时有-1,有bias时没有-1。

上面针对一个input feature map,没考虑batch size。

理解上面这个公式分两步,括号内是第一步,计算出output feature map的一个pixel,然后再乘以HWCo拓展到整个output feature map。

括号内的部分又可以分为两步,Ci*k^2 + Ci*k^2-1 第一项是乘法运算数,第二项是加法运算数,因为n个数相加,要加n-1次,所以不考虑bias,会有一个-1,如果考虑bias,刚好中和掉,括号内变为2*Ci*k^2

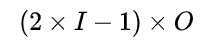

全联接层:

I=input neuron numbers, O=output neuron numbers.2是因为一个MAC算2个operations。不考虑bias时有-1,有bias时没有-1。

分析同理,括号内是一个输出神经元的计算量,拓展到O了输出神经元。

参数量:

CNN网络的参数量和特征图的尺寸无关,仅和卷积核的大小,偏置及BN有关,

对于卷积张量,权重参数量为

,偏置参数量为

,如果使用了BN,那么还有两个可学习参数

,参数量都是

,总共

,

综上,该卷积层所有的参数量为:.

需要注意的是,上面计算的仅仅是模型的参数量,若要计算模型实际需要多少显存,还要考虑特征图的大小,

因为每一层卷积的输出都需要缓存,还要BN计算出来的均值和偏差也需要缓存,权重的梯度也需要缓存。通常模型参数所占用的显存比例很小。

参考:

https://www.zhihu.com/question/65305385/answer/451060549

https://blog.csdn.net/xuefengyang666/article/details/94734491

标签:分析 net cond 操作 output 参数 内存 复杂 csdn

原文地址:https://www.cnblogs.com/tingtin/p/14440673.html