标签:nec inux sof 初始 img serve top use home

hadoop大数据集群搭建过程中,需要使用到zookeeper进行主从管理和控制,那我们就安装一套集群环境

登录zookeeper.apache.org官网,找到Getting Started下边的Download。

进去之后我们选择一个版本,比如选择3.6.2,进去后选择比较好一点的网络的地址,比如这个清华大学的HTTP链接

https://mirrors.tuna.tsinghua.edu.cn/apache/zookeeper/zookeeper-3.6.2/apache-zookeeper-3.6.2-bin.tar.gz

进入到soft文件夹,使用FTP上次到我们的Linux服务器 ,解压

tar -zxf apache-zookeeper-3.6.2-bin.tar.gz -C /bigdata/install

cd /bigdata/install

mv apache-zookeeper-3.6.2-bin/ zookeeper-3.6.2

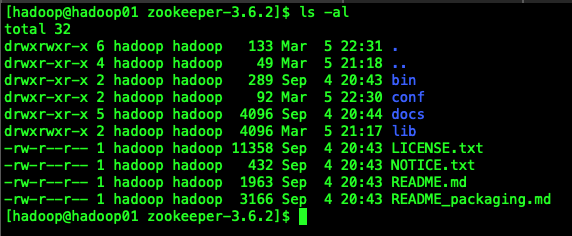

我们在zookeeper-3.6.2的文件夹下边创建一个data目录,用来存放zookeeper启动后产生的快照数据

cd /bigdata/install/zookeeper-3.6.2

mkdir data

进入到zookeeper的conf目录,复制一个配置文件

cp zoo_sample.cfg zoo.cfg

接下来我们来看一下zookeeper配置文件的信息

# The number of milliseconds of each tick

# 心跳基本事件单元,这个事件是zookeeper服务器之间保持心跳的事件间隔,每隔一个滴答时间就会发送一个心跳

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take

# 允许follower 链接并同步到Leader的初始化链接时间,10个滴答时间

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

# Leader与Follower之间发送消息时,请求和应答的时间长度,5个滴答时间

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

# 存储快照的路径

dataDir=/tmp/zookeeper

# the port at which the clients will connect

# 监听客户端连接的端口

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

#maxClientCnxns=60

# 最大可联接客户端数量,如果需要更多数量,可以调大该值

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

# http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

## Metrics Providers

#

# https://prometheus.io Metrics Exporter

#metricsProvider.className=org.apache.zookeeper.metrics.prometheus.PrometheusMetricsProvider

#metricsProvider.httpPort=7000

#metricsProvider.exportJvmInfo=true

我们对快照数据路径进行修改,修改为我们上边在zookeeper目录里创建的data文件夹

dataDir=/bigdata/install/zookeeper-3.6.2/data

在配置的最下边追加如下信息,其中2888为心跳通信端口,3888为选举通信端口

server.1=hadoop01:2888:3888

server.2=hadoop02:2888:3888

server.3=hadoop03:2888:3888

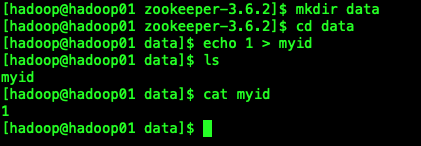

注意一定要在保存快照目录中创建一个标识文件,用来表示当前zookeeper是集群里的哪台服务

我们在上边创建的data目录,执行下边脚本

echo 1 > myid

hadoop2,hadoop3机器上的这个文件要修改成我们上边配置的2,3

将配置文件分发到集群其他机器上

scp -r zookeeper-3.6.2/ hadoop2:$PWD

scp -r zookeeper-3.6.2/ hadoop3:$PWD

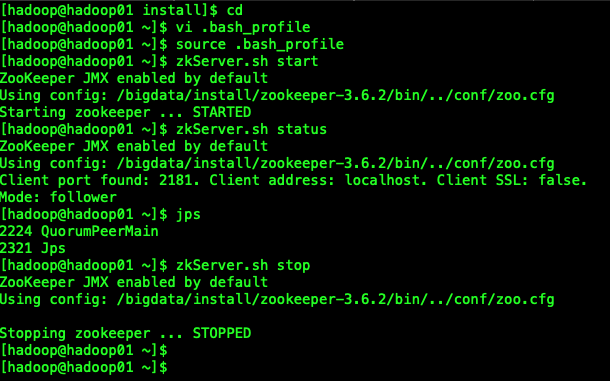

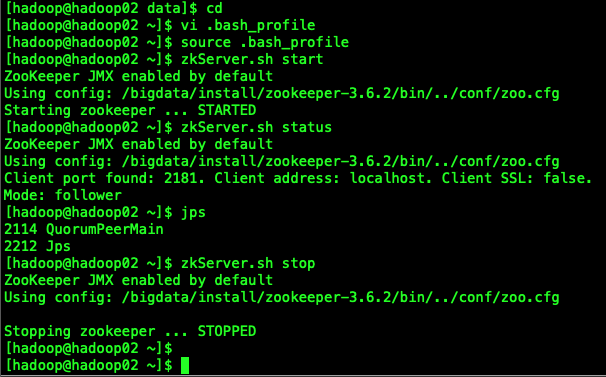

在3台机器上都要配置环境变量,使zookeeper命令生效

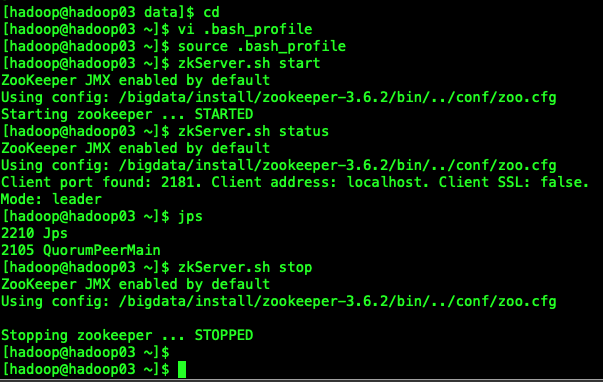

cd ~

vi .bash_profile

在bash_profile文件中添加zookeeper的安装目录信息

export ZOOKEEPER_HOME=/bigdata/install/zookeeper-3.6.2

export PATH=$PATH:$ZOOKEEPER_HOME/bin

生效bash_profile文件

source .bash_profile

我们在3台机器上分别执行下边的命令,进行启动并查看节点的状态

启动:zkServer.sh start

停止:zkServer.sh stop

查看状态:zkServer.sh status

查看java进程:jps

标签:nec inux sof 初始 img serve top use home

原文地址:https://www.cnblogs.com/tenic/p/14488981.html